HAN Minor DevOps - Moderne ICT-technieken

Quick links

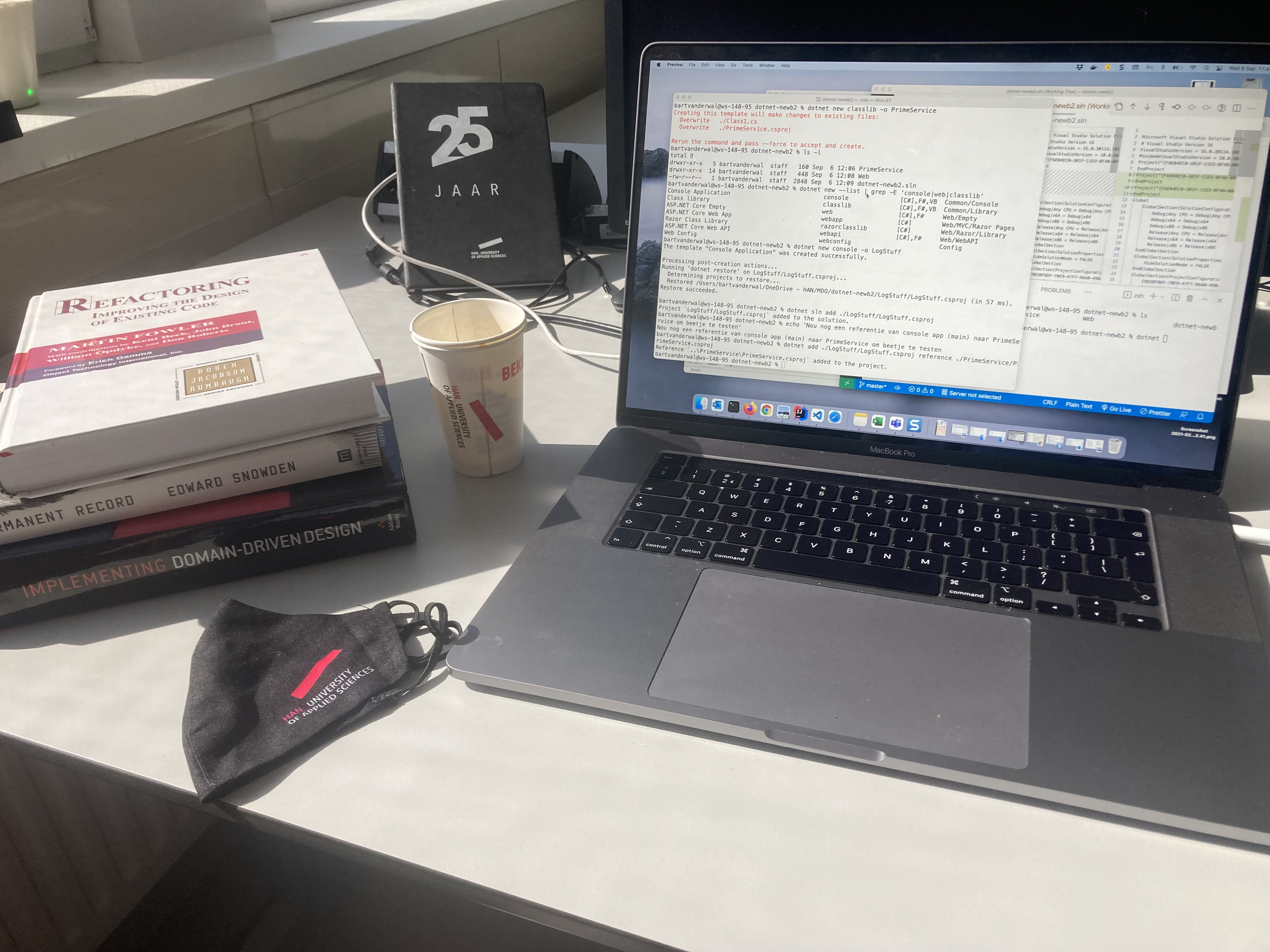

Figuur 1: Promo video minor DevOps HAN i.s.m. InfoSupport

Course codes:

- MINDEC05 - Minor DevOps - Course DevOps (15 EC) - iSAS

- MINDEP01 - Minor DevOps - Project (15 EC) - iSAS

Inleiding

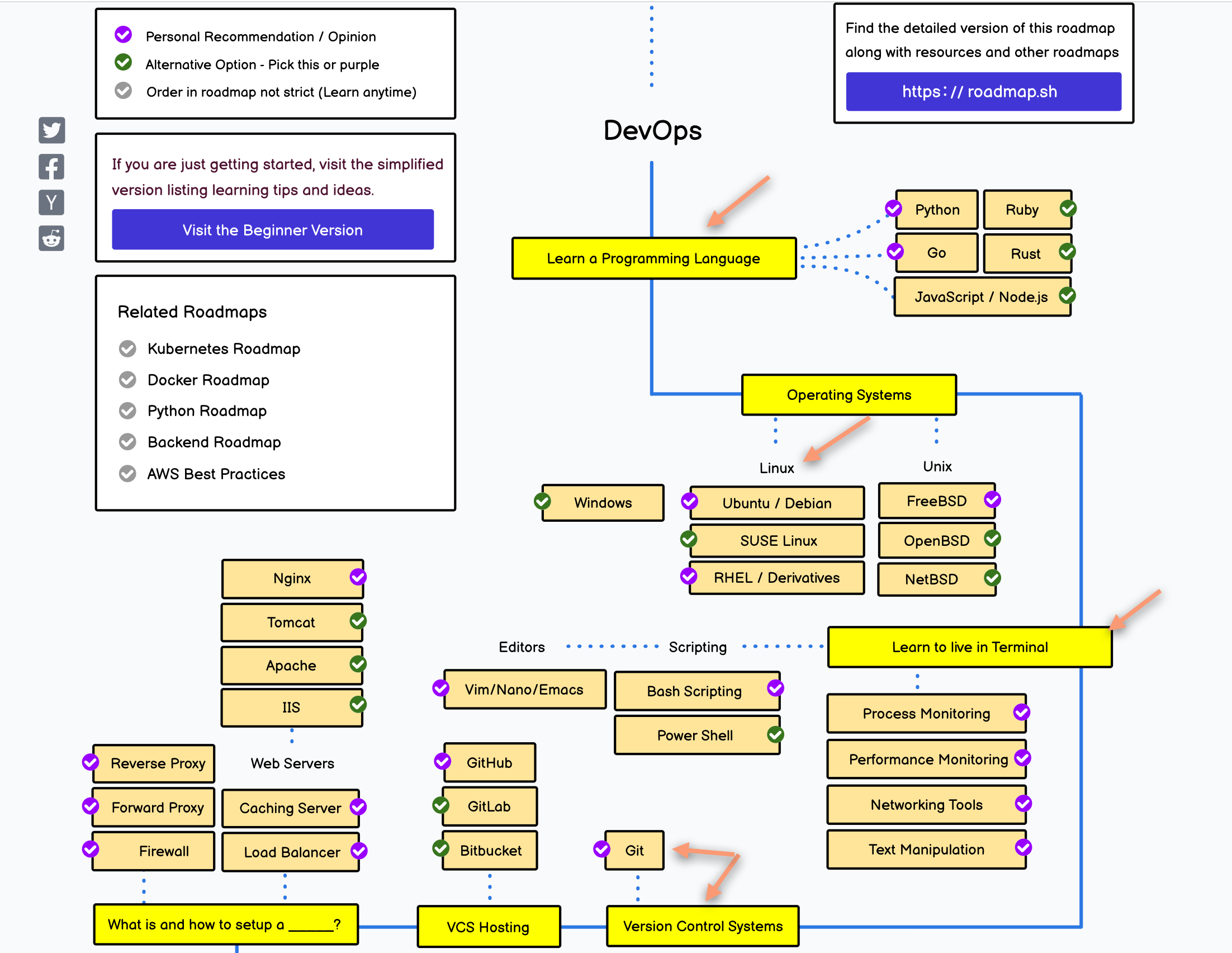

In deze minor leren ICT-studenten moderne ICT-technieken voor Continuous Delivery volgens een DevOps aanpak. Studenten werken in teamverband aan de ontwikkeling van een geïntegreerd softwareproduct, waarbij zowel de software en de onderliggende software-architectuur, als de infrastructuur (hardware), en de architectuur en configuratie daarvan aan bod komen.

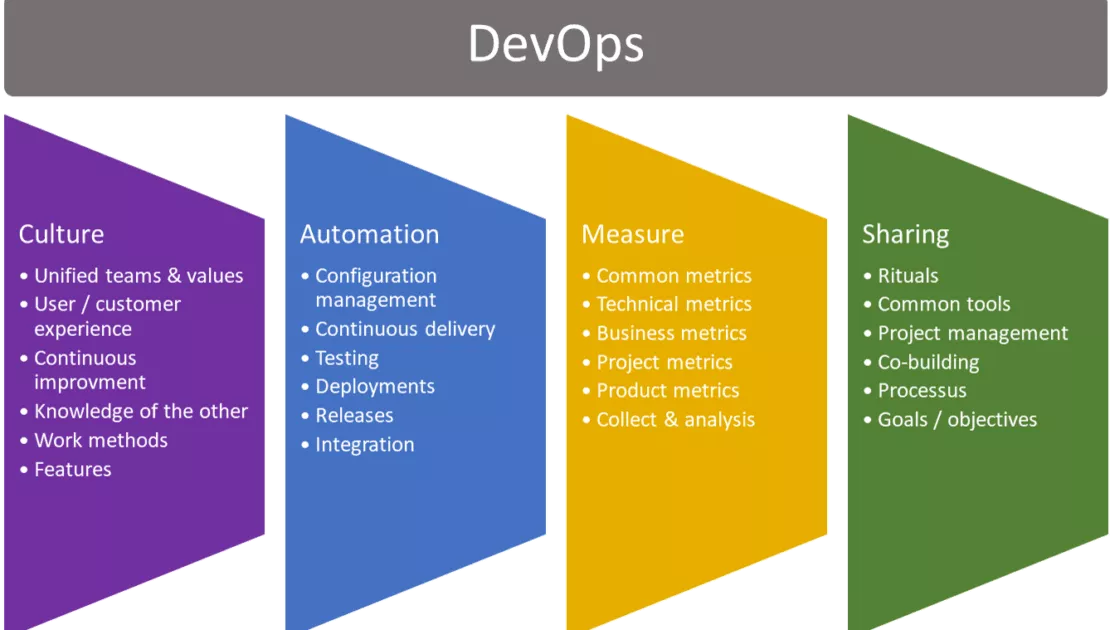

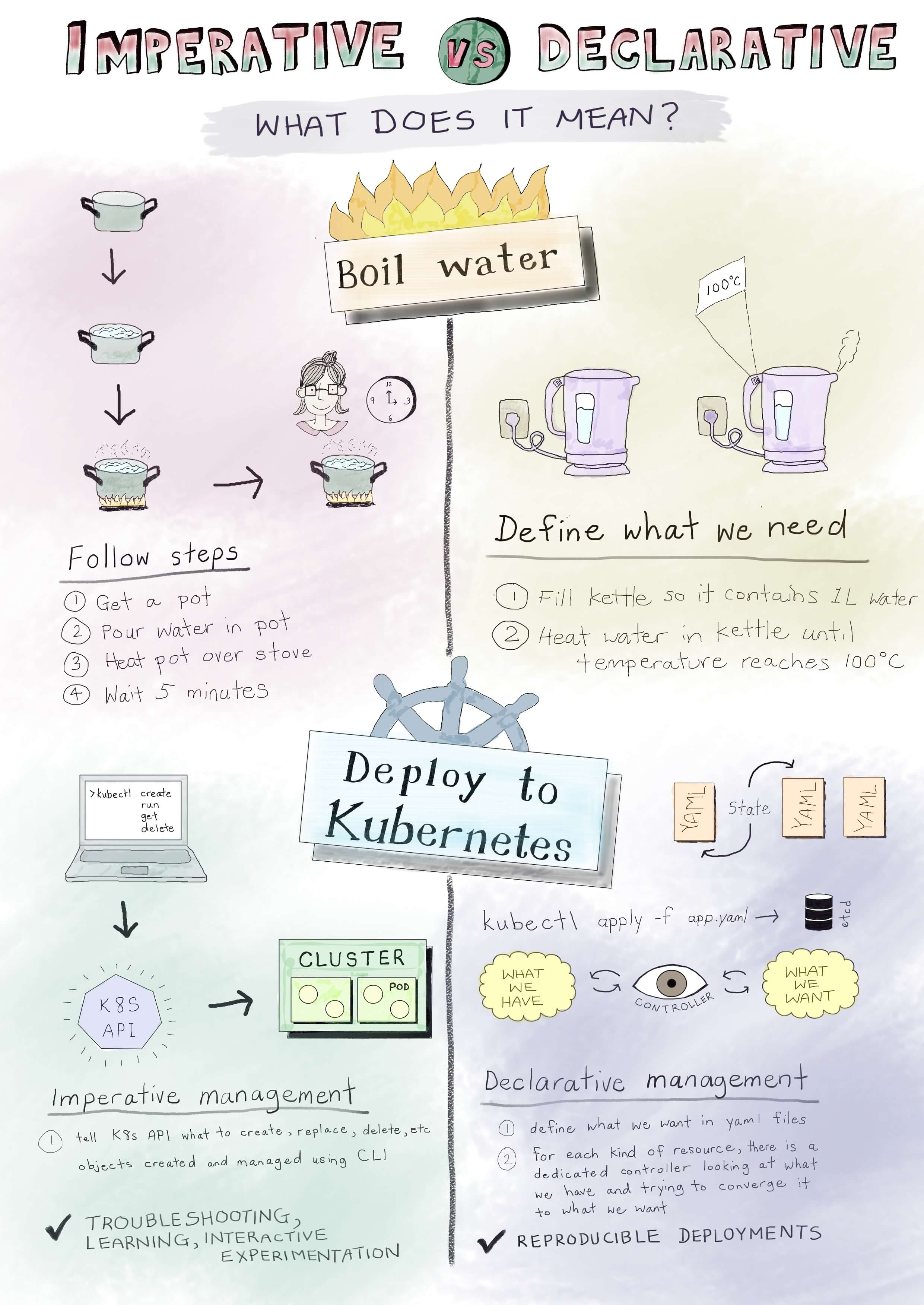

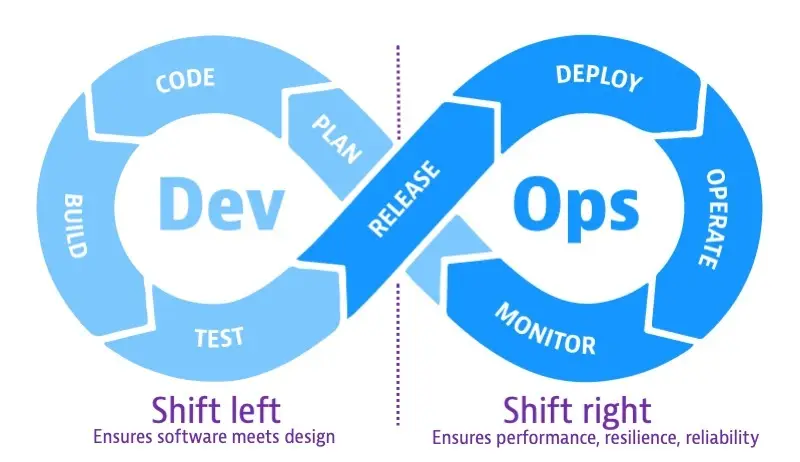

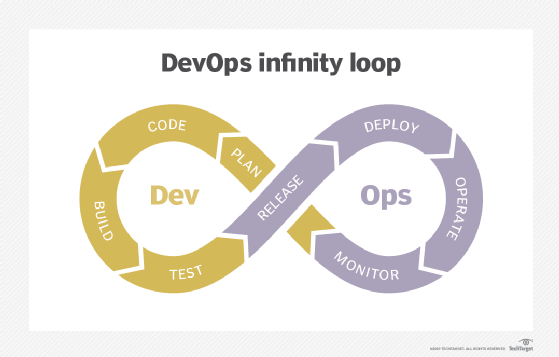

🤝 DevOps en Samenwerking

Studenten leren applicaties te ontwikkelen door middel van een containerized aanpak. Deze aanpak maakt het mogelijk om veel operationele processen te automatiseren, te werken vanuit een gedeelde backlog en op grotere schaal oude silo's te doorbreken. Het doel hiervan is een snellere 'time to market' te realiseren (shift left). DevOps staat hierbij centraal als een manier van samenwerken: DevOps is cooperation.

🎯 Focus op Non-functional Requirements

Naast functionaliteit voor eindgebruikers, wordt er in deze minor ook gekeken naar non-functionele eisen (NFR's), zoals schaalbaarheid, betrouwbaarheid en onderhoudbaarheid. Deze non-functionele eisen worden soms ook wel 'quality attributes' (QA's) genoemd, omdat goede prestaties vaak essentieel zijn voor de eindgebruiker (performance as a feature).

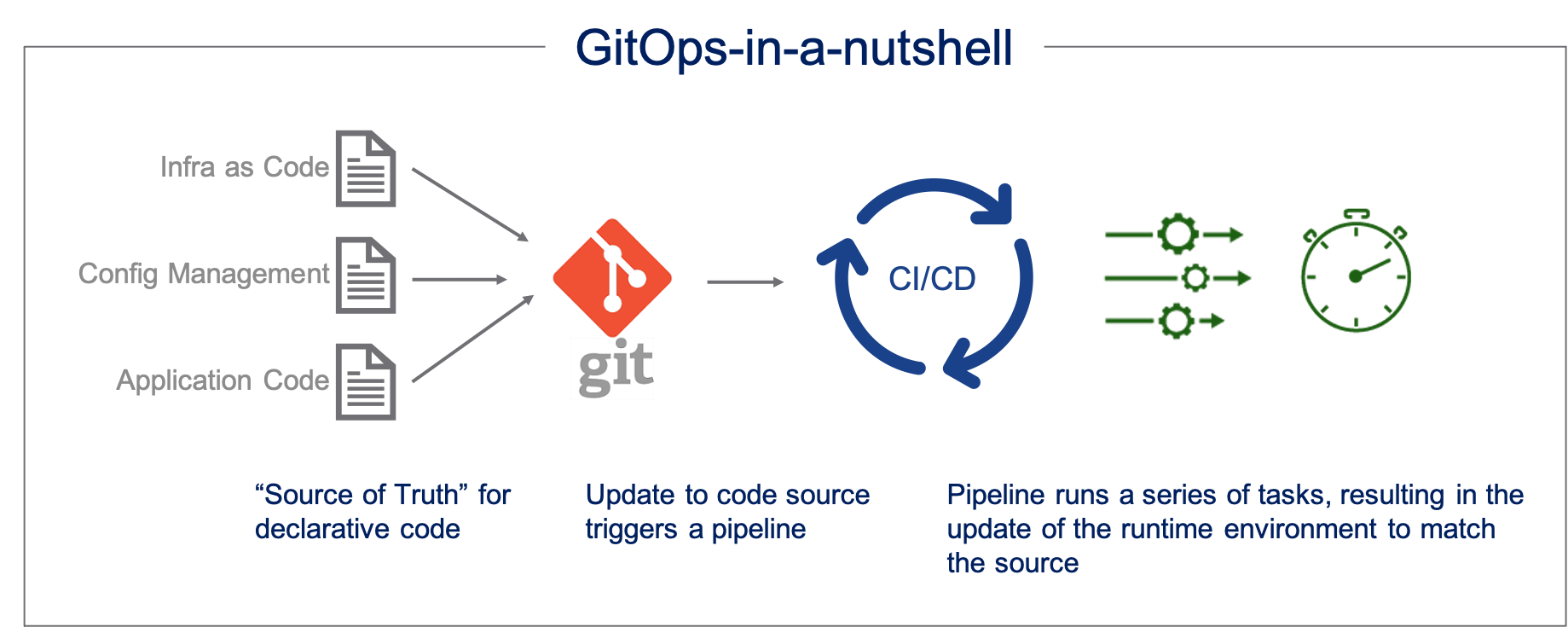

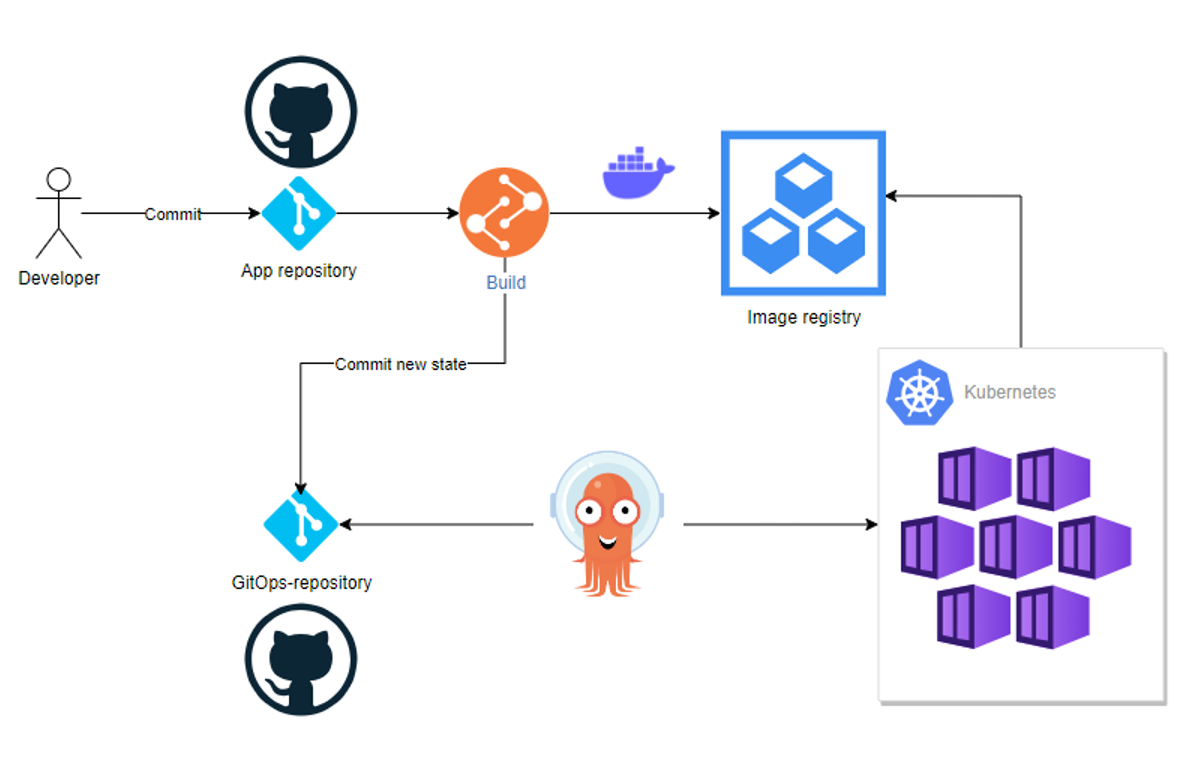

🚀 Opzetten van Deployment Pipelines

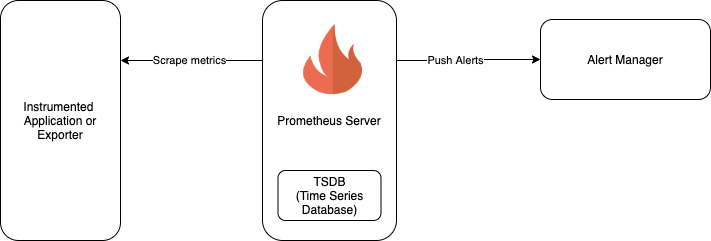

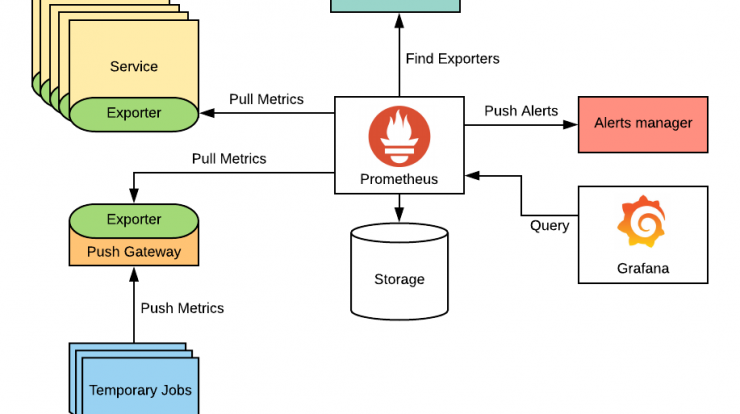

Studenten leren een DevOps-proces opzetten en werken met een CI/CD pipeline voor geautomatiseerde deployment naar productie- en andere runtime-omgevingen, gebaseerd op de 'desired state' in versiebeheer (GitOps). Deze efficiënte en frequente updates maken ook een betere focus op beveiliging mogelijk (DevSecOps). Daarnaast verbetert goede logging en monitoring (SlackOps) het zicht op prestaties, het vroegtijdig detecteren van fouten en zelfs het volgen van bedrijfsdoelen. Dit gebeurt door middel van applicatiespecifieke KPI's en tools die helpen bij het monitoren van de naleving van gemaakte afspraken (SLA's - Service Level Agreement).

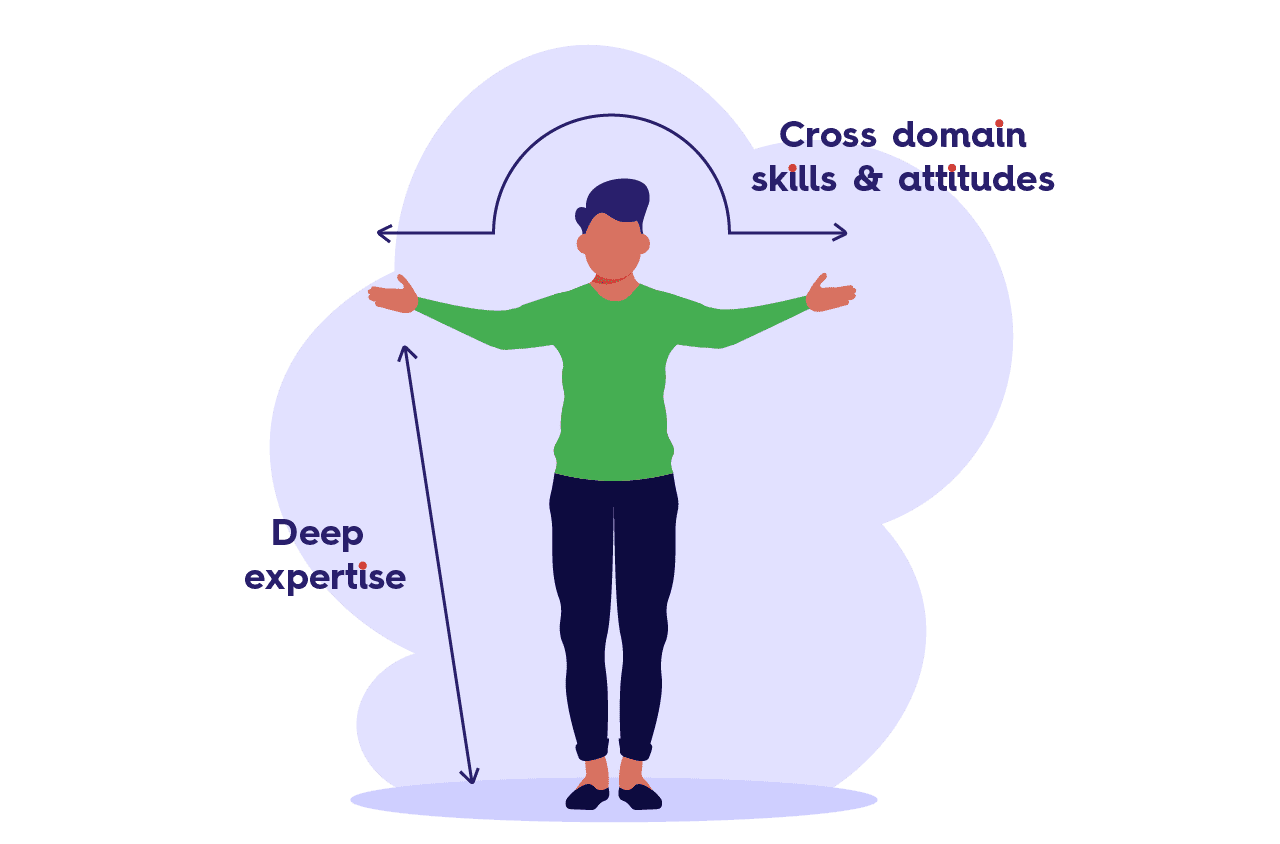

📈 Ontwikkelen als "T-shaped Professional"

Deze minor biedt zowel verdieping als verbreding. De instroom is beperkt tot ICT-studenten met een achtergrond in Operations (Infrastructuur, Security) of Development (Software-, Web-, of Data Solutions Development). Alle studenten verbreden hun kennis door elkaars vakgebieden te leren begrijpen en interdisciplinair samen te werken. Tegelijkertijd verdiepen ze zich verder in hun eigen specialisatie door te leren werken met moderne technieken zoals containers, cloud providers, microservices en Agile systeemontwikkeling.

Figuur 3: 'T-shaped DevOps professional' ([

plaatje: agilescrumgroup.com

Kies op maat

Hieronder een kopie van de informatie die op kiesopmaat.nl staat, of zou moeten staan ;). De inschrijving voor de minor is jaarlijks in maart (1e kans) en mei (2e kans) en verloopt via kiesopmaat.nl of minoren-han.nl.

Meldt je ook aan via het aanmeldformulier van InfoSupport - onze bedrijfspartner in de minor.

DevOps (voltijd)

In deze multidisciplinaire minor staat de moderne techniek DevOps centraal. In een DevOps-team werken developers en beheerders samen om nieuwe features van een applicatie te ontwikkelen, en tegelijkertijd de bestaande features draaiende te houden.

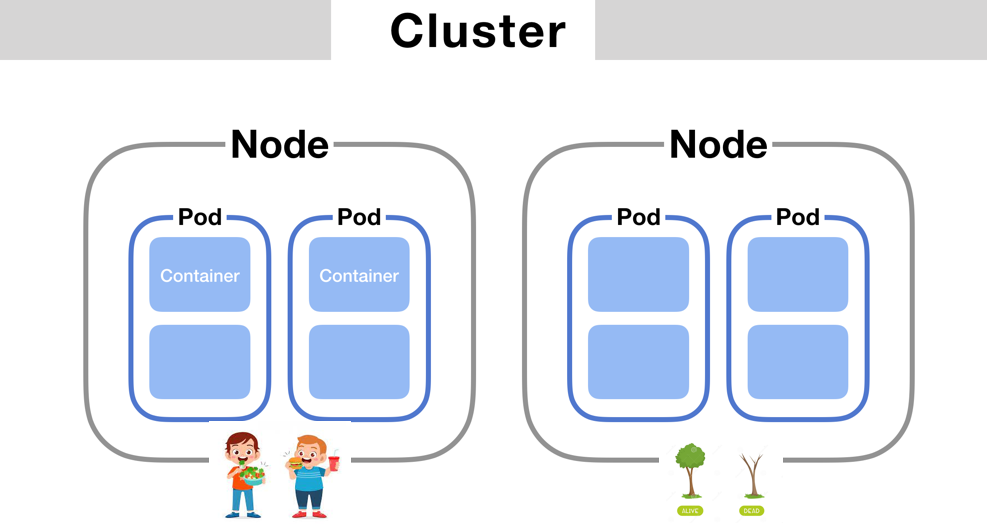

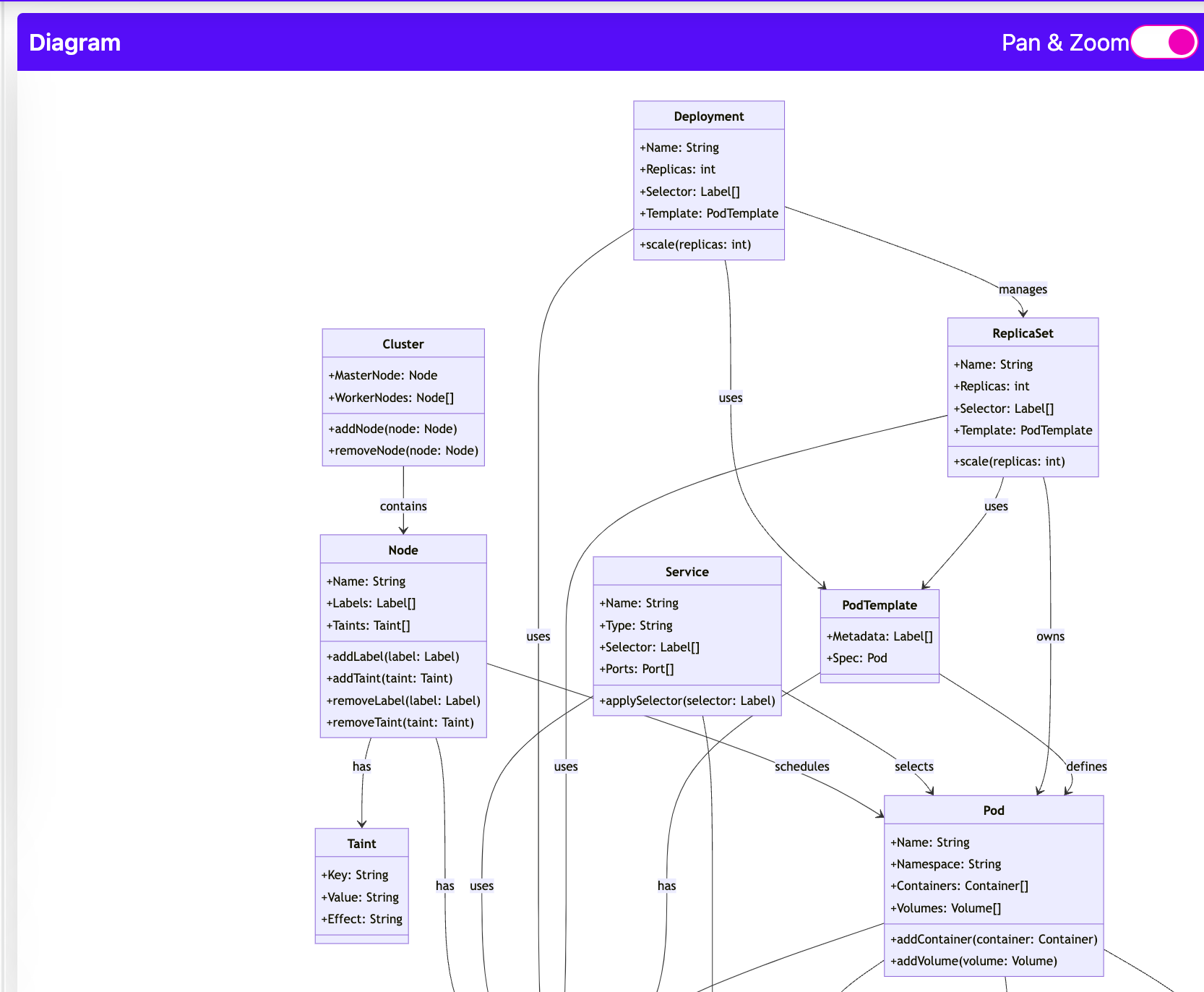

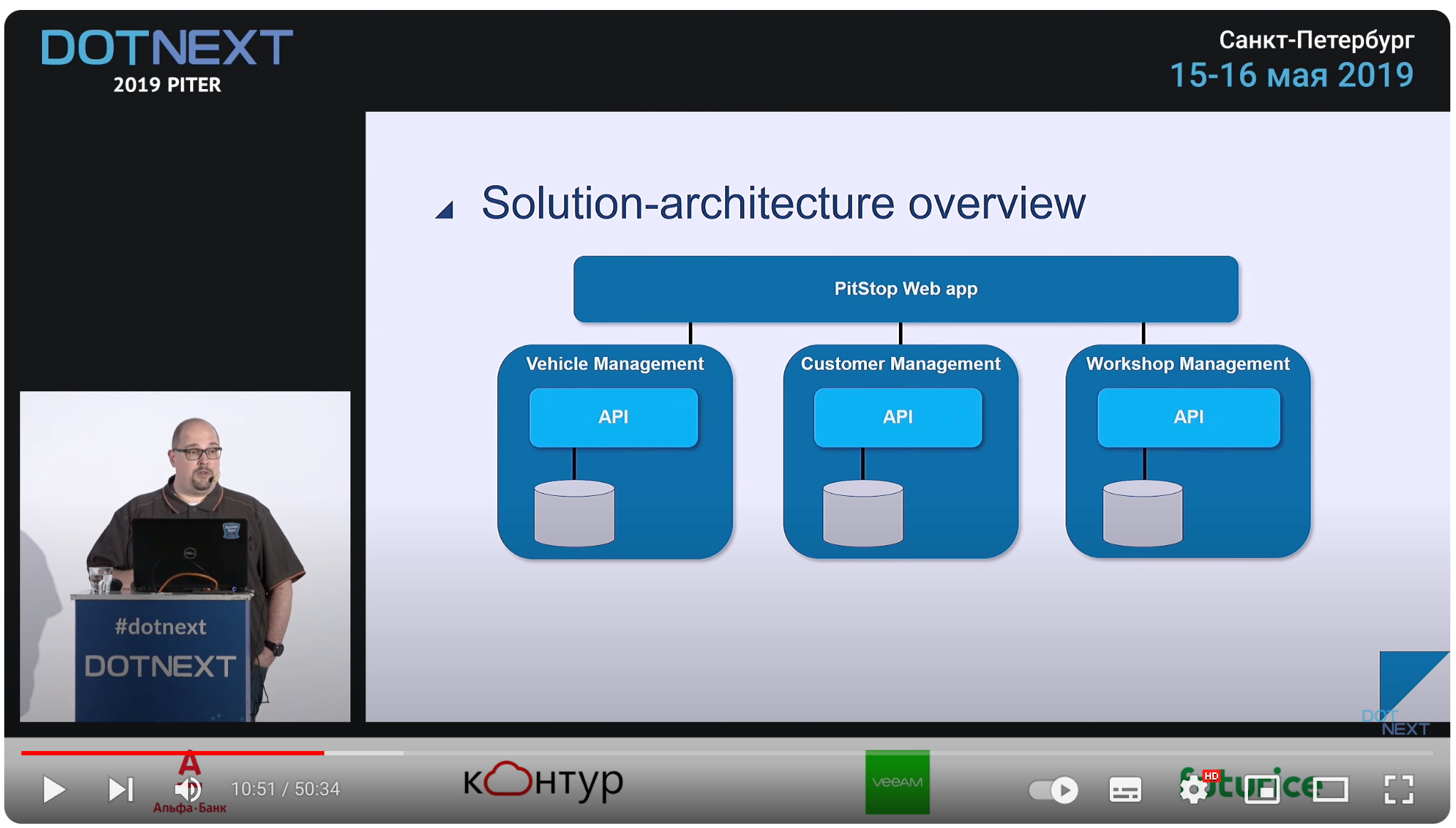

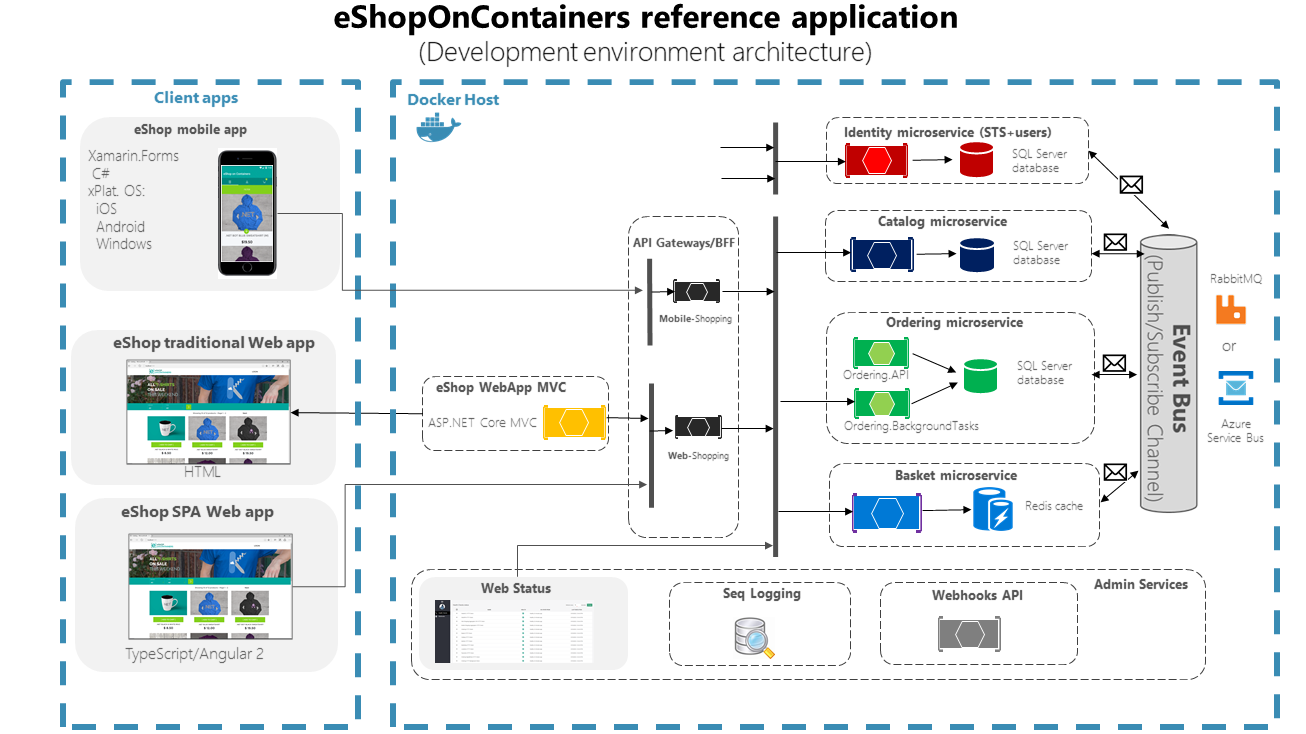

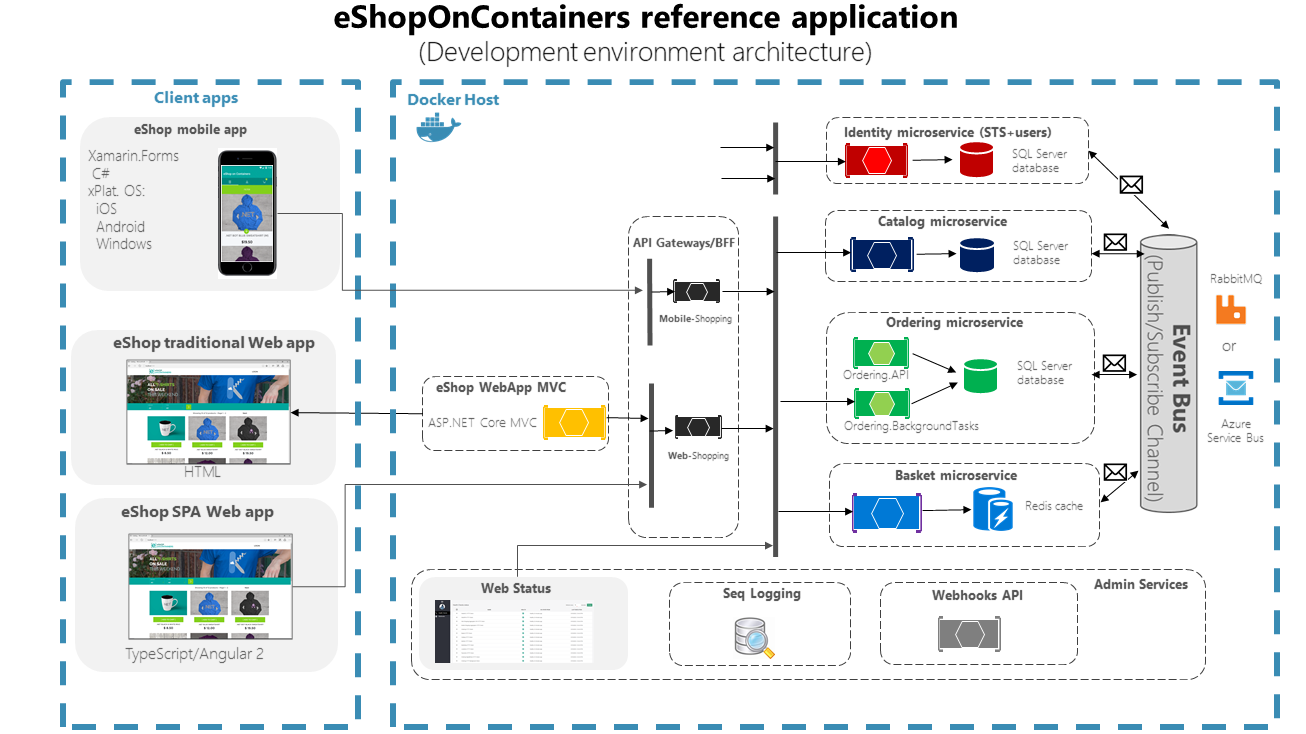

Hierbij is er veel aandacht voor het garanderen van een hoge beschikbaarheid van een applicatie. We gaan kijken naar loosely coupled microservices, event-carried state transfer, Docker, Kubernetes, RabbitMQ, unit testen, acceptatie testen, build- en release-pipelines, logging, monitoring, site reliability engineering, kort-cyclisch development en natuurlijk de samenwerking tussen Dev en Ops. De minor bestaat uit twee gedeelten: een gedeelte met theorie en een kleinschalig project waarin zowel je theoretische als praktische kennis wordt voorbereid op het tweede deel: het uitvoeren van een grootschalig project voor een echte klant waarbij je je expertise optimaal kunt benutten. Beide delen worden verzorgd door de HAN en Info Support samen, waarbij de HAN vooral in het eerste en Info Support vooral in het tweede deal de lead zal nemen in de begeleiding.

De minor is alleen toegankelijk voor HBO studenten met een Software Engineering of Development profiel en voldoende studiepunten. Zie verder onder ‘ingangseisen’. Tijdens het project in blok 2 moet je mogelijk een Non Disclosure Agreement (NDA) tekenen en een OV kaart of eigen vervoer hebben i.v.m. ca. een dag per week in Utrecht of andere externe locatie buiten de HAN/Arnhem.

Afhankelijk van je instroom profiel besteed je tijdens deze minor verder aandacht aan de volgende onderwerpen:

- Deployment-tooling (CD/CI-tools, containerization, container orchestration)

- Management en beheer (configuration management, monitoring, logging, cloud providers)

- Test- en Behaviour Driven Development (TDD/BDD)

- Web- en applicatieservers

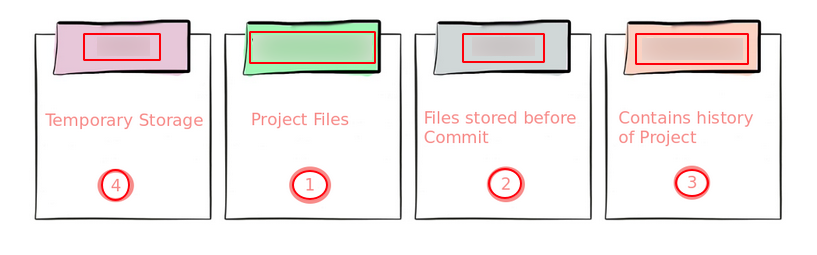

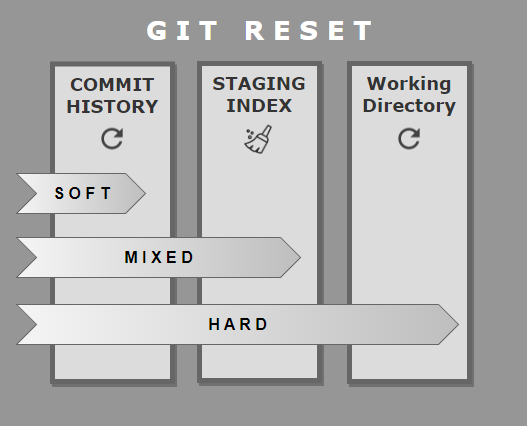

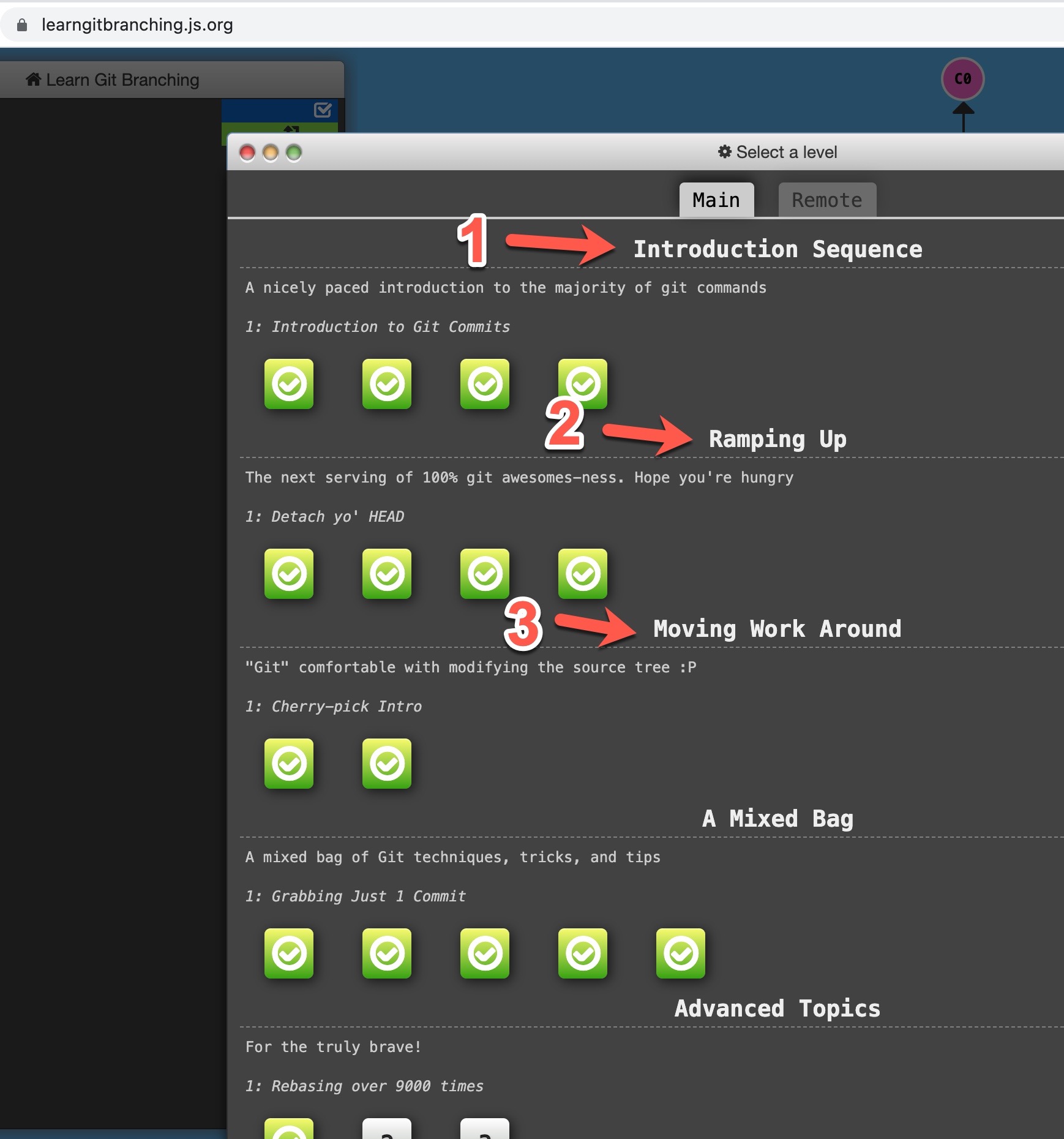

- Versiebeheer (git) en workflows hierin

- Operating system (linux)

- Netwerken, security en protocollen

- Proxies, load balancers, firewalls

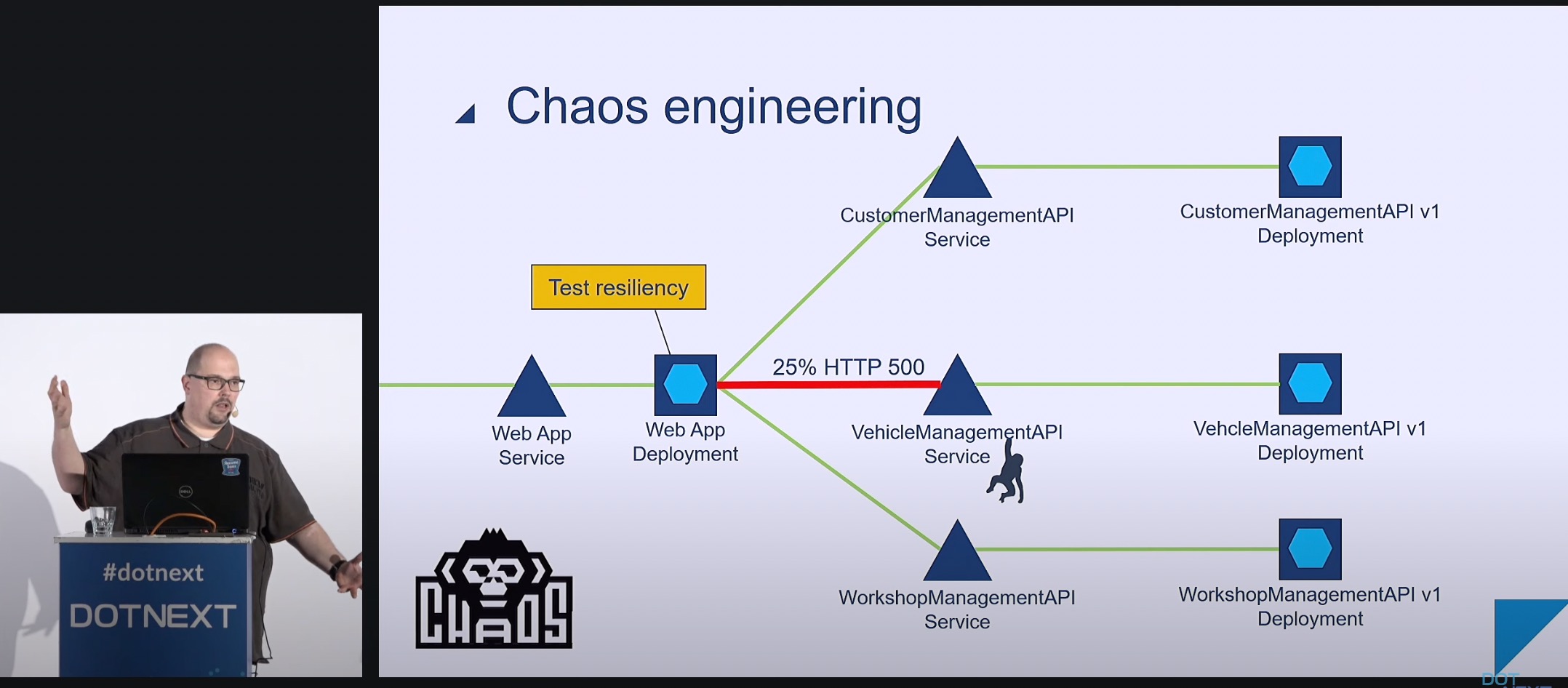

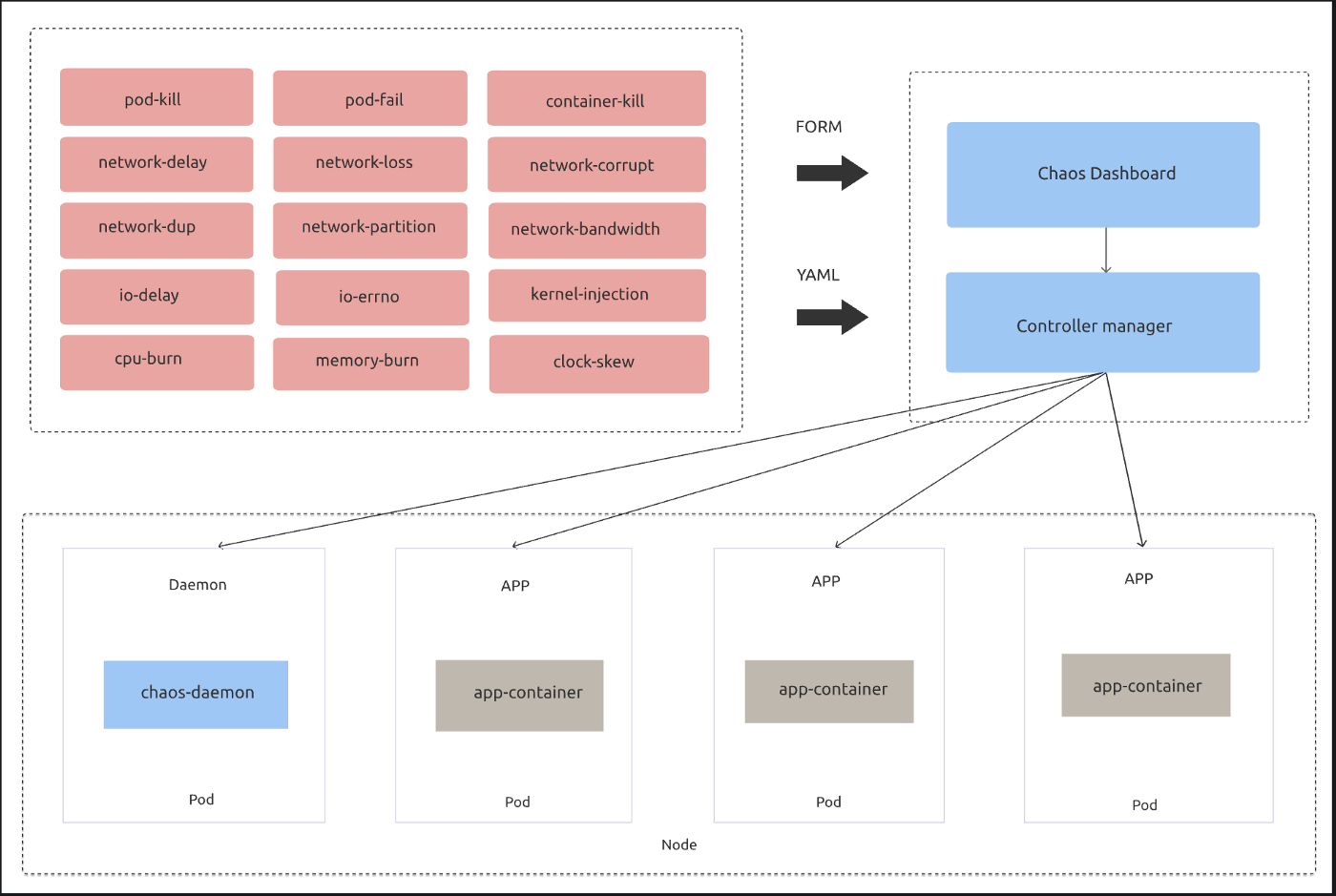

- Chaos engineering, load testing

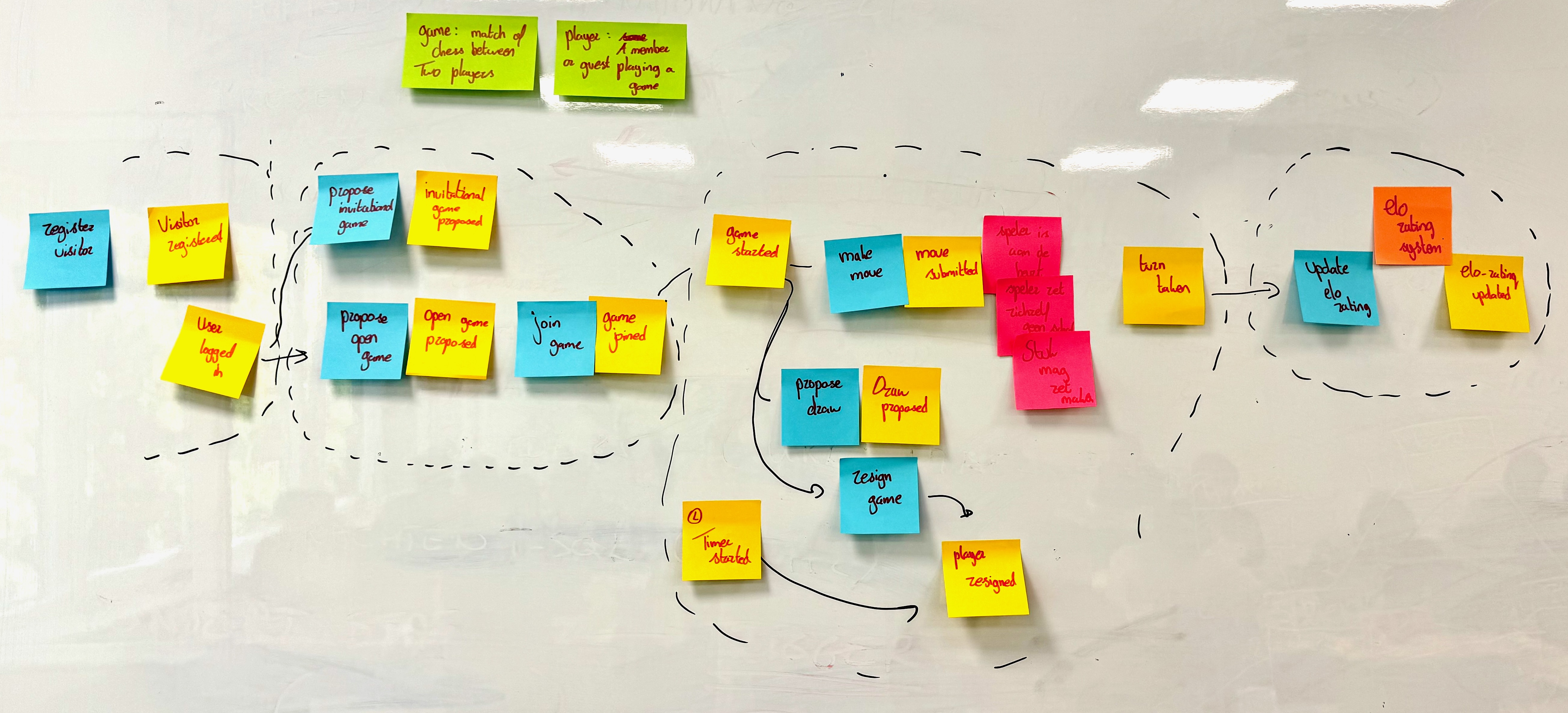

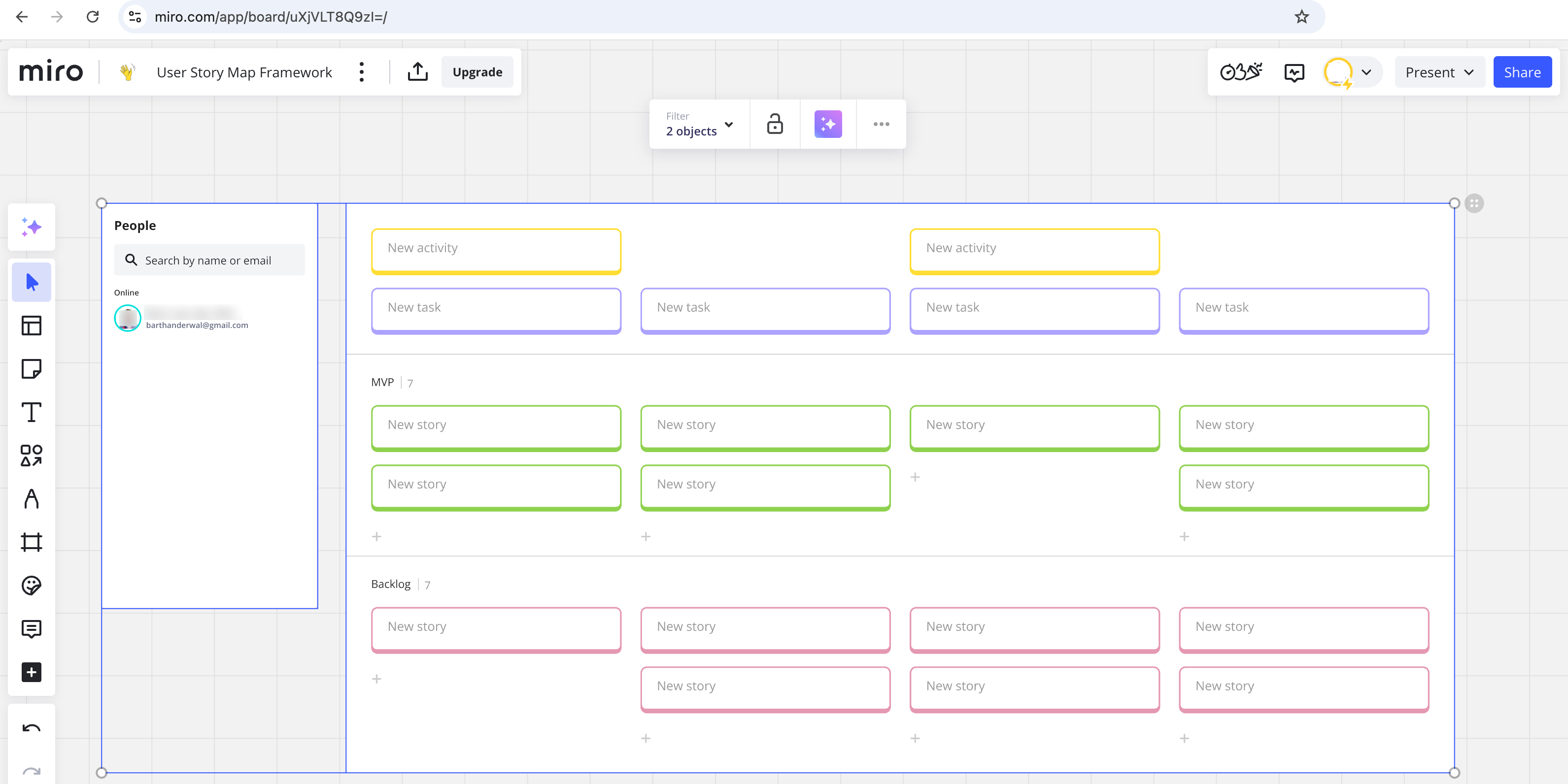

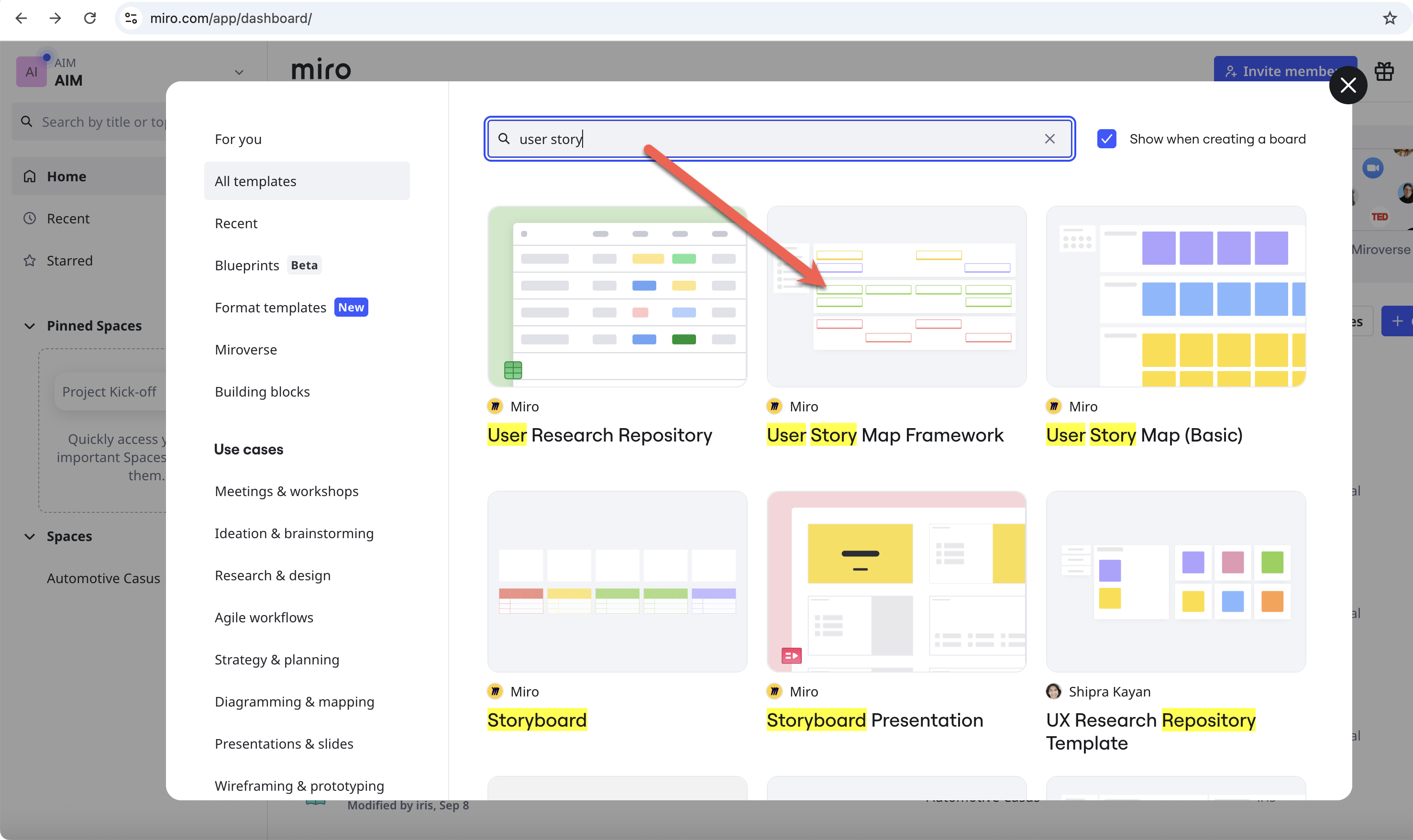

- Agile practices als story mapping

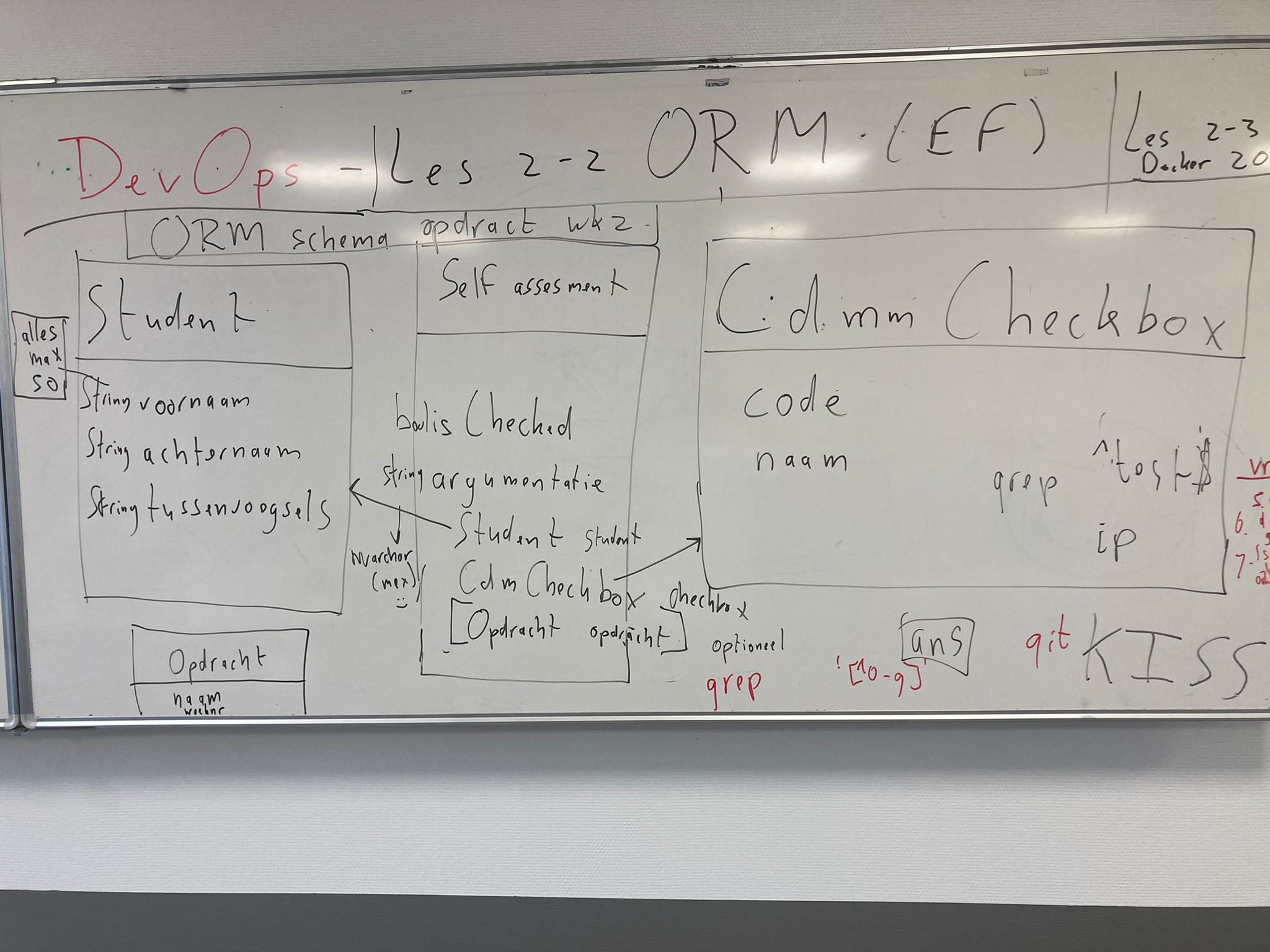

- DevOps specialisatie van developers bijvoorbeeld ORM, REST en (Domain driven) design en design patterns

- DevOps specialisatie voor infrastructuur specialisten zoals RBAC, log aggregation en Infrastructure as Code (IaC)

Leerdoelen

Na het volgen van deze minor beschik je over de theoretische kennis en praktische vaardigheden om in een professionele organisatie een project uit te voeren met Continuous Delivery door een DevOps aanpak in te voeren en te hanteren.

Ingangseisen

De minor is alleen toegankelijk voor HBO ICT studenten met een development profiel.

Vanwege het verdiepende karakter van de minor moet je ook een 4-e jaars student zijn. We gaan er dus van uit dat je bij aanvang van de minor je (meeloop) stage en verdiepende semester hebt afgerond. Op het moment van inschrijven voor de minor is dit idealiter ook zo, of ben je je verdiepende semester of (meeloop)stage aan het afronden.

Tijdens het project in blok 2 moet je mogelijk een Non Disclosure Agreement (NDA) tekenen en een OV kaart of eigen vervoer hebben i.v.m. ca. een dag per week in Utrecht of andere externe locatie buiten de HAN/Arnhem.

Inhoudelijk gelden verder de onderstaand eisen over je voorkennis en vaardigheden. Deze heb je nodig om tijdens de minor verder uit te bouwen of om mee te kunnen werken in het beroepsproduct aan het eind van de course fase, of het DevOps project in blok 2. Voor het toetsen van het instapniveau verzoeken we ook aangemelde studenten voor aanvang van de minor thuis een digitale ingangstoets te maken. Deze toets geeft jezelf een concreter beeld van de vereiste voorkennis en of je hier nog gaten in hebt. Verder is bij twijfel over toelating, omdat je nog te weinig studiepunten hebt, deze toets ook een mogelijkheid alsnog toegelaten te worden.

- Je kunt object georienteerd programmeren in een getypeerde taal en kent enkele OO design patterns en kan deze herkennen en toepassen (OO)

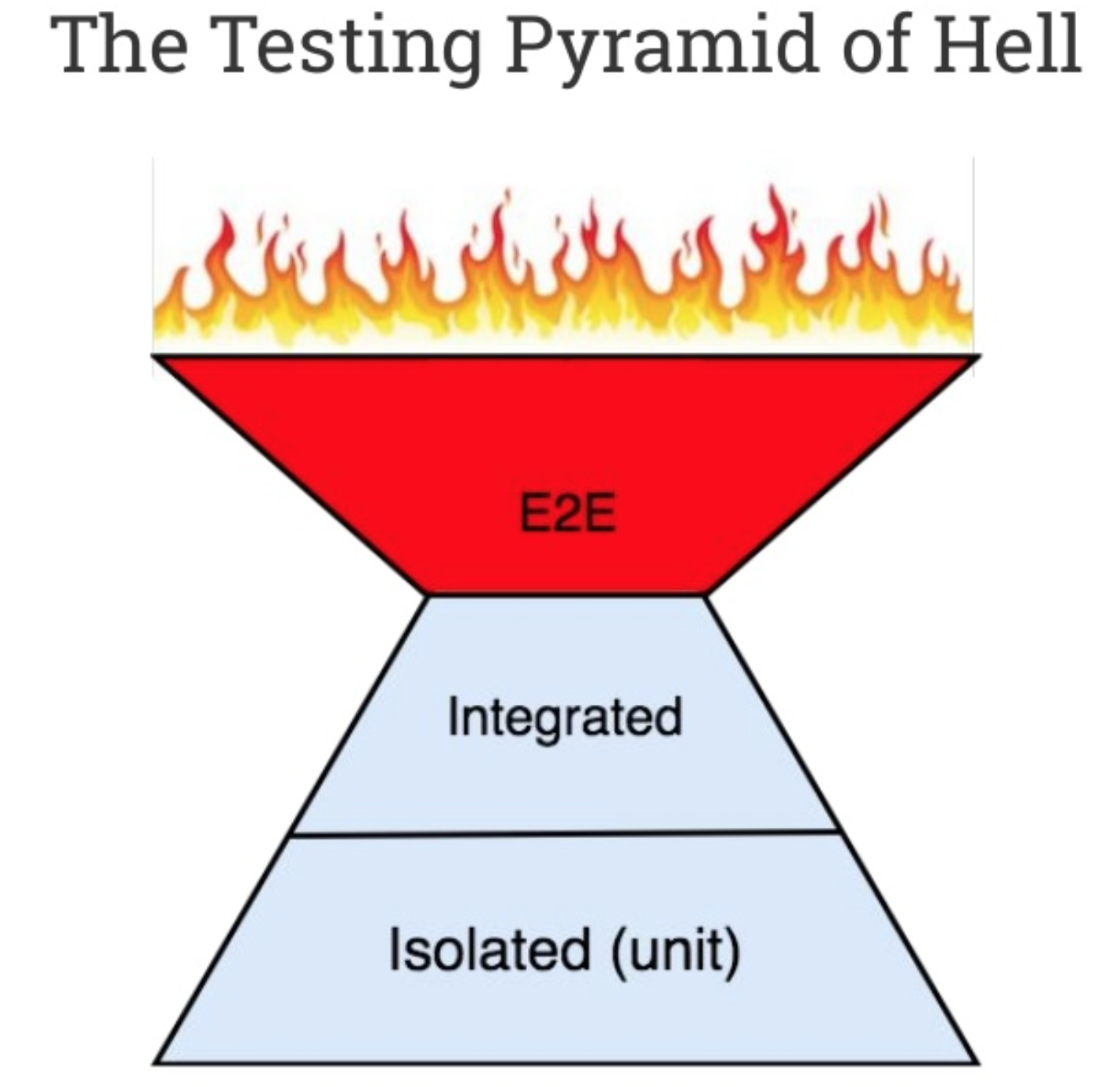

- Je kunt geautomatiseerde unit en integratie tests schrijven met gebruikmaking van een test framework en -tool (Unit testing)

- Je kunt ontwikkelen volgens Test Driven Development en kent TDD patterns als Red-Green-Refactor, Arrange, Act, Assert en concepten als sut, mocks, stubs, etc. (TDD)

- Je kent de werking van web protocollen als HTTP en DNS en dataformaten als XML en JSON

- Je kent de standaard 3-tier architectuur en principes van andere gelaagde architecturen

- Je kent een aantal basis UML technieken en kan requirements documentatie en technische documentatie opstellen

Rooster

- Er wordt vanuit gegaan dat studenten van maandag t/m vrijdag beschikbaar zijn, dus bijbaantjes of andere vakken van maandag t/m vrijdag (9.00-17.45 uur) volgen is geen optie.

Tijdens het project in het 2e blok ben je verder 1 of 2 dagen per week op locatie bij de opdrachtgever. Dit kan ook buiten Arnhem zijn, afgelopen jaar was dit bijvoorbeeld in Utrecht (vlakbij CS). Uitgangspunt is dat je OV kaart hebt.

De roostering zal plaatsvinden zoals bij de Academie IT & Mediadesign gebruikelijk: in de coursefase (MINDEC05) zes maal per week een dagdeel les, en in de projectfase (MINDEP01) 40 uur per week projectwerk.

Werkvormen

- Werkcolleges

- Projectopdracht

Toetsing

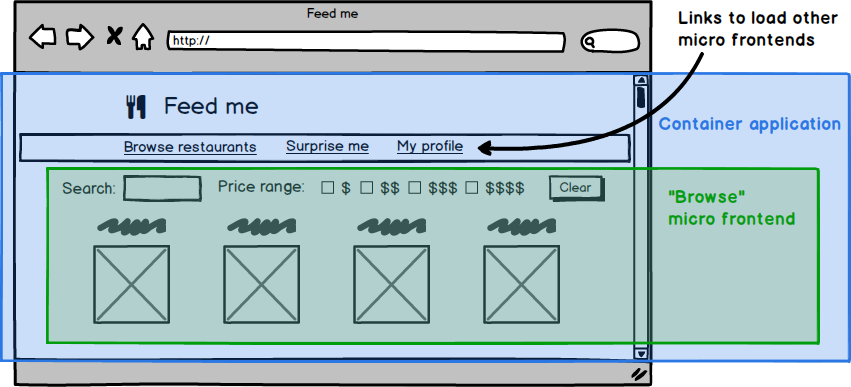

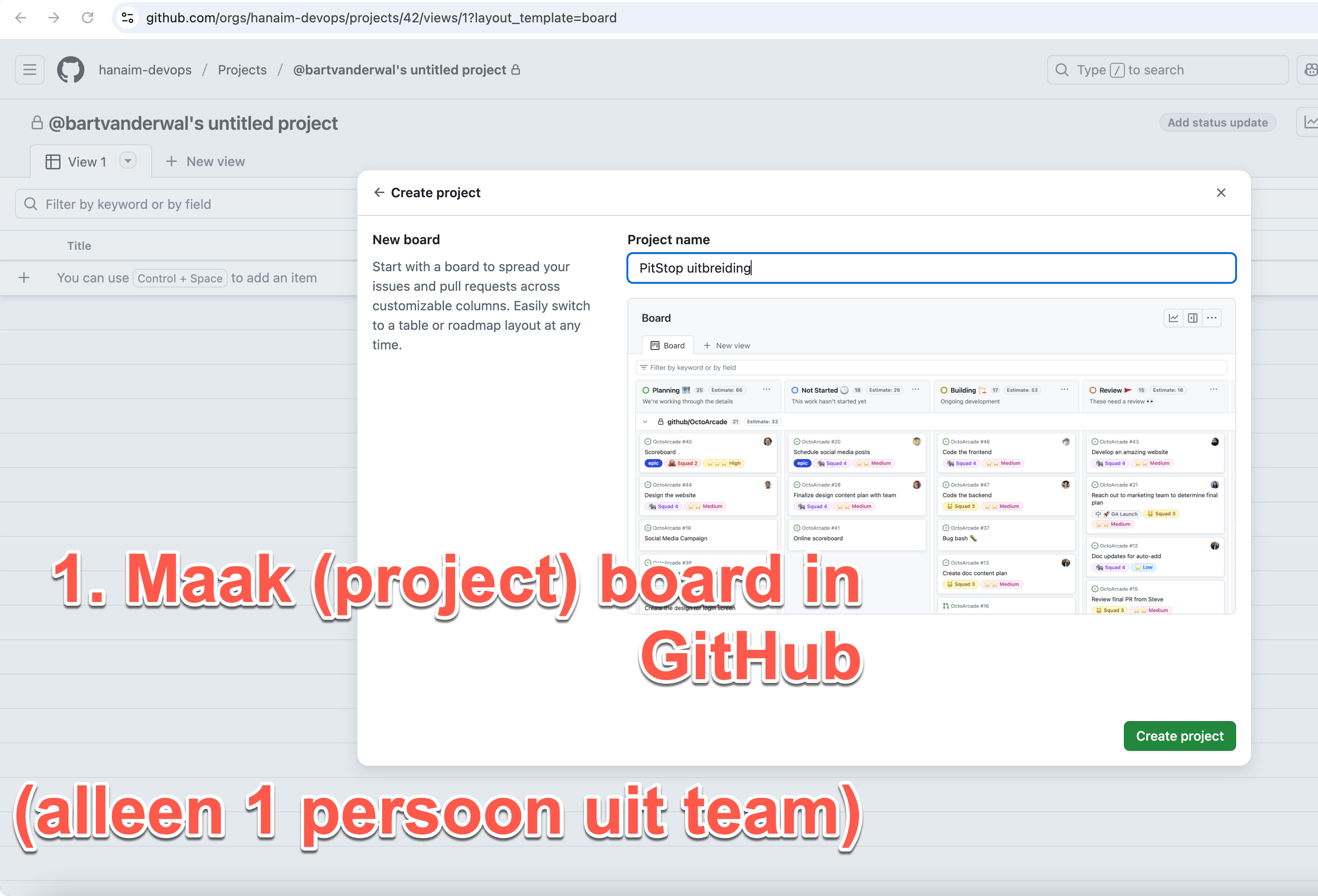

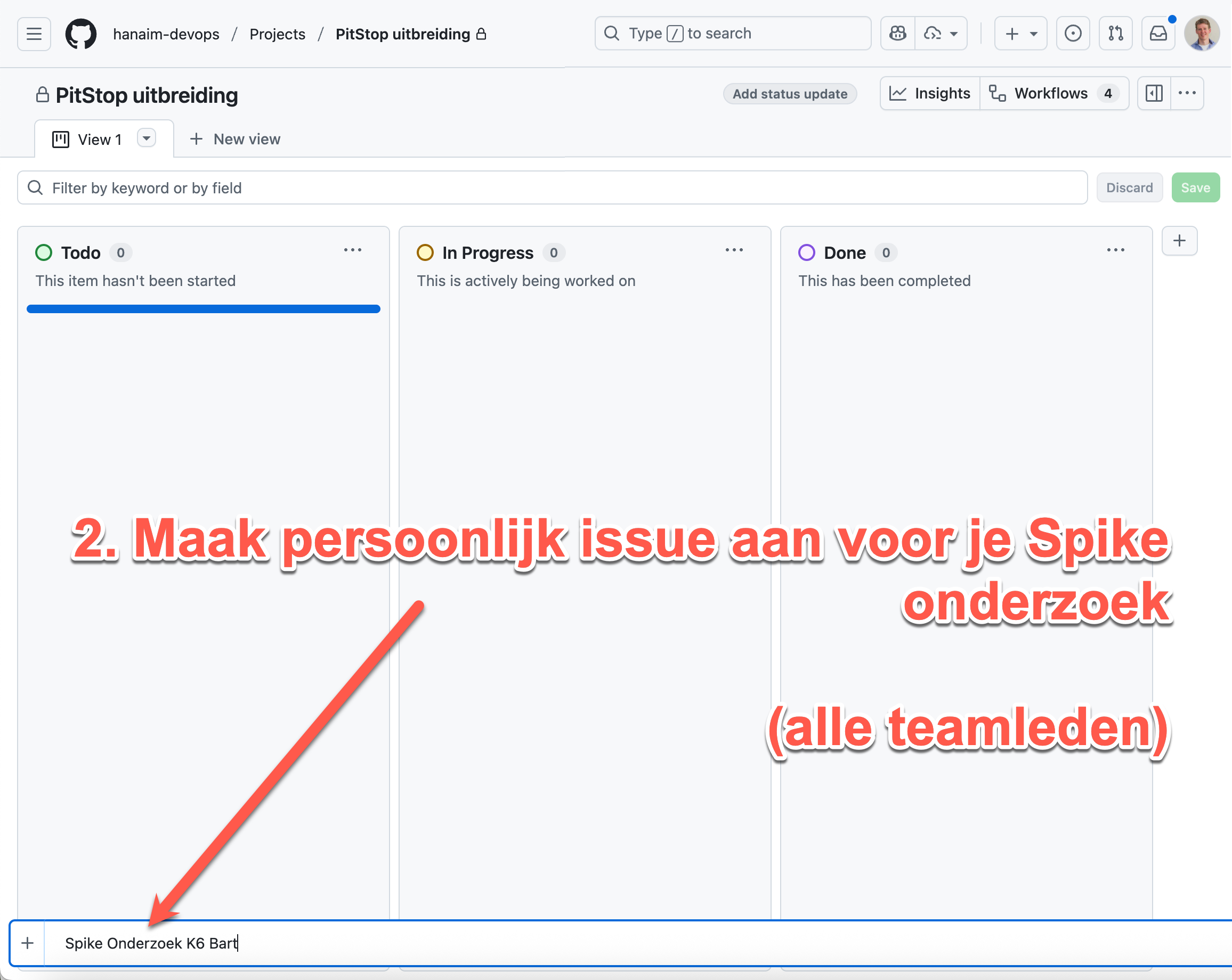

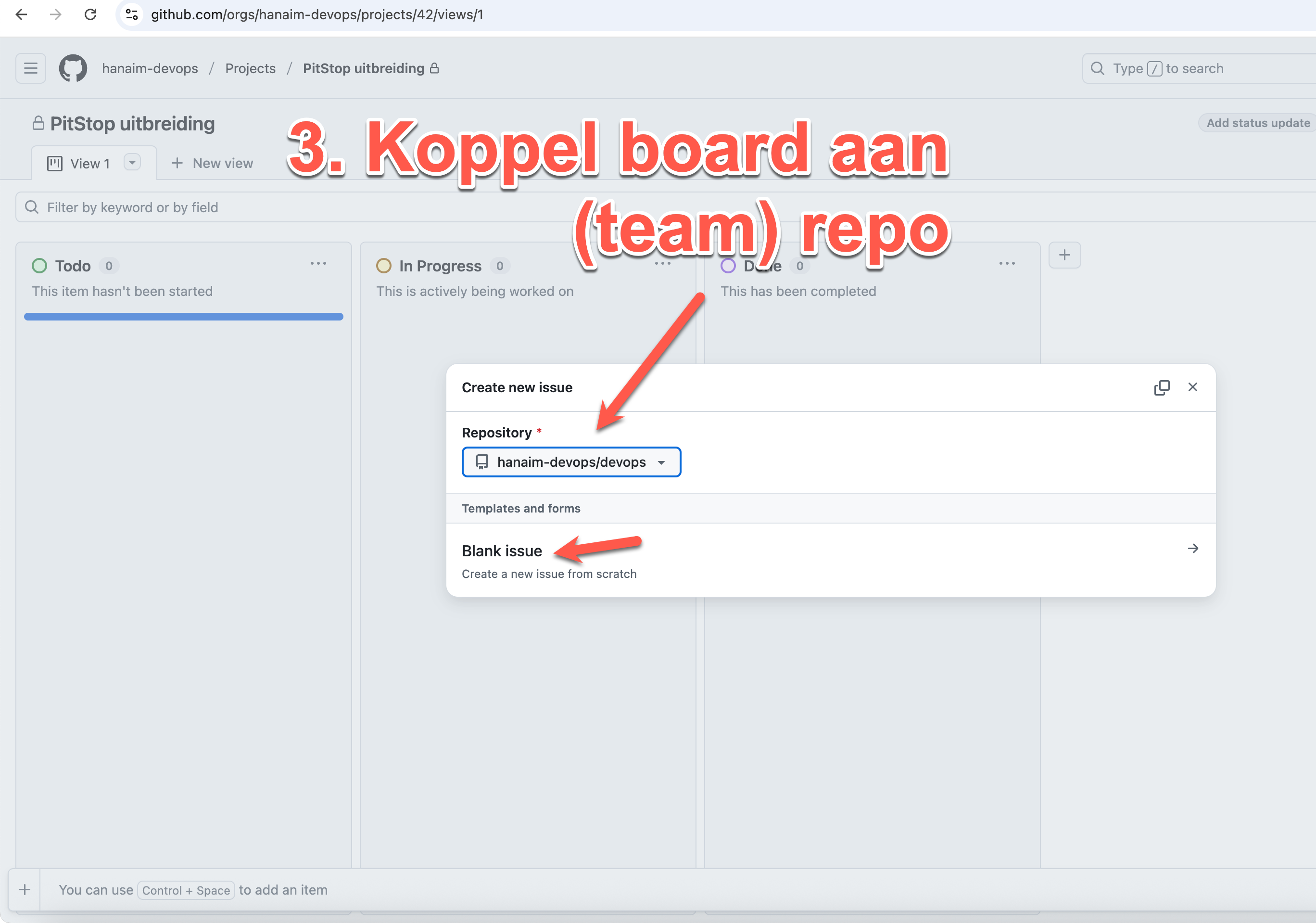

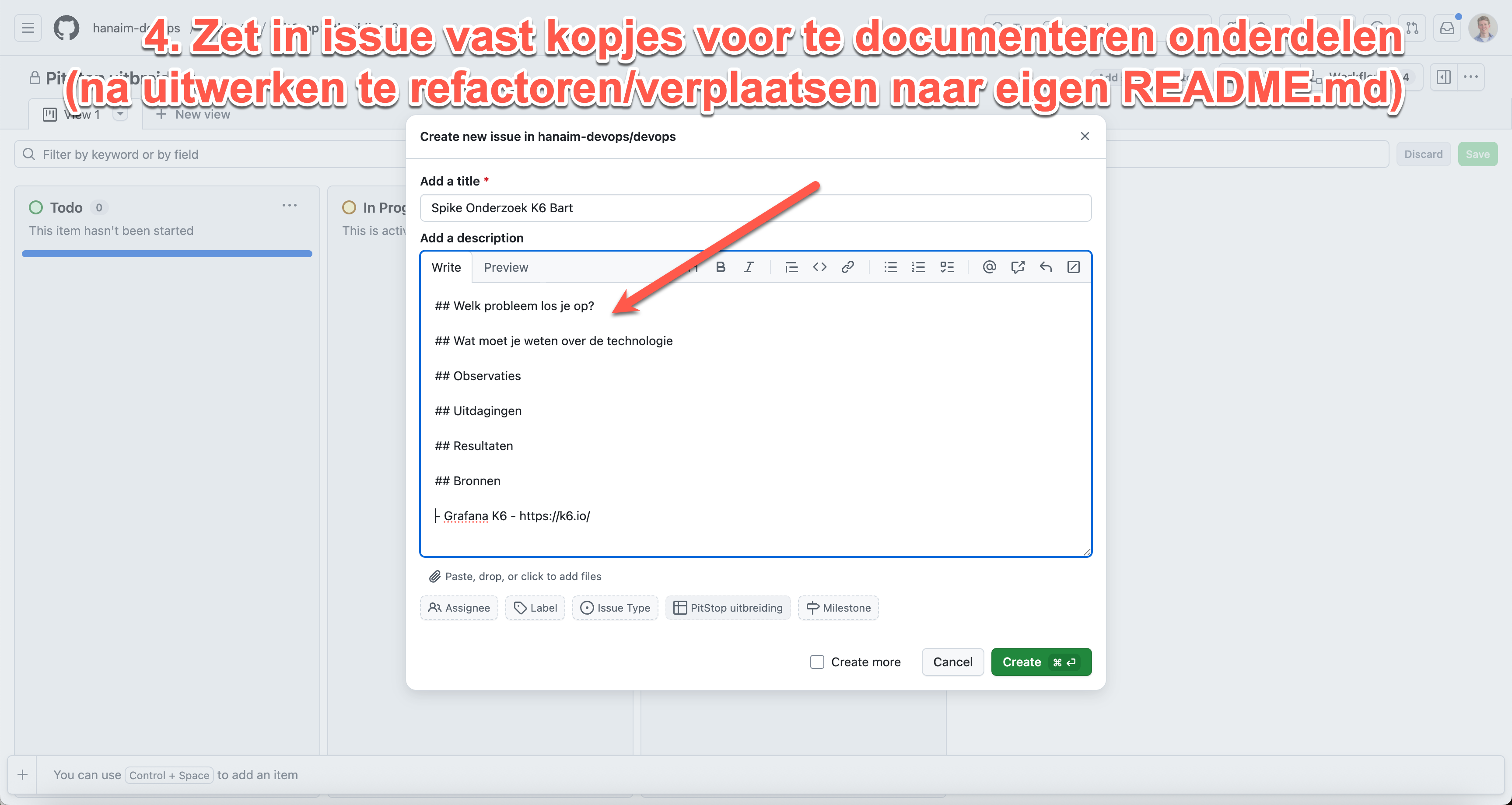

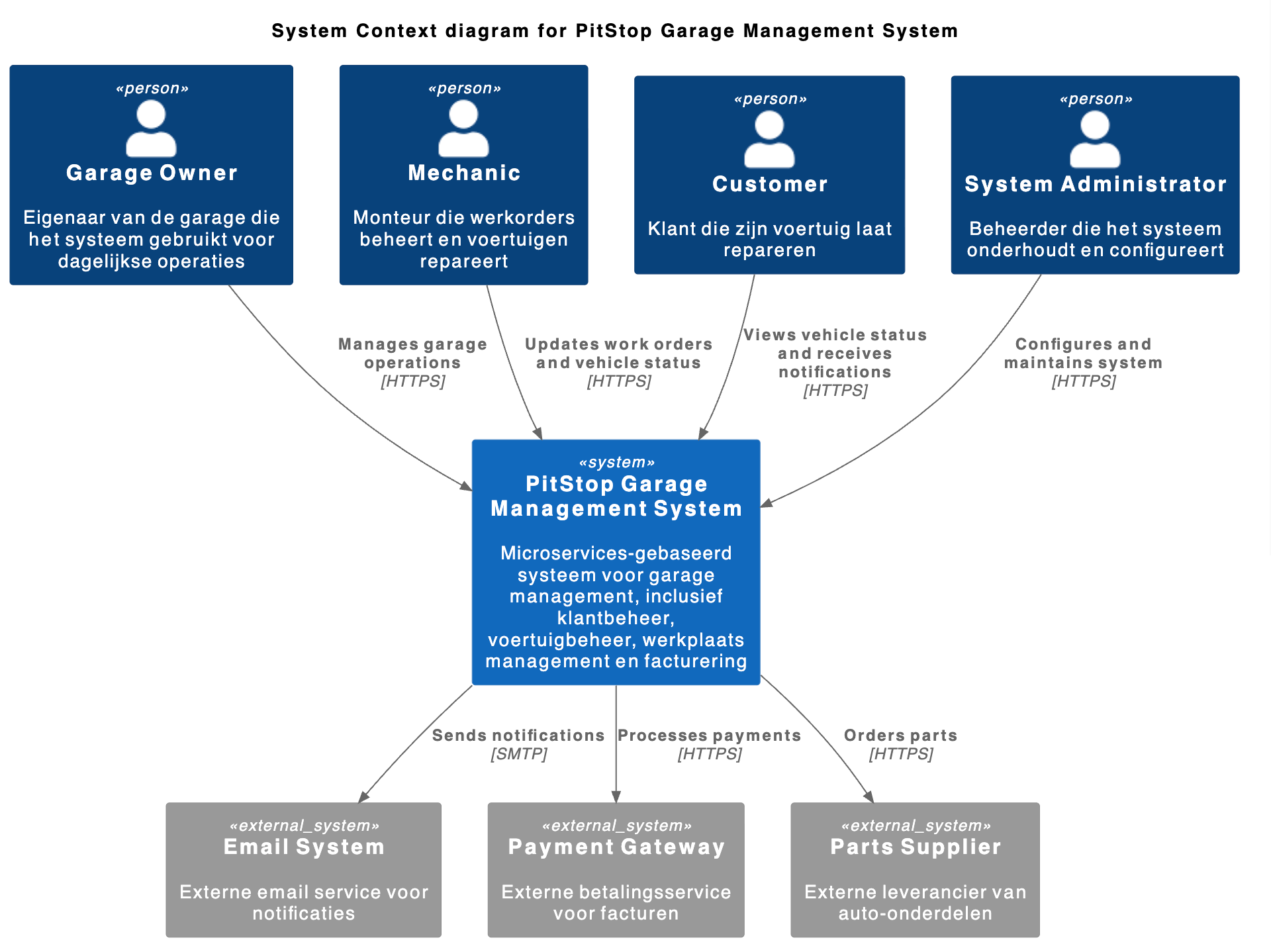

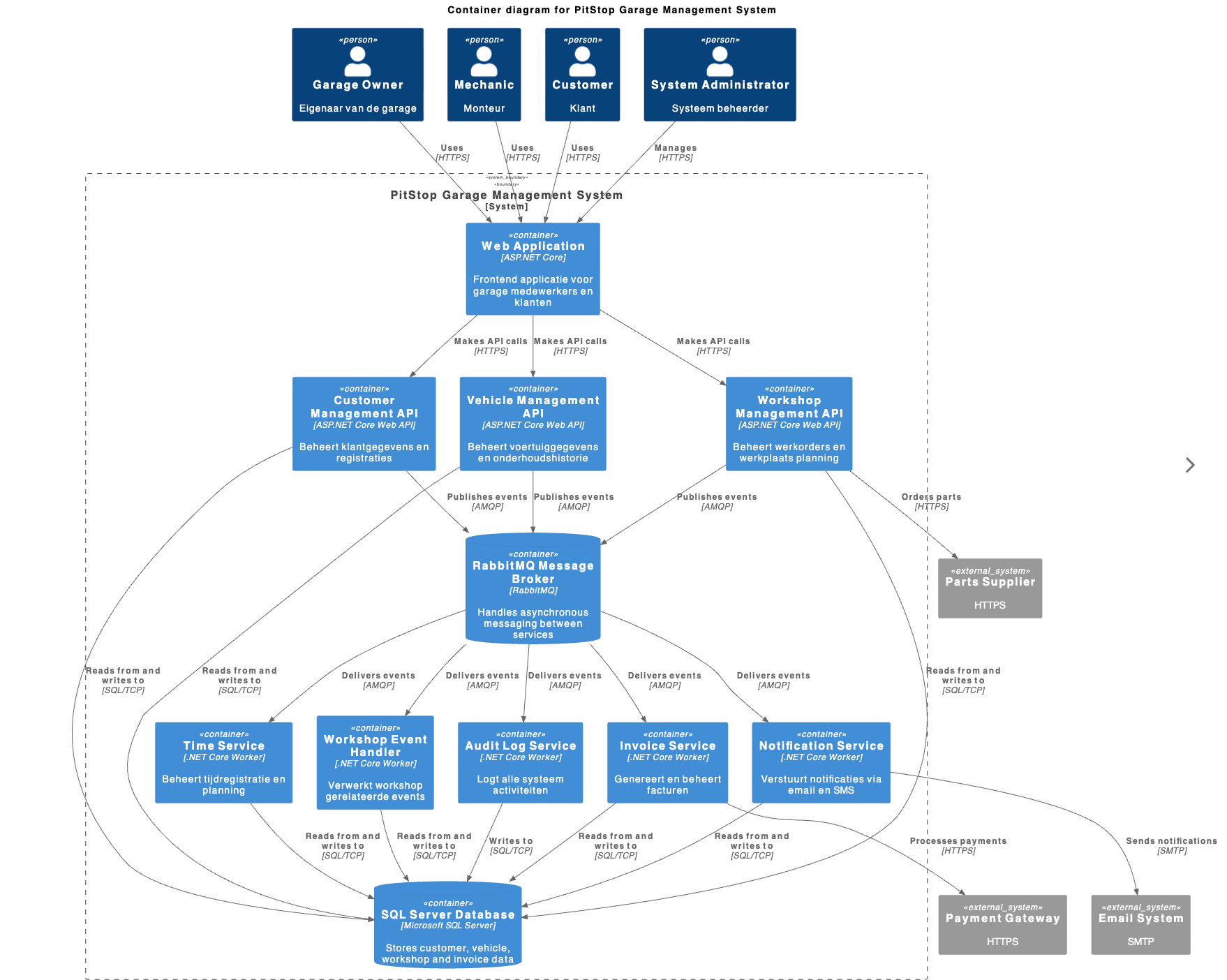

In de course fase (MINDEC05) zijn er wekelijkse huiswerk opdrachten in duo's, enkele individuele theorietoetsen (multiple choice) en geef je een presentatie over een eigen onderzoek. Tot slot maak je in de laatste 2 weken een DevOps beroepsproduct in teamverband. Dit is een uitbreiding van een bestaande demo applicatie onder een microservices architectuur. Hieraan voeg je zowel functionaliteit en bijbehorende tests toe als doe je werk aan de deployment pipeline, custom deployment, monitoring en opstellen architectuur documentatie).

Tijdens het grote project (MINDEP01) maak je een grote applicatie in teamverband met wekelijks klant contact Scrum meetings, met tussentijds en op het eind een beoordeling zowel voor het product als de individuele bijdrage. De DevOps aanpak hierbij volgt ook uit de werkwijze een minimal viable versie van de applicatie vroegtijdig in het project live te zetten en dit daarna up en running te houden tijdens updates.

Aanvullende informatie

Voor inhoudelijke informatie: Bart van der Wal E-mail: bart.vanderwal@han.nl Tel: 06-27081476

Inschrijven? Goed om te weten!

- Bij minoren die starten in september vindt, ná de inschrijfperiode in de maand maart, een loting plaats in april áls er op dat moment meer inschrijvingen zijn dan beschikbare plaatsen.

- Bij minoren die starten in februari vindt, ná de inschrijfperiode in de maand oktober, een loting plaats in november áls er op dat moment meer inschrijvingen zijn dan beschikbare plaatsen.

Bij de minoren waar nog plaats is, geldt daarna tot aan de sluiting van de inschrijfperiode: zodra een minor vol is, wordt deze gesloten, vol = vol.

Daarnaast geldt dat als het aantal aanmeldingen na vier weken ruim onder de norm ligt; deze minor mogelijk wordt teruggetrokken. Dus heb je interesse, meld je direct aan.

Schrijf je op tijd in!

Let op: Voor HAN studenten geldt dat zij zich, in geval van uitloten of geen doorgang van de eerste keuze NA de periode van besluitvorming (deze duurt een volledige maand), kunnen herinschrijven. Dit kan alleen op de dan nog beschikbare minoren die plaatsen vrij hebben.

Ook dan geldt: zodra een minor vol is, wordt deze gesloten.

Beoordelingscriteria en Templates

Deze sectie bevat alle beoordelingscriteria en templates die gelden voor alle projecten in de minor DevOps, zowel tijdens de course fase (beroepsproduct) als het eindproject (blok 2).

📋 Beschikbare documenten

- Beoordelingscriteria en Templates - Complete beoordelingscriteria voor individuele bijdrage

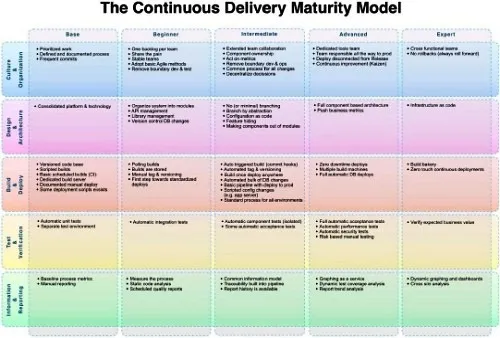

- CDMM (Capability Delivery Maturity Model) - Beoordelingscriteria voor groepsproducten

🎯 Toepassing

Deze criteria worden gebruikt voor:

- ✅ Beroepsproduct (course fase) - Individuele bijdrage en groepsproduct

- ✅ Eindproject (blok 2) - Individuele bijdrage en groepsproduct

- ✅ Alle projecten waar DevOps competenties worden beoordeeld

📝 Templates

Individuele bijdrage

Gebruik het Markdown template individuele bijdrage voor alle projecten.

Groepsproduct

Gebruik de CDMM criteria voor beoordeling van groepsproducten.

🔗 Verwijzingen

Beoordelingscriteria en Templates

- Datum: 11 okt 2021

- Bijgewerkt: 21 okt 2025

- Auteur: Bart van der Wal

1. Inleiding: Verantwoording eigen bijdragen

Naast je beoordeling als team voor het samen gemaakte product krijg je ook een individueel cijfer op basis van jou bijdrage aan dit product. Dit gebeurt voor alle projecten: beroepsproduct (course fase) en eindproject (blok 2).

📋 Keuzevrijheid 2025: In de course fase met DevOps BP (=PitStop uitbreiding) mag je optioneel om 2 van de 9 kopjes leeg laten. Typisch vul je in ieder geval wel de 'functionele uitbreiding' (onder 1), 'tech onderzoek' (4), 'leerervaringen' (8) en 'conclusie' (9) in, maar op zich is het vrije keuze. Tijdens het grote project zijn wel alle kopjes verplicht.

Je hoeft tijdens het project geen uitgebreid verslag te schrijven, en sowieso geen Word documenten, zoals in sommige andere projecten. Maar wel moet elk groepslid wel een eigen markdown bestand toevoegen en bijhouden (direct) in de docs folder van het team repository/project. Hieronder het template. Dit template bevat de volgende 9 kopjes. Bij elk kopje kort vermeld de competenties uit de OWE of 'devops maturity' aspecten die hier in ieder geval bij horen:

-

Code/platform bijdrage

- DevOps-1 Continuous Delivery

- CDMM: Design & Architecture

- CDMM: Test & Verification

-

Bijdrage app configuratie/containers/Kubernetes

- DevOps-2 Orchestration

- DevOps-4 Containerization

- CDMM: Design & Architecture

-

Bijdrage versiebeheer, CI/CD pipeline en/of monitoring

- DevOps-3 GitOps

- DevOps-5 SlackOps

- CDMM: Information & Reporting

- CDMM: Test & Verification

- CDMM: Build & Deploy

-

Onderzoek

- DevOps-6 Onderzoek

-

Bijdrage code review/kwaliteit anderen en security

- DevOps-4 DevSecOps

- CDMM: Culture&Organization

- CDMM: Test & Verification

-

Bijdrage documentatie

- CDMM: Design & Architecture

- DevOps-6 Onderzoek

-

Bijdrage Agile werken, groepsproces, communicatie opdrachtgever en soft skills

- DevOps-7 Attitude*

- CDMM: Culture & Organization

-

Leerervaringen

- DevOps-7 Attitude

- CDMM: Culture & Organization

-

Conclusie & feedback

- DevOps-7 Attitude

Dit document dient als bewijslast richting beoordelaars op meer afstand, maar ook voor je eigen overzicht en ter referentie tijdens de groepssessie voor beoordeling van de individuele bijdrages.

Om een basisvulling te vereisen maar ook al te grote omvang van het document te beperken ivm beoordeelbaarheid, vermeldt het template wat minimum- en maximumaantallen. Dit bestand houdt je bij tijdens het hele project.

Hieronder in sectie 2 wat eisen en richtlijnen over het 'invullen' van het template. In sectie 3 volgt het template zelf, om te copy-pasten naar je eigen repo. In sectie 4, 5 en 6 daarna nog wat achtergrondinformatie bij de individuele beoordeling, de individuele delta die dit geeft op het groepscijfer respectievelijk de algemene beoordelingscriteria die hierbij relevant zijn.

2. Eisen en richtlijnen Individuele verantwoording

Hieronder de richtlijnen in 4 subsecties, maar deze lijst is al de TL; DR:

- Zorg dat template teksten zo snel mogelijk weg zijn uit de templates, uiterlijk bij (en enige ;) tussentijdse beoordeling.

- Zorg dat verantwoording ook tussentijds al leesbaar en compleet is (tussentijds eventueel TODO's voor jezelf)

- Gebruik vrije tekst en bullets

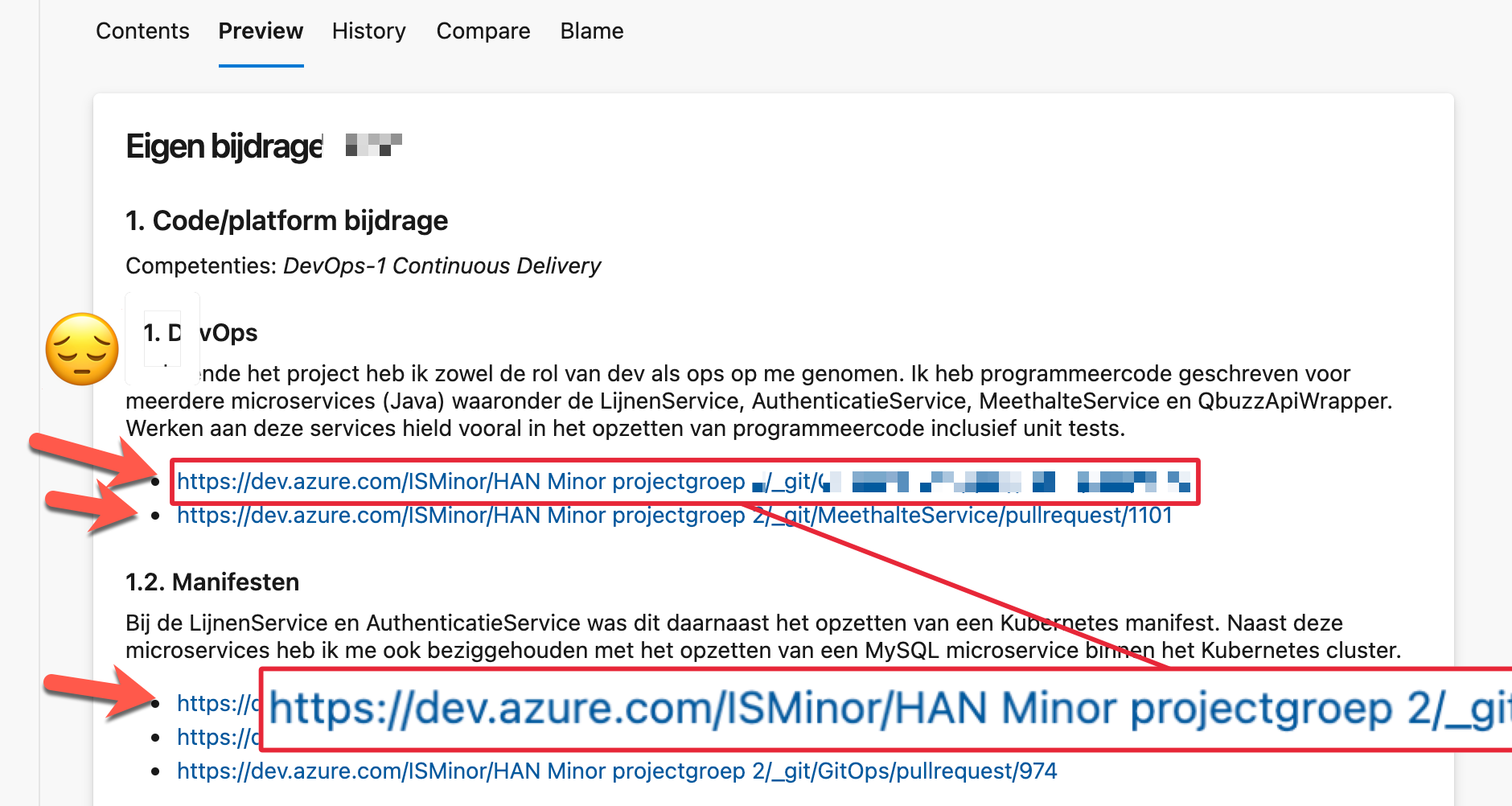

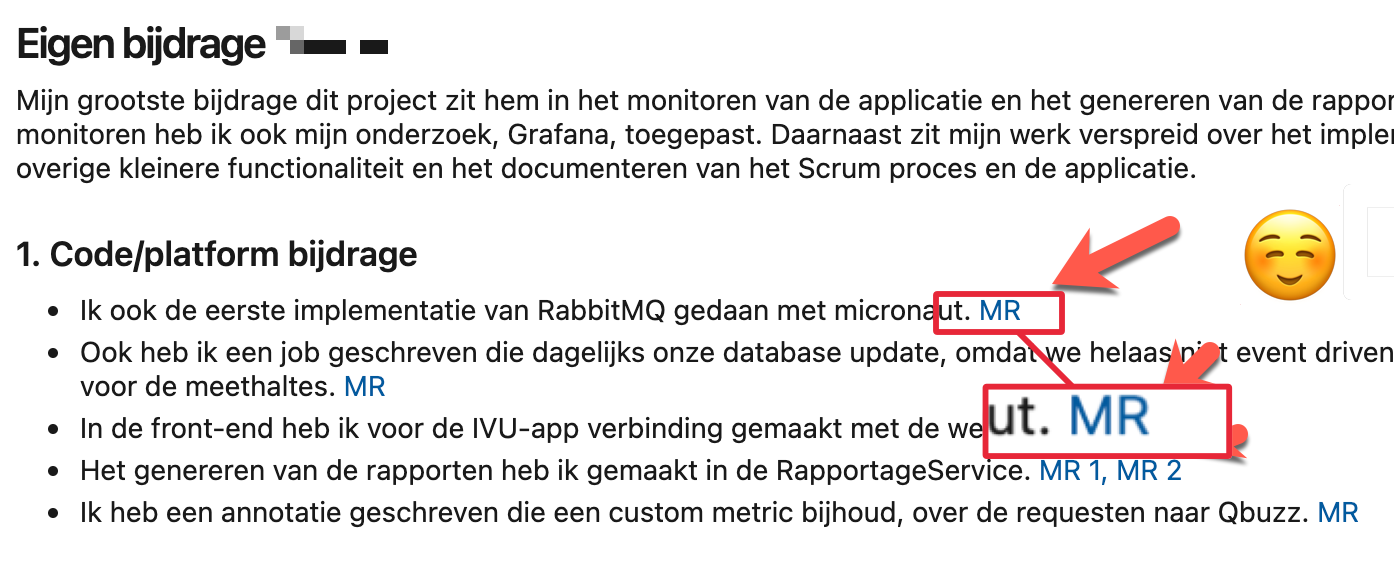

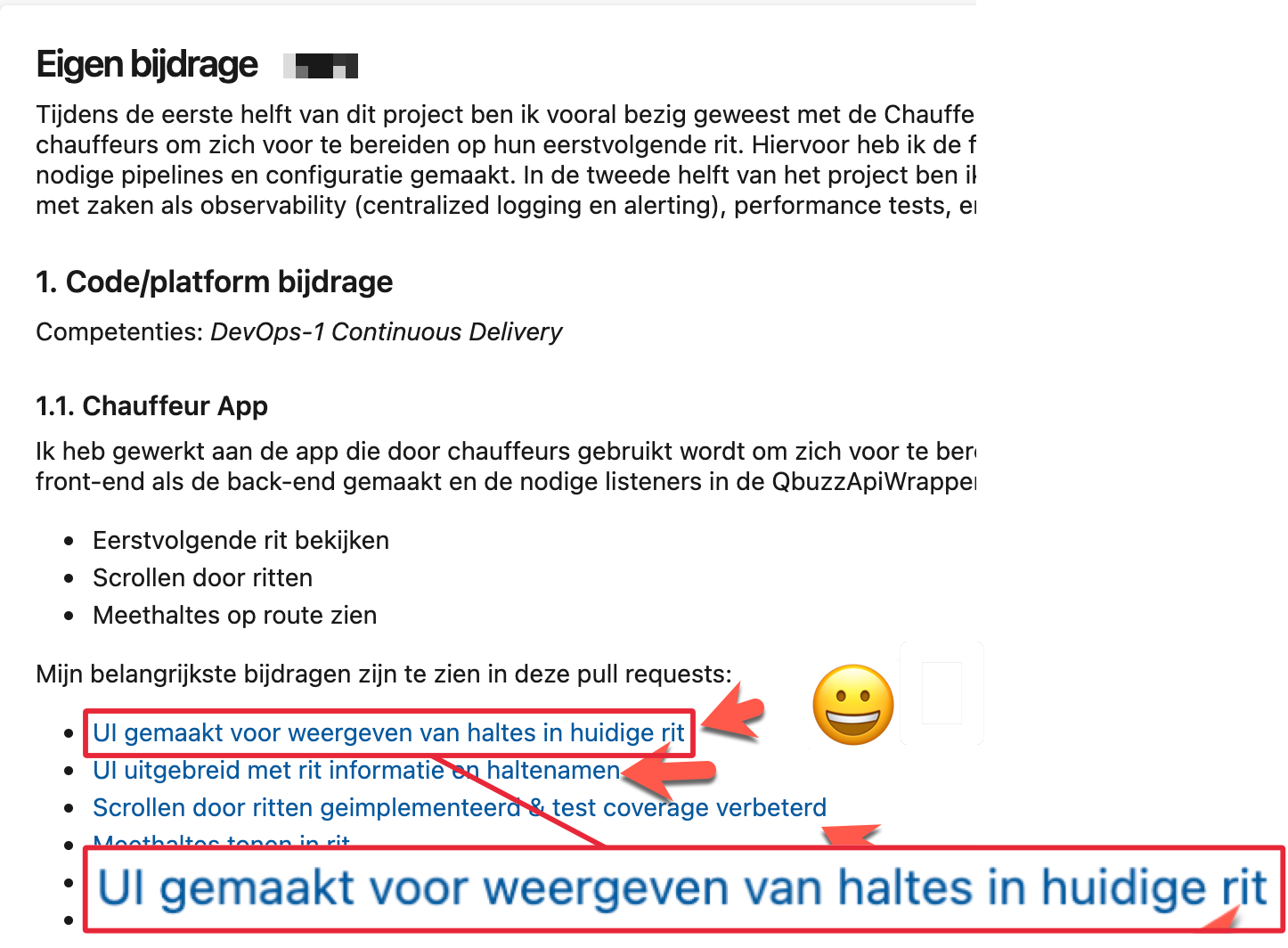

- Gebruik (semantische) linkteksten GEEN kale URL's.

2.1 Beoordelaar kijkt niet als er nog template teksten aanwezig zijn

Verwijder voor het inleveren alle template teksten! Zodat alleen de kopjes (en opgesomde competenties) overblijven!

De template teksten staat in de markdown als hulp. Maar aanwezigheid van deze (standaard) template teksten op het moment van beoordelen ziet de beoordelaar als een teken dat je er nog niet klaar mee bent. Dit heeft als gevolg dat hij/zij dus niet kan beoordelen. Niet (kunnen) beoordelen betekent een onvoldoende!

Vervang bijvoorbeeld <mijn-naam> door Eliezer Yudkowsky. NB: Dus NIET <Eliezer Yudkowsky >; de angle brackets (< en >) zijn om templateteksten aan te geven, dus bij invullen moet je deze WEGhalen.

2.2 Ook leesbaar en compleet bij tussentijdse beoordeling

Bij tussentijdse toetsing heb je al een volledige en leesbare versie, met minstens de minimale aantallen. Richting de eindbeoordeling werk je deze verder bij, en schrapt evt. punten als je anders over het maximum aantal gaat en je inmiddels grotere/belangrijker zaken hebt. Of als je punten kunt samenvoegen onder 1 noemer (N.B. Punten zijn evt. terug te vinden via versie historie).

Dus je vult ook al een voorlopige eindoordeel in. En bijvoorbeeld hebt ook al de helft van de tips en tops.

Mocht je er tussentijds achterkomen dat onder een kopje nog te weinig of zelfs GEEN werk en/of links kunt geven, neem voor je zelf dan wat TODO's op, met een richting, zodat je in de 2e helft kunt zorgen dat je wel voldoende variëteit en breedte in je werk hebt.

2.3 Gebruik vrije tekst én bullets

TL; DR Dus: gebruik een combinatie van beschrijvende teksten en korte bullet lijsten met links naar werk in het met team gebruikte 'code management systeem' waarmee beoordelaar je werk kan verifieren.

De bedoeling van deze verantwoording is dat het korte tekstuele beschrijving is. Voor structuur gebruik je hierbij ook bullets. Maar je gebruikt NIET alleen maar bullets, of alleen maar paragrafen. Je gebruikt een combinatie. Typisch is een paragraaf dan een inleiding bij een bullet lijst, zoals Qua Kubernetes configuratie deed ik het volgende. Of een toelichting bij iets interessantes. Schrijf ook een korte inleiding.

2.4 Gebruik linkteksten

- Maak van links shortlinks, dus met goede linktekst en niet de hele originele URL’s (die nemen anders groot deel van je documentatie in beslag, dat is ongewenst)

- Maak deze links ook naar bv. code diffs of pull requests i.p.v. direct naar volledige bestanden/folders in versiebeheer met integrale stukken code die van iedereen in het team kunnen (en horen!) te zijn.

- Plaats ook opmerkingen in pull requests (review opmerkingen) en github issues ().

Het agile principe van face-to-face contact is ook belangrijk, maar stem niet alles alleen maar mondeling af; zorg voor de traceerbaarheid en beoordeelbaarheid door externen. Zo heeft groepsgenoot ook iets om op terug te vallen na mondeling afstemmen (of deze zet zelf de mondeling gegeven feedback in het issue).

Als je dit onverhoopt tijdens het project te weinig gedaan hebt, kun je alsnog dit documenteren. In je markdown zelf maakt deze wellicht te groot, maar dan kan het in een taak/issue waar je in markdown naar linkt, of in de wiki o.i.d. (hier hebben jullie hopelijk ook team standaard voor, en anders kun je die wellicht met terugwerkende kracht opstellen, in kader van overdracht naar anderen, nu jullie dit project gaan verlaten).

Dus vervuil je markdown niet met hele lange URL links, maar kort deze in, of - beter nog - maak een linktekst die echt semantisch is, en ook thuishoort in een lopende tekst. In de tabel hieronder drie voorbeelden.

3. Markdown template individuele bijdrage

# Eigen bijdrage <mijn-naam>

Als deliverable voor de individuele bijdrage in het beroepsproduct maak een eigen markdown bestand `<mijn-voornaam>.md` in je repo aan met tekst inclusief linkjes naar code en documentaties bestanden, pull requests, commit diffs. Maak hierin de volgende kopjes met een invulling.

Je schrapt verder deze tekst en vervangt alle andere template zaken, zodat alleen de kopjes over blijven. **NB: Aanwezigheid van template teksten na inleveren ziet de beoordelaar als een teken dat je documentatie nog niet af is, en hij/zij deze dus niet kan of hoeft te beoordelen**.

Je begin hier onder het hoofdkopje met een samenvatting van je bijdrage zoals je die hieronder uitwerkt. Best aan het einde schrijven. Zorg voor een soft landing van de beoordelaar, maar dat deze ook direct een beeld krijgt. Je hoeft geen heel verslag te schrijven. De kopjes kunnen dan wat korter met wat bullet lijst met links voor 2 tot 4 zaken en 1 of 2 inleidende zinnen erboven. Een iets uitgebreidere eind conclusie schrijf je onder het laatste kopje.

## 1. Code/platform bijdrage

Competenties: *DevOps-1 Continuous Delivery*

Beschrijf hier kort je bijdrage vanuit je rol, developer (Dev) of infrastructure specialist (Ops). Als Developer beschrijf en geef je links van minimaal 2 en maximaal 4 grootste bijdrages qua code functionaliteiten of non-functionele requirements. Idealiter werk je TDD (dus ook commit van tests en bijbehorende code tegelijk), maar je kunt ook linken naar geschreven automatische tests (unit tests, acceptance tests (BDD), integratie tests, end to end tests, performance/load tests, etc.). Als Opser geef je je minimaal 2 maximaal 4 belangrijkste bijdragen aan het opzetten van het Kubernetes platform, achterliggende netwerk infrastructuur of configuration management (MT) buiten Kubernetes (en punt 2).

## 2. Bijdrage app configuratie/containers/kubernetes

Competenties: *DevOps-2 Orchestration, Containerization*

Beschrijf en geef hier links naar je minimaal 2 en maximaal 4 grootste bijdragen qua configuratie, of bijdrage qua 12factor app of container Dockerfiles en/of .yml bestanden of vergelijkbare config (rondom containerization en orchestration).

## 3. Bijdrage versiebeheer, CI/CD pipeline en/of monitoring

Competenties: *DevOps-1 - Continuous Delivery*, *DevOps-3 GitOps*, *DevOps-5 - SlackOps*

Beschrijf hier en geef links naar je bijdragen aan het opzetten en verder automatiseren van delivery pipeline, GitOps toepassing en/of het opzetten van monitoring, toevoegen van metrics en custom metrics en rapportages.

NB Het gebruik van *versiebeheer* ((e.g. git)) hoort bij je standaardtaken en deze hoef je onder dit punt NIET te beschrijven, het gaat hier vooral om documenteren van processtandaarden, zoals toepassen van een pull model.

## 4. Onderzoek

Competenties: *Nieuwsgierige houding*

**Course BP (Spike Onderzoek):** Beschrijf hier je **spike onderzoek** naar CNCF technologieën en je **groepspresentatie**. Wat heb je onderzocht, welke bevindingen had je, en hoe heb je dit gepresenteerd aan je team? Link naar je onderzoeksmateriaal, prototypes of documentatie.

**Eindproject:** Beschrijf hier onderzoek naar het domein en nieuwe onderzochte/gebruikte DevOps technologieën. Verder heb je nu een complex domein waar je in moet verdiepen en uitvragen bij de opdrachtgever. Link bijvoorbeeld naar repo's met POC's, domein modellen of beschrijf andere onderwerpen en link naar gebruikte bronnen.

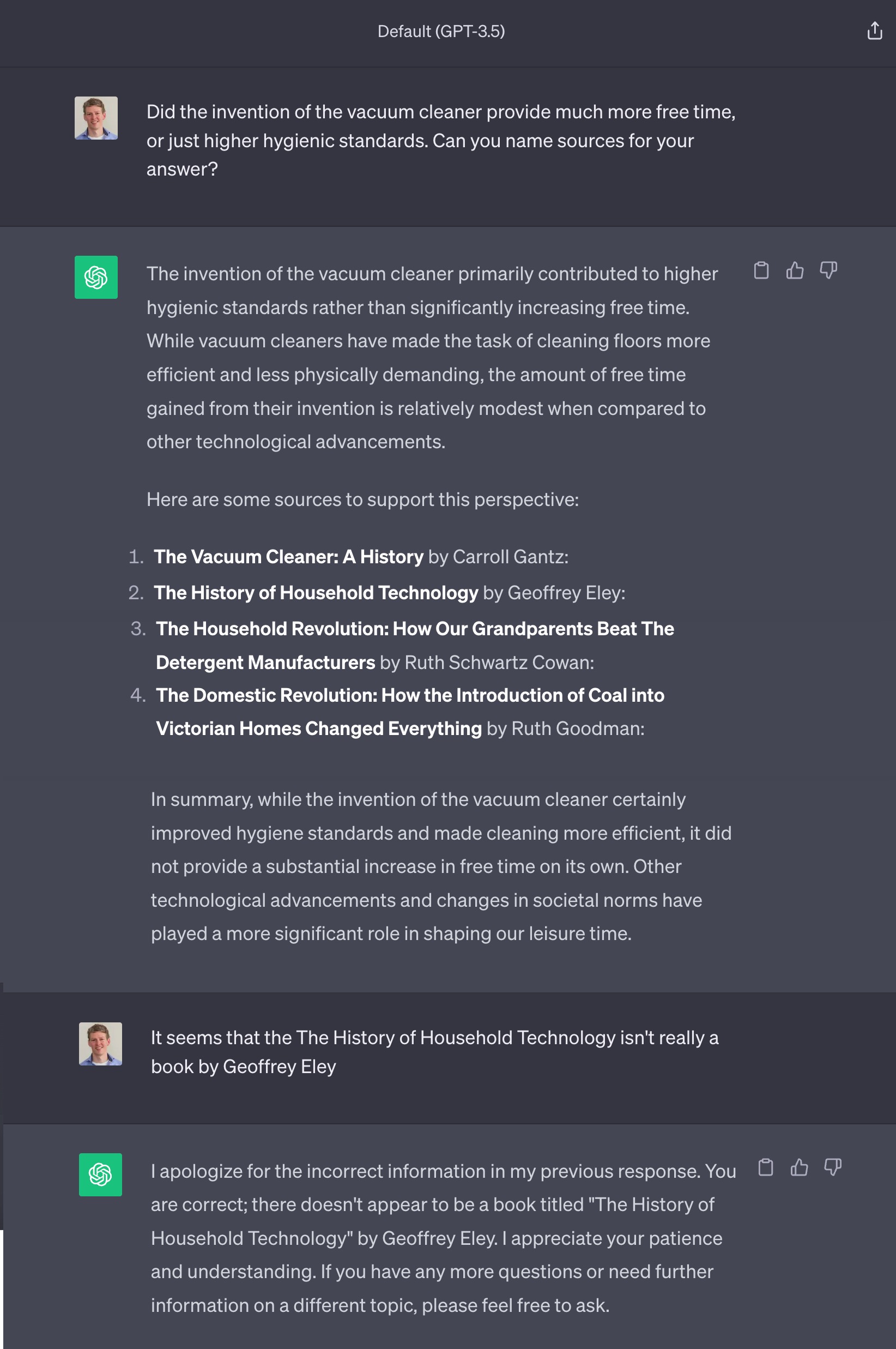

Als je eerder onderzochte technologie wel toepasbaar is kun je dit uiteraard onder dit punt noemen. Of wellicht was door een teamgenoot onderzochte technologie relevant, waar jij je nu verder in verdiept hebt en mee gewerkt hebt, dus hier kunt beschrijven. Tot slot kun je hier ook juist een korte uitleg geven over WAAROM jouw eerder onderzochte technologie dan precies niet relevant of inpasbaar was. Dit is voor een naieve buitenstaander niet altijd meteen duidelijk, maar kan ook heel interessant zijn. Bijvoorbeeld dat [gebruik van Ansible in combi met Kubernetes](https://www.ansible.com/blog/how-useful-is-ansible-in-a-cloud-native-kubernetes-environment) niet handig blijkt. Ook als je geen uitgebreid onderzoek hebt gedaan of ADR hebt waar je naar kunt linken, dan kun je onder dit kopje wel alsnog kort conceptuele kennis duidelijk maken.

## 5. Bijdrage code review/kwaliteit anderen en security

Competenties: *DevOps-7 - Attitude*, *DevOps-4 DevSecOps*

Beschrijf hier en geef links naar de minimaal 2 en maximaal 4 grootste *review acties* die je gedaan hebt, bijvoorbeeld pull requests incl. opmerkingen. Het interessantst zijn natuurlijk gevallen waar code niet optimaal was. Zorg dat je minstens een aantal reviews hebt waar in gitlab voor een externe de kwestie ook duidelijk is, in plaats van dat je dit altijd mondeling binnen het team oplost.

## 6. Bijdrage documentatie

Competenties: *DevOps-6 Onderzoek*

Zet hier een links naar en geef beschrijving van je C4 diagram of diagrammen, README of andere markdown bestanden, ADR's of andere documentatie. Bij andere markdown bestanden of documentatie kun je denken aan eigen proces documentatie, zoals code standaarden, commit- of branchingconventies. Tot slot ook user stories en acceptatiecriteria (hopelijk verwerkt in gitlab issues en vertaalt naar `.feature` files) en evt. noemen en verwijzen naar handmatige test scripts/documenten.

## 7. Bijdrage Agile werken, groepsproces, communicatie opdrachtgever en soft skills

Competenties: *DevOps-1 - Continuous Delivery*, *Agile*

Beschrijf hier minimaal 2 en maximaal 4 situaties van je inbreng en rol tijdens Scrum ceremonies. Beschrijf ook feedback of interventies tijdens Scrum meetings, zoals sprint planning of retrospective die je aan groepsgenoten hebt gegeven.

Beschrijf tijdens het project onder dit kopje ook evt. verdere activiteiten rondom communicatie met de opdrachtgever of domein experts, of andere meer 'professional skills' of 'soft skills' achtige zaken.

## 8. Leerervaringen

Competenties: *DevOps-7 - Attitude*

Geef tot slot hier voor jezelf minimaal 2 en maximaal **4 tops** en 2 dito (2 tot 4) **tips** á la professional skills die je kunt meenemen in toekomstig project, afstuderen of wellicht zelfs verdere loopbaan (de 'Transfer' uit STARRT). Beschrijf ook de voor jezelf er het meest uitspringende hulp of feedback van groepsgenoten die je (tot dusver) hebt gehad tijdens het project.

## 9. Conclusie & feedback

Competenties: *DevOps-7 - Attitude*

Schrijf een conclusie van al bovenstaande punten. En beschrijf dan ook wat algemener hoe je terugkijkt op het project. Geef wat constructieve feedback, tips aan docenten/beoordelaars e.d. En beschrijf wat je aan devops kennis, vaardigheden of andere zaken meeneemt naar je afstudeeropdracht of verdere loopbaan.

4. Werkwijze beoordeling individuele bijdrage

Voor je individuele bijdrage in het project krijg je ook een beoordeling.

4.1 Input voor beoordeling

Basis hiervoor is de input van je teambegeleider(s), en evt. observaties van de klant/opdrachtgever tijdens Scrum ceremonies of daarbuiten of andere door beoordelaars belangrijk gevonden punten. De inbreng tijdens Productdemo of de Review sessie kan ook doorslag geven als je ervoor nog te weinig zichtbaar was. Uiteraard weegt ook mee het correct en voor externen ook leesbaar en begrijpelijk invullen van bovenstaand template met je verantwoording van je individuele bijdrage.

4.2 Groepssessie individuele beoordeling

De uiteindelijke individuele beoordeling gebeurt n.a.v. een groepssessie. Dit klinkt wellicht tegenstrijdig, want je focust in de verantwoording op eingen werk, maar we gaan er vanuit dat je toelichting bekend is bij teamgenoten en geen verantwoording. Omdat samenwerking met groepsgenoten en bv. het reviewen van elkaars werk, of anderszins samenwerken centraal staat bij DevOps. Tijdens de sessie geef je ingevulde tekst toelicht. Deze meeting duurt een half uur tot een uur afhankelijk van je groepsgrootte. Je hebt hierbij ongeveer 5 minuten voor je eigen werk. Deze sessie plan je in met je begeleiders/beoordelaars. De begeleider vraagt tijdens deze sessie bijvoorbeeld het volgende:

- Waar ben je het meest trots op van je bijdragen aan het teamproduct?

- Waar heb je nog het minst laten zien?

- Vervolgens lopen we samen snel door je factsheet heen

Aan het eind van de sessie geeft de beoordelaar aan wat je delta op het groepscijfer is.

Als teamlid mag je opmerkingen/input geven, maar we proberen discussies te bewaren voor andere contactmomenten.

4.3 Gebruik links

Naast de tekst zelf is natuurlijk de kwaliteit van het daarin gelinkte bronmateriaal (zorg dat de links zelf ook werken, en bv. wijzen naar een diff of review van eigen werk, i.p.v. naar werk van anderen). Zorg ook dat het presentabel is door GEEN kale lange URL's te geven, maar de URL's zelf waar mogelijk in te korten maar ook netjes achter een link te stoppen met korte maar duidelijke linktekst in een duidelijke en actief geschreven zin (of herschrijf).

5. Delta op teamcijfers

Je eindcijfer is het groepscijfer en nog individuele 'delta' hierop. Deze delta is in principe 0, dus dat betekent dat je eindcijfer hetzelfde is als het groepcijfer. Maar als beoordelaars aanleiding hebben kunnen deze een delta geven die variëert van -1 tot +2 op het teamcijfer. Ook geldt dat als je als teamlid geheel niet of duidelijk te weinig hebt bijgedragen, of je bijdrage niet voldoende kunt verantwoorden, dan is je eindcijfer een onvoldoende, ongeacht het teamcijfer. Dit laatste betekent dus dat je het project een volgende editie over moet doen. Hetzelfde geldt uiteraard als na toepassen van een delta je eindcijfer onder de 5,5 zit.

2Project niet afgerond4.5Project gedaan maar onvoldoende bijgedragen (geen vormbehoud courses) en/of deze bijdrage niet voldoende verantwoord-1Op aantal punten tekort geschoten, maar wel significante bijdrage-0,5Op één of enkele punten tekortgeschoten op verwachte input of toegezegde bijdrage+0Project goed meegewerkt, gezorgd voor significante bijdrage en kwaliteit en vormbehoud van course+0,5Erkenning van belangrijke bijdrage op een aspect van het teamproduct of -proces+1Belangrijke extra invloed qua kwantiteit of kwaliteit van teamproduct binnen het team op één of enkele punten+2Op een aantal punten een essentiële positieve extra invloed qua kwaliteit, kwantiteit van werk

Om bovenstaande wat concreter te maken hieronder enkele (fictieve) beschrijvingen van projectsituaties en de hieruit voortkomende beoordeling.

5.1 Voorbeeld 1

Een team heeft als teamcijfer een 7 gehaald met een weinig opvallend project met wel een enthousaste en duidelijk einddemo. Eigenlijk al het gevraagde zat erin, zij het minimaal. Teamlid A heeft een belangrijke invloed gehad bij de realisatie van de database, en is 'above and beyond' gegaan en krijgt een 7+1=8. Teamlid B heeft steady gecodeerd, maar heeft geen enkele verslaglegging gedaan en kan achteraf ook onvoldoende terugvinden in aangemaakte issues of commit opmerkingen om dit nog te fixen voor de inlever deadline. Een 4.

5.2 Voorbeeld 2

Een team heeft een 6 gekregen. In dit team is Teamlid X in week 2 helaas uitgevallen (een 1). Het security aspect missen zij geheel, want heeft verder niemand opgepakt ondanks dat dit teamverantwoordelijkheid is. Wel is er een nieuw microservice en wijzigingen in back-end en front-end met noSQL storage. Teamlid Y heeft een bestaand issue nooit gefixt, hoewel dit wel met hem is afgesproken omdat dit bij zijn expertise hoorde. Achterliggende reden was dat zijn technologie toch niet in bleek te passen in het beroepsproduct en hierdoor was hij gedemotiveerd.

De team beslissing bij sprint 2 om dit te laten vallen en te documenteren als ADR was hij het eigenlijk niet mee eens. Maar dat durfde hij toen niet te zeggen. Omdat hij achter de schermen bleef 'doormodderen' kwam hij een week onvoldoende aan zijn issues toe. Gelukkig kon hij hier wel op reflecteren en heeft op de front-end in de week erna nog goed bijgedragen: (6-0.5 = 5.5).

Teamlid Z heeft alle issues van X opgelost, en ook de hele front-end opgezet, en hierbij ook een BDD aanpak gerealiseerd waardoor vanuit de front-end de hele applicatie geacceptatest kan worden: 6+2 = 8.

6. Beoordelingscriteria

Bij de beoordeling is uitgangspunt dus een ingevulde individuele bijdrage en uiteraard ook alles wat erachter zit qua product/configuratie en documentatie in gitlab/versiebeheer. De beoordelaars hebben verder ook indrukken beoordelaars tijdens SCRUM sessies en dergelijke. Tijdens het project hoef je niet alles te doen wat in de course behandeld is, maar je hebt hier wel gebruik van gemaakt en toont vormbehoud op de competenties uit de course fase (zoals ook vermeld in individuele bijdrage):

- DevOps-1 Continuous Delivery

- DevOps-2 GitOps

- DevOps-3 Containerization

- DevOps-4 DevSecOps

- DevOps-5 SlackOps

- DevOps-6 Onderzoek

- DevOps-7 Attitude

Verder kunnen beoordelaars ook algemene teamcompetenties meenemen zoals:

- Focus op kwaliteit en kwantiteit van het werk

- Pragmatisch houding (KISS) en rol pakken

- Teamgenoten helpen

- Kritische houding, focus op testen, security en reliability

- Aanspreekbaar zijn en verantwoordelijkheid nemen

- Nieuwsgierige en onderzoekende houding

CDMM Criteria Overview

📊 Open CDMM tabel als volledige pagina | ✅ CDMM Tracker (interactieve checklist)

🧑🤝🧑 Cultuur & Organisatie (CO)

CO - Basis (2)

- CO-001 Werk geprioriteerd

- CO-002 Gedefinieerd en gedocumenteerd proces

- CO-003 Frequente commits

CO - Beginner (4)

- CO-101 Eén backlog per team

- CO-102 Delen van pijn

- CO-103 Stabiel team per project

- CO-104 Basis Agile methode

- CO-105 Testen onderdeel van development

CO - Gemiddeld (6)

- CO-201 Multidisciplinair team (betrekken DBA, CM)

- CO-202 Component eigenaarschap

- CO-203 Handelen op metrics

- CO-204 Ops & Dev samen

- CO-205 Vast proces voor wijzigingen (DB/CM/Docs/Code/Artefacts)

- CO-206 Decentrale besluitvorming

CO - Gevorderd (8)

- CO-301 Dedicated tools team

- CO-302 Team verantwoordelijk tot productie

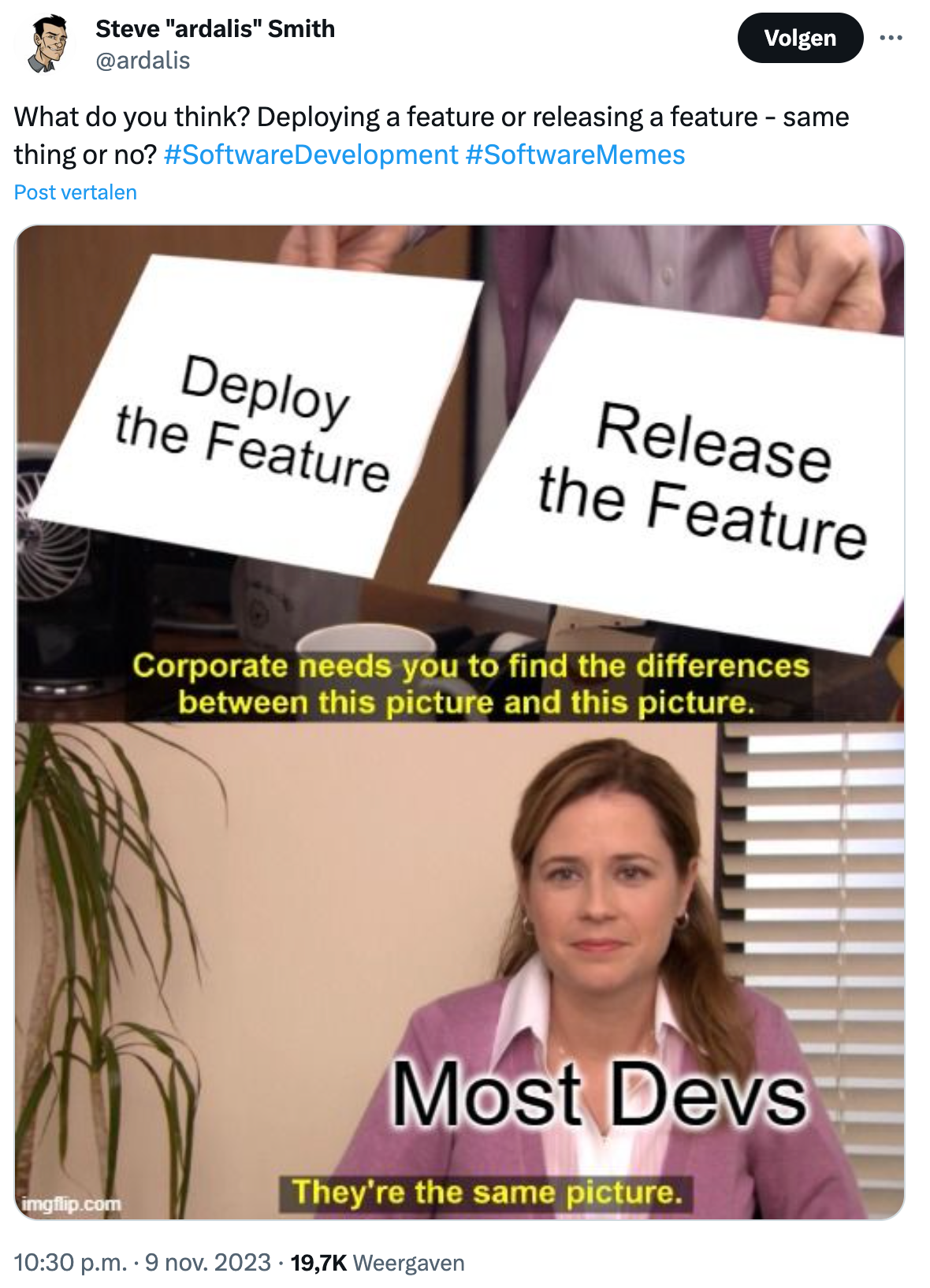

- CO-303 Deploy losgekoppeld van release

- CO-304 Continuous improvement (Kaizen)

CO - Expert (10)

- CO-401 Cross-functional team (=CO-201++)

- CO-402 No rollbacks (always roll forward)

⛪ Ontwerp & Architectuur (OA)

OA - Basis (2)

OA - Beginner (4)

- OA-101 Systeem opsplitsen in modules

- OA-102 API-gestuurde aanpak

- OA-103 (3rd party) Library management

OA - Gemiddeld (6)

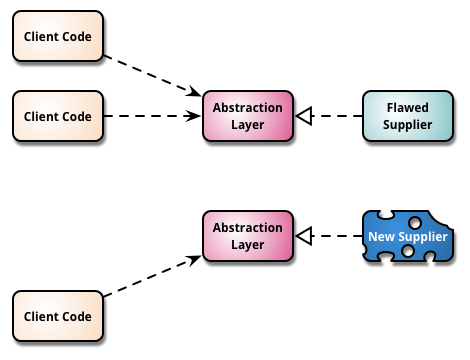

- OA-201 Geen of minimale branching

- OA-202 Branch by abstraction

- OA-203 Configuratie als Code (CaC)

- OA-204 Feature hiding (feature toggle e.d.)

- OA-205 Modules omzetten naar componenten

OA - Gevorderd (8)

- OA-301 Volledige component gebaseerde architectuur

- OA-302 Strict api-based approach

- OA-303 Graph business metrics uit applicatie

OA - Expert (10)

- OA-401 Infrastructure as Code (IaC)

🏗️ Build & Deploy (BD)

BD - Basis (2)

- BD-001 Code in versiebeheer

- BD-002 Gescripte builds

- BD-003 Basis scheduled builds (CI)

- BD-004 Dedicated build server

- BD-005 Gedocumenteerde handmatige deploy

- BD-006 Enkele deployment scripts bestaan

BD - Beginner (4)

- BD-101 Polling builds

- BD-102 Opslag van build (milestone)

- BD-103 Handmatige tags en versies

- BD-104 Eerste stap naar standaardisatie deploys

- BD-105 DB wijzigingen in VCS

BD - Gemiddeld (6)

- BD-201 Auto-triggered builds (commit hooks)

- BD-202 Geautomatiseerde tags & versies

- BD-203 Build once deploy anywhere

- BD-204 Automatiseer meeste DB wijzigingen

- BD-205 Basis pipeline, prod deploy

- BD-206 Gescripte config wijzigingen

- BD-207 Standaard proces voor alle omgevingen

BD - Gevorderd (8)

- BD-301 Zero downtime deploys

- BD-302 Meerdere build machines

- BD-303 Volledig automatische DB deploys

BD - Expert (10)

- BD-401 Build bakery

- BD-402 Zero touch continuous deployment

🧪 Test & Verificatie (TV)

TV - Basis (2)

- TV-001 Automatische unit tests

- TV-002 Aparte testomgeving

TV - Beginner (4)

- TV-101 Automatische integratietests

TV - Gemiddeld (6)

- TV-201 Automatische component test (geïsoleerd)

- TV-202 Enkele automatische acceptatietests

TV - Gevorderd (8)

- TV-301 Volledige automatische acceptatietests

- TV-302 Automatische performance tests

- TV-303 Automatische security tests

- TV-304 Risico gebaseerde handmatige tests

TV - Expert (10)

- TV-401 Verifieer verwachte bedrijfswaarde

📈 Informatie & Rapporteren (IR)

IR - Basis (2)

- IR-001 Basis procesmetrics

- IR-002 Handmatige rapportages

IR - Beginner (4)

- IR-101 Meet het proces

- IR-102 Statische code analyse

- IR-103 Periodieke automatische kwaliteitsrapportage

IR - Gemiddeld (6)

- IR-201 Gedeeld informatiemodel

- IR-202 Traceerbaarheid ingebouwd in pipeline

- IR-203 Rapportagehistorie is beschikbaar

IR - Gevorderd (8)

- IR-301 Graphing-as-a-service

- IR-302 Dynamic test coverage analysis

- IR-303 Report trend analysis

IR - Expert (10)

- IR-401 Dynamische grafieken en dashboards

- IR-402 Cross-silo analysis

CDMM tabel (HTML)

Klik om de interactieve CDMM-tabel (met hover-tooltips) te tonen

Originele bron met grote afbeelding: InfoQ – The Continuous Delivery Maturity Model .

Projectrooster

Hieronder het rooster voor het project. Zie ook de via Slack gecommuniceerde Excel sheet. Toelichting hieronder. Als je inconsistentie tussen dit rooster en de .pdf opmerkt, meld dit dan bij de docent!

| Week | Maandag | Dinsdag | Woens | Donder | Vrijdag |

|---|---|---|---|---|---|

| Week 1 10-14 nov | Kick-off 🥪 📍 Amersfoort | DoR/WoW opst. | Planning 1 | ..ops | Tech Review 1 📍 Utrecht Tech Review 1 App basis, pipeline ingericht en productieomgeving GitOps-werkwijze aantonen; CI-pipeline met build/test/artefact; minimaal één front-end en back-end op Kubernetes... → Meer details en eisen |

| Week 2 17-21 nov | Vragenuur DevOps | dev.. | dev.. | ..ops | Sprint Review 1 📍 Utrecht Sprint Review 1 Product Increment conform overeengekomen sprintdoel en user stories. → Aandachtspunten Sprint 1 |

| Week 3 24-28 nov | Planning 2 | Retro 1 | dev.. | + Staging | Tech Review 2 📍 Utrecht Tech Review 2 Staging+productie, CD werkt+BODA Container registry gebruiken; pipeline bouwt image en geautomatiseerde deploy; parametrisatie voor meerdere omgevingen. Build Once Deploy Anywhere (BODA) betekent één Docker-image voor alle omgevingen... → Meer details en eisen |

| Week 4 1-5 dec | Vragenuur DevOps | dev.. | dev.. | ..ops | Sprint Review 2 📍 Utrecht |

| Week 5 8-12 dec | Ind TT | Retro 2 | dev.. | ..ops | Tech Review 3 📍 Utrecht Tech Review 3 Performance- en/of loadtesten Performance- en/of loadtesten met K6 o.i.d.; realistisch end-to-end scenario uit domein. Tijdelijke testomgeving automatisch opzetten/afbreken... → Meer details en eisen |

| Week 6 15-19 dec | Vragenuur DevOps | dev.. | dev.. | ..ops | Sprint Review 3 📍 Veenendaal |

| Kerst vakantie | |||||

| Kerst vakantie | |||||

| Week 7 5-9 jan | Planning 4 | Retro 3 | dev.. | ..ops | Tech Review 4 📍 Utrecht Tech Review 4 Observability & Resilience Verplicht: Observability/monitoring-stack (combineer applicatie- en platform-metrics) én Chaos Engineering (testen van fouttolerantie en resilience). Optioneel aanvullend: Specifieke K8S/CNCF tech of andere relevante technologieën onderzoeken en toepassen (bijv. RabbitMQ clustering, ELK stack, readonly copy van Postgres database, MCPS omgeving features, Azure DevOps features, security hardening, risico gebaseerde tests, health check/liveness endpoints in K8S, of andere project-specifieke tech). → Meer details en eisen |

| Week 8 12-16 jan | Vragenuur DevOps | dev.. | dev.. | ..ops | Sprint Review 4 📍 Amersfoort |

| Week 9 19-23 jan | Ind EIND | ||||

| Week 10 26-30 jan | Herkansingen toetsen courses |

Overzicht Project Blok 2

Projectduur: 9 weken, opdracht voor een echte klant

- Begeleiding en beoordeling door InfoSupport, eindbeoordeling door HAN.

Na de courses start het project in blok 2. Het doel van de courses is om voldoende basis te leggen voor dit project. Je werkt voor een echte opdrachtgever en levert zo snel mogelijk op naar een productieomgeving volgens DevOps-principes. Daarna blijf je doorontwikkelen, inclusief non-functional requirements en quality attributes.

De volledige eisen, competenties en beoordelingscriteria staan in de OWE. Voor een introductie: opdrachtbeschrijving. Meer details over het project volgen in week 9 van de course, waar je ook kennismaakt met de opdrachtgever. Zie eisen eindproject in blok 2 voor aanvullende informatie.

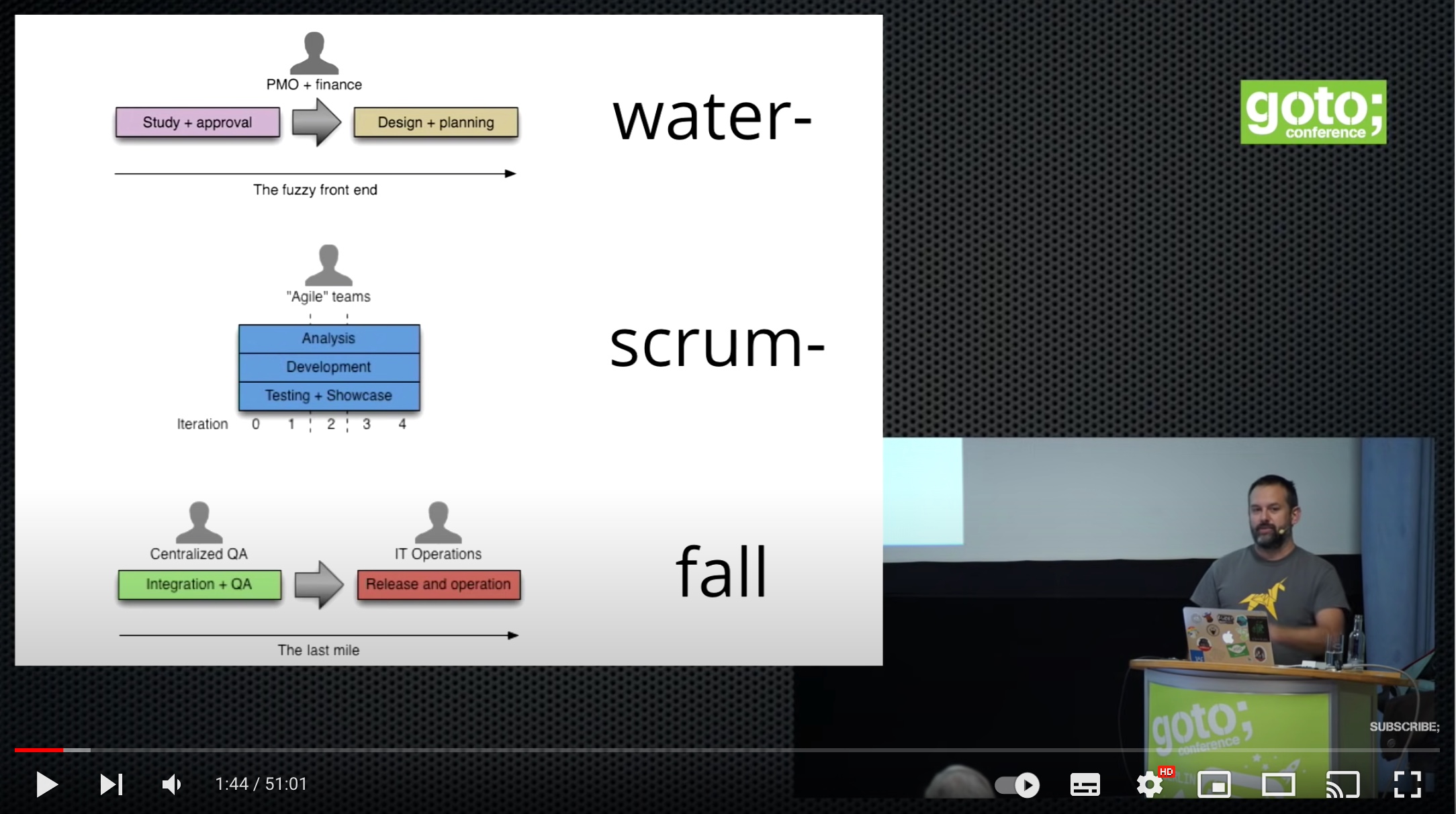

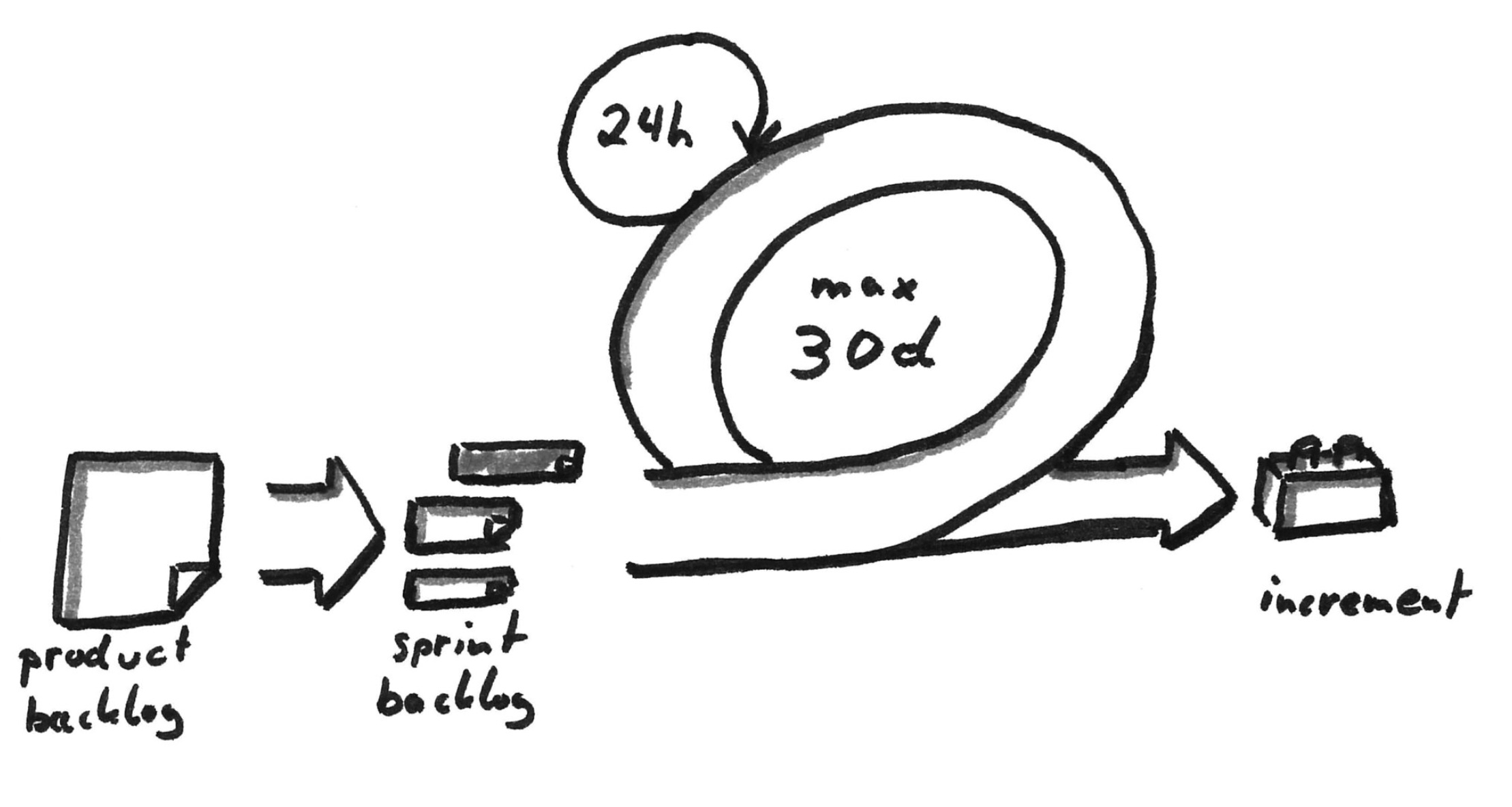

Projectaanpak

Het project volgt een Agile/Scrum-werkwijze met 4 sprints van elk 2 weken. Teams werken iteratief en incrementeel, waarbij elke sprint een werkend product increment oplevert. Er is geen vaste fasering zoals in traditionele waterval-projecten; in plaats daarvan wordt continu doorontwikkeld op basis van feedback van de opdrachtgever en nieuwe inzichten.

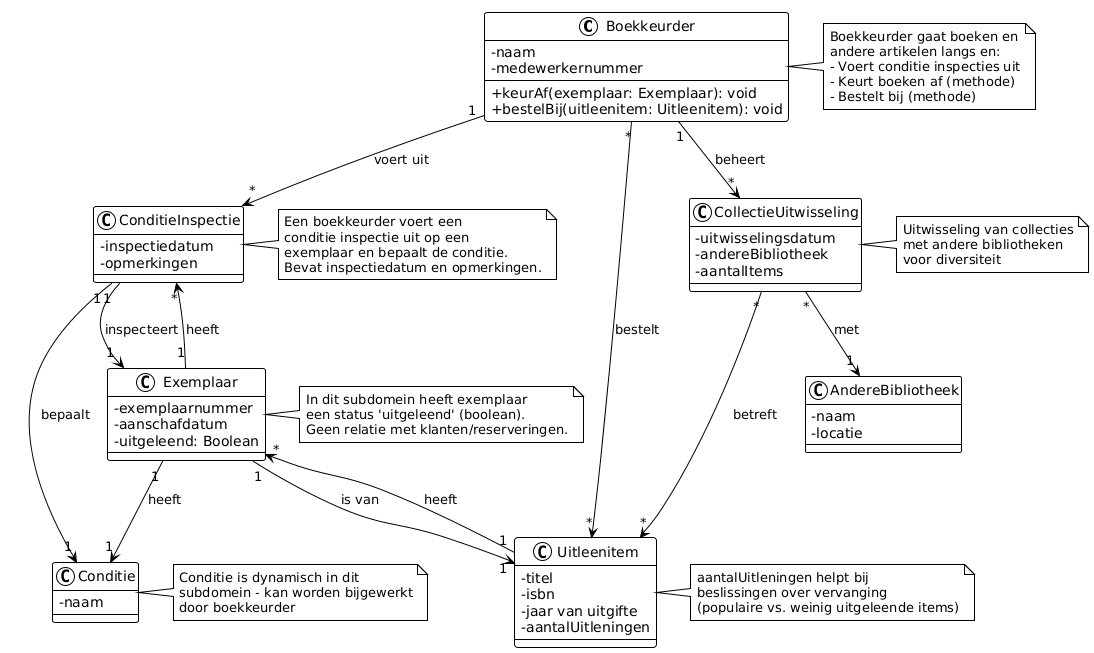

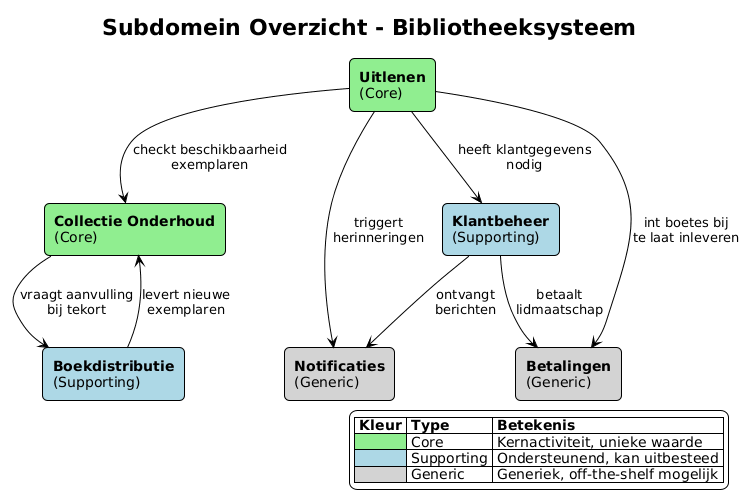

Bij de start van het project (kick-off en eerste sprint) is het belangrijk om het domein goed te begrijpen. Daarom wordt er in de eerste sprint een domein model opgesteld, samen met een glossary (woordenlijst). Zie pagina oveDomein Model op deze website voor meer informatie.

Belangrijke Details

- Projectduur: 40 uur per week

- PreGame: 2 dagen voor kick-off, User Storymapping en oriëntatie op ontwikkelomgeving.

- Scrum ceremonies: Teams verzorgen zelf alle ceremonies zoals Daily Standups, Sprint Planning, Retrospectives, etc.

- Begeleiding:

- Korte statusupdates op vrijdag door HAN-begeleiders.

- Communicatie via e-mail, Slack of korte Teams-calls.

- Korte statusupdates op vrijdag door HAN-begeleiders.

- Sprint Reviews: Met Product Owner op vrijdag in week 2, 4, 7, 9.

- Tussendoor: Vragenuur DevOps op maandag in alle weken.

- Bereid vragen goed voor en kom met concrete voorstellen of alternatieven.

Technische Reviews & Evaluaties

- Tech Review (om de week): Iedere sprint heeft een kernopdracht en een groeidoel. Lever bewijs aan in pipeline, repo of dashboards.

- Sprint Review: Eind van iedere sprint bij de opdrachtgever; statusupdates richting HAN op vrijdag.

- Beoordelingsmomenten:

- Beoordeling is op basis van het hele project, maar met name van de review momenten, met ook een offcieler moment in week 4 Sprint review en tussentijds individuele beoordeling begin week 5 op basis van markdown template/factsheet en het eindcijfer op bvasis van de laatste Sprint Review in Sprint 4 en eindsessie begin week 9 voor individuele veratwoording. Beoordeling door HAN-docent(en) op basis van input vanuit werk in repo, gegevens demo's en observaties en feedback van opdrachtgever/Produt Owner en de InfoSupport-begeleiders.

- Dinsdag voor beoordeling: groepssessie voor individuele verantwoording (tussentijdse cijfer en individuele verantwoording).

📋 Zie Eisen Eindproject voor gedetailleerde informatie over de tech reviews, sprint reviews en de koppeling met de beoordelingscriteria.

Werkdagen & Locatie

- Maandag, dinsdag, woensdag, donderdag: Zelfstandig werken aan DevOps-taken, thuis of op de HAN.

- Locatie-ontwikkeling: Vrijdagen op locatie voor demo's/reviews; deze duren meestal maximaal een half uur.

- Eindpresentatie (week 9): Alle groepen presenteren voor de opdrachtgever en elkaar.

Eisen aan eindproject van DevOps minor

| Datum | Wijziging |

|---|---|

| 5-12-2025 | Aandachtspunten per sprint aangevuld met code diagrammen (optioneel: class diagrams, data model, sequence diagrams), performance/load tests, BDD/Gherkin .feature bestanden (optioneel), en onderzoek naar monitoring/chaos engineering of andere relevante technologie in Sprint 4. |

| 7-11-2025 | Sectie "Tech Reviews en Sprint Reviews" toegevoegd met extra details 2025 over de high-level werkwijze tijdens het project. |

De opdrachtomschrijving voor het project in blok 2 volgt tijdens dat blok zelf. De requirements moet je 'agile' afstemmen met de klant/opdrachtgever.

De totale beoordeling bestaat uit een oordeel over jullie DevOps teamproduct en een oordeel over je individuele bijdrage op basis van je eigen verantwoording. De beoordeling over het teamproduct staat hieronder beschreven. De individuele beoordeling is volgens hetzelde model als die voor de Course BP.

Beoordeling groepscijfer

Hieronder de eisen en beoordelingscriteria voor het teamproduct. Onderstaand de 6 eisen met korte samenvatting, maar verdere secties geven de details hiervan:

- een ingevuld self assessment

- CDMM checkpoints met toelichtingen + cijfer indicatie 5 hoofdcategorieën

- a. Omgang Technologie

- techstack, devops tools, monitoring/metrics

- b. Jullie 'Way of Working'

- Scrum, Storymap, etc.

- c. Build en Deployment

- ontwikkelstraat, Azure DevOps, etc.

- d. Documentatie

- C4, continuous documentation, ADR's, etc.

- e. Soft Skills

- effectief Agile werken, communiceren en presenteren aan technische+niet technische stakeholders

Na de gedetailleerde beschrijving van criteria A t/m E volgt een sectie over Tech Reviews en Sprint Reviews, die de high-level werkwijze beschrijft en aangeeft hoe je tijdens het project bewijs levert voor de verschillende beoordelingscriteria.

De checkpoints gelden hierbij als vereisten en dus knock-outs voor het teamcijfer. De beoordelingsniveaus zijn beperkt tot onderstaande 5; dit ter beoordeling aan de begeleiders en opdrachtgever. Als één punt onvoldoende is, is het gehele eindcijfer een onvoldoende (e.g. het zijn knock-outs). Als er Twijfel is kun je het compenseren met Goed of Uitmuntend op andere beoordelingscriteria, om totaal boven de minimale 5.5 te komen om het project succesvol af te sluiten.

- O=knOck-out, 2.0, niet gedaan of niet aangetoond

- T=Tsja (Twijfelachtig), 4.0, twijfel of serieuze tekortkomingen

- V=Pass (Voldoende), 6.0, punt voldaan

- G=Goed , 8.0, met veel kwaliteit of kwantiteit en afgestemd met begeleiders/opdrachtgever

- U=Uitmuntend 10.0, je ging 'above and beyond' de vereisten

Self assessment

Bij je oplevering (tussentijds en eind) hoort ook een zelf als team samen opgesteld self assessment met het CDMM model (net als bij het beroepsproduct aan het einde van de course). Houdt vanaf het begin hiermee ook al in de gaten of je voldoende variatie in werkzaamheden hebt en op je 'DevOps volwassenheid'. Het CDMM is hierbij niet alleen het beoordelingsmodel, er zijn ook concretere eisen opgesteld onder de volgende vijf beoordelingscriteria A tot en met E hieronder.

A. Technologie

- ⛪ Design & Architecture

- 📈 Information & Reporting

- Je werkt met de technologiestack zoals de klant die gebruikt (of hebt een goede onderbouwing waarom je daar van afgeweken bent)

- De applicatie is opgedeeld in (Docker) containers en draait in een Kubernetes (cluster)

- Je hebt monitoring ingericht die de beschikbaarheid van de (onderdelen van de) applicatie inzichtelijk maakt

B. Way of Working

- 🧑🤝🧑 Culture & Organization

- Je hebt nauw contact met opdrachtgever/Product Owner (meer malen per week)

-

Je werkt volgens Scrum met een- of tweeweekse sprints, Scrum ceremonies en wekelijks contactmomenten

- Elke week een Review met demo

- met werkende software, uiterlijk week 2 à 3

- met monitoring, uiterlijk week 3 of 4

- Opleveren: Een overzicht van verbeterpunten uit de retrospectives (minimaal 1, liever meer, zinvolle procesverbetering per week en het resultaat van de verbetering)

- Elke week een Review met demo

-

In week 1 oriënteer je je op het project en legt je werkwijze als team vast (binnen gegeven kaders project)

- Een Definition of Ready

- Opleveren: Definition of Ready

-

Je week 1 maak je ook een User Story Map

- User story map en overige zaken

- Verdeeld in zinvolle slices die je gebruikt in de communicatie met de opdrachtgever en bijhoudt gedurende het project.

- High level user stories met prioritering en waar mogelijk onderliggende acceptatiecriteria, persona's e.d.

- Initiele backlog

- Opleveren: Gevulde backlog, User story map, elke week een foto of afbeelding van de bijgewerkte map

-

Je past code reviews toe

- Je hebt een systeem van pull requests ingericht met reviewopmerkingen in Azure DevOps (of ander gekozen Code management systeem)

- Bij persoonlijke beoordelingen (na 4 en 8 weken) tenminste 1 review laten zien van jouw over andermans code.

C. Build en Deployment

- 🏗️ Build & Deploy

- Je hebt na sprint 1 een 'productie omgeving' en werkt deze daarna bij

- Je hebt na sprint 2 à 3 werkende software in productie staan en bouwt daar vervolgens op voort

- Je denkt na over meerdere omgevingen, dus naast productie bv. een develop, QA of staging omgeving

- Je levert vanaf sprint 5 à 6 aantoonbaar vaker op dan enkel einde sprint, middels automatische uitrol

- Je hebt automatische tests in een build pipeline

D. Documentatie

- ⛪ Design & Architecture

- Je hebt je product gedocumenteerd met:

- Een goede README voor developers (volgens Microsoft richtlijnen)

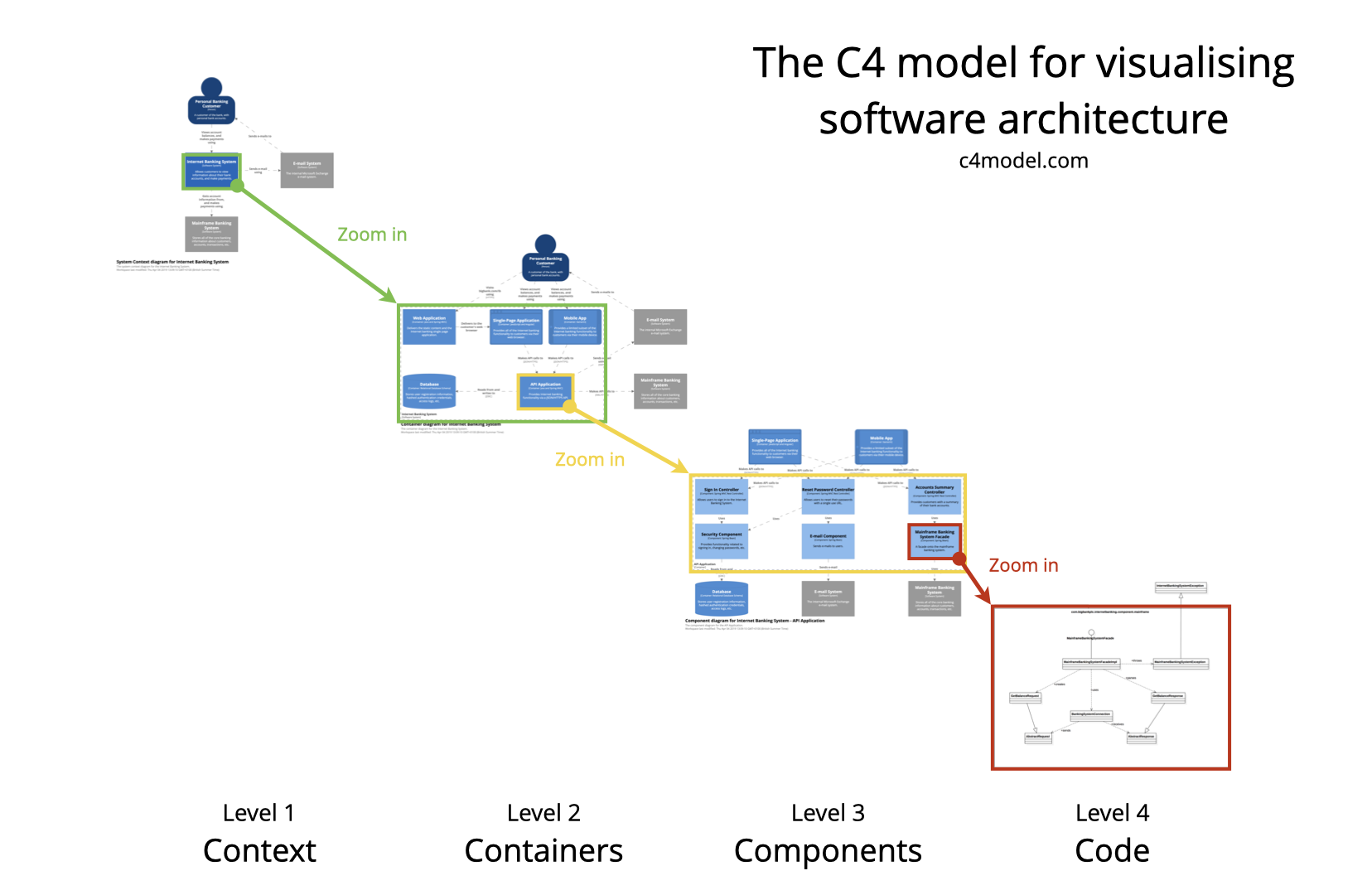

- C4-diagram: minstens een Context en Container diagram, inlcusief toelichting op elk, als documentatie van je Software Architectuur

- Architectuurbeslissingen in de vorm van ADR’s

- Specificaties in de vorm van given-when-then’s (Gherkin)

-

Je hebt zelf een beeld van je DevOps volwassenheid via een self assessment van het CDDM

- met een realistisch deelcijfer/niveau op elk van de 5 categorieën

- en per cijfer/categorie ook eigen toelichting* over hoe je 'checkpunten' hebt gehaald en waar dit zichtbaar is in eigen werk (of (net) niet hebt behaald (wellicht met goede reden),

- Opleveren: Een overzicht van de (runtime) omgevingen, hoe ze zijn ingericht, en beheerd worden (incl. de koppeling met versiebeheer).

E. Soft skills

- 🧑🤝🧑 Culture & Organization

- Je werkt prettig samen met de opdrachtgever en geeft een professionele indruk

- Je werkt goed samen als team en creëert een goede werksfeer

- Je valt de opdrachtgever niet lastig met technische details, maar kunt issues en werkzaamheden vertalen naar bedrijfstermen

- Je schermt als team de opdrachtgever af van kleine afwijkingen van de planning

- Maar bij grote(re) tegenslagen communiceer je tijdig, zodat opdrachtgever kan meedenken over alternatieve richtingen

- Bij extra tijd en evt. opraken van werk denk je pro actief mee met business over mogelijk waardevolle features

Extra details 2025 Sprints

Deze sectie beschrijft de high-level Way of Working tijdens het project: hoe je door middel van gestructureerde reviews bewijs levert voor de beoordelingscriteria A t/m E hierboven.

Tijdens het project vinden er 4 Tech Reviews en 4 Sprint Reviews plaats. Deze reviews zijn gekoppeld aan de beoordelingscriteria A t/m E en helpen je om je DevOps-volwassenheid te tonen en te ontwikkelen.

I. Tech Reviews

Tech reviews vinden plaats om de week (eind week 1, 3, 5, 7) en richten zich op technische DevOps-vaardigheden. Iedere Tech Review heeft een kernopdracht en een groeidoel. Lever bewijs aan in documentatie, pipeline, K8S config of dashboards (alles in repo).

| Moment | Week | Tech review – kernopdracht | Groeidoel / verdieping |

|---|---|---|---|

| Tech review 1 | Week 1 | App basis, pipeline ingericht en productieomgeving -> GitOps-werkwijze aantonen; CI-pipeline met build/test/artefact; minimaal één front-end en back-end op Kubernetes | Codekwaliteit borgen: linting en/of statische analyse, kwaliteitsplatform naar keuze |

| Tech review 2 | Week 3 | Staging+productie, CD werkt+BODA Container registry gebruiken; pipeline bouwt image en geautomatiseerde deploy; parametrisatie voor meerdere omgevingen | Versiebeheer op images (semver/auto-tagging) |

| Tech review 3 | Week 5 | Performance- en/of loadtesten -> Met K6 o.i.d.; realistisch end-to-end scenario uit domein | Tijdelijke testomgeving automatisch opzetten/afbreken; pipeline-stap voor perftest |

| Tech review 4 | Week 7 | Observability & Resilience -> Verplicht: Observability/monitoring-stack (combineer applicatie- en platform-metrics) én Chaos Engineering (testen van fouttolerantie en resilience). Optioneel aanvullend: Onderzoeken én toepassen van specifieke K8S/CNCF tech of andere relevante technologieën die nuttig is binnen het project. Denk aan RabbitMQ clustering, custom applicatie specifieke metrics en/of gebruik ELK i.p.v. Grafana of andere Observability tools, sharding/duplication of database server (readonly copy e.d.), MCPS omgeving features, Azure DevOps features, security: verder afsluiten/hardening van productie omgeving, risico gebaseerde handmatige tests, duidelijker onderscheid maken tussen health check en liveness endpoints in K8S met realistische invulling, of andere project-specifieke tech) | Per teamlid kan er ook een persoonlijke verdieping zijn in een specifieke technologie die relevant is voor het project; alternatieve observability (bijv. logaggregatie of tracing); healthchecks en schaalgedrag aantonen |

Video: Tech Review 3 – loadtesten (NotebookLM)

Korte toelichting (punten om te behandelen in TR3):

- Welk type loadtest heb je? Welke gebruikersscenario’s test je?

- Aantal gelijktijdige gebruikers dat je applicatie minimaal/maximaal aankan.

- Bottlenecks: waar zit de beperking? Hoe meet je dat? Wat is de follow-up?

- Testbeperkingen en aanvullende nuttige tests.

- Vooruitblik TR4: welke tech/onderzoek per teamlid?

Belangrijk: Dit is voorlopige planning die een goed handvat geeft, maar tech moet zoveel mogelijk in dienst staan van de opdracht (demand pull over technology push). Buiten het vaste kader van 'MSA in K8S op Azure' kan deze planning tijdens het project op basis van input van opdrachtgever/InfoSupport nog bijgewerkt worden.

Koppeling met beoordelingscriteria:

- A. Technologie: Bewijs per tech review van GitOps-werkwijze, CI/CD-pipelines, container registry, deployment tooling, monitoring/performance tooling, chaos engineering, en/of specifieke CNCF/project-relevante technologieën (tooling naar keuze)

- C. Build en Deployment: CI/CD met build, test, artefact push, geautomatiseerde deploys, GitOps-triggers, performance-teststage en tijdelijke omgevingen

- D. Documentatie: Dashboards, testresultaten en review-logboek per sprint (opdracht + evt. groeidoelen)

Opmerking: De tooling is naar keuze; de focus ligt op het aantonen van de DevOps-principes en werkwijzen, niet op specifieke tools. Overleg met je begeleiders als je alternatieve tooling wilt gebruiken.

II. Sprint Reviews

Sprint reviews vinden plaats aan het einde van iedere sprint (onderwijsweek 2, 4, 6, en 8) bij de opdrachtgever/Product Owner. In tegenstelling tot Tech reviews hebben Sprint reviews geen vaste indeling van onderwerpen, maar richten zich op de functionele voortgang en afstemming met de opdrachtgever.

In de andere week (niet de sprint review week) is er een Teams video call met de opdrachtgever voor het stellen van vragen en korte afstemming.

Koppeling met beoordelingscriteria:

- B. Way of Working: Scrum-ritme over 4 sprints met planning, review, retro en statusupdates aantoonbaar (artefacts, acties, groeiopdrachten). User story map bijhouden en refinement van user stories.

- E. Soft skills: Samenwerking met PO, InfoSupport en HAN; actieve voorbereiding reviews, reflectie op groeidoelen en professionele communicatie. Vertalen van technische zaken naar bedrijfstermen.

III. Aandachtspunten per sprint

Per sprint ben je met onder andere onderstaande zaken bezig. Deze aandachtspunten zijn een hulpmiddel, kijk zelf naar de acceptatiecriteria/werkwijze A t/m E hierboven. Qua tonen van gemaakt werk/bespreken aandachtspunten tijdens de Tech review vs. Sprint review moet je hier zelf goed over nadenken. Wie is de doelgroep. Het indelen van de punten uit het volgende lijstje hieronder hoort bij beoordelingscriterium E3.

-

Sprint 1:

- User Story Map en Domein Model opstellen

- C4 Context model

- Opzet applicatie met front-end en back-end en message bus

- Evt. wireframes + API design

- CI/CD pipeline opzetten

- Individuele verantwoording (tenminste template hebben staan)

- Template van CDMM staat er en vindbaar vanuit root README

- Opzet ADR's

-

Sprint 2:

- C4 Container en meerdere Component diagrammen

- Pipeline verbeteren (beter CD-stuk)

- Evt. linting toevoegen + styleguides

- Overzicht van omgevingen opstellen (zie D3)

- Evt. code diagrammen: class diagrams, data model/database schema (waar relevant voor je domein)

- Refinement van user stories in acceptatiecriteria

- Afstemming van user stories op basis van feedback van opdrachtgever/PO en projectbegeleiders

- Individuele verantwoording (template teksten weg, 1e helft van bullets per kopje, max 2 van 9 kopjes nog leeg)

- CDMM voor ca. helft ingevuld en idee van hoe in volgende sprints naar Voldoende of hoger

- Retrospective notulen/uitkomsten

-

Sprint 3:

- Alles verder uitbreiden

- Documentatie van pipeline maken

- Meer ADR's toevoegen

- Acceptatiecriteria verder uitwerken

- README's inrichten

- C4-documentatie bijwerken

- Evt. code diagrammen bijwerken/uitbreiden (class diagrams, data model, sequence diagrams waar relevant)

- Performance/load tests implementeren (K6 of vergelijkbaar) met realistische end-to-end scenario's

- Evt. UML sequence diagrams van kritieke flows en/of load test scenario's

- Overzicht van omgevingen bijwerken

- Bij begeleiders voorstel doen of uitvragen nieuw te gebruiken technologieën in Sprint 4 (per teamlid één technologie)

- Refinement van user stories

- Individuele verantwoording bijgewerkt

- Retrospective notulen/uitkomsten

-

Sprint 4:

- Alles verder uitbreiden en afronden

- Documentatie compleet maken (pipeline, ADR's, README's)

- Meer ADR's toevoegen voor gemaakte keuzes

- Onderzoek en implementatie van gekozen technologieën (per teamlid één: monitoring, chaos engineering, of andere relevante tech die bijdraagt aan het project)

- Evt. BDD/Gherkin tests:

.featurebestanden met acceptatietests (Cucumber, SpecFlow, Req'n'Roll o.i.d.) - Acceptatiecriteria finaliseren

- C4-documentatie compleet maken

- Evt. code diagrammen compleet maken (class diagrams, data model, sequence diagrams waar relevant)

- Performance/load test resultaten en analyse documenteren

- Overzicht van omgevingen compleet maken

- Individuele verantwoording afgerond

- Retrospective notulen/uitkomsten

Toelichting

Merk op dat de punten onder de beoordelingscriteria A. Technologie, B. Way of Working, C. Build en Deployment, D. Documentatie en E. Soft skills grofweg knock-outs zijn van het minimale verwachte werk, de te gebruiken werkwijze en de op te leveren zaken (deliverables).

De Tech Reviews en Sprint Reviews hierboven geven aan hoe je tijdens het project gestructureerd bewijs levert voor deze criteria. Voor het komen tot een concreet cijfer kijken begeleiders naar de hoeveelheid (kwantieit) en de kwaliteit van met team gemaakte product, en ook omgang en goed hanteren van Agile proces en samenwerken als team. Bedenk hierbij dat het gemaakte product een DevOps product is, dus focus niet alleen op code en functionaliteit, maar toon DevOps volwassenheid. Andersom, focus je niet alleen op pipelines, build bakeries etc. maar maak ook een product, want zonder features en requirements heb je geen DevOps nodig.

Retrospective notulen/uitkomsten: Bij elke sprint hoort een retrospective waarbij je notulen/uitkomsten vastlegt. Wissel hierbij bijvoorbeeld af tussen sterke en zwakke punten van het team (bijv. met SWOT of Sails methode) en individuele tips en tops op voor de volgende retro. Of het liefst altijd beiden natuurlijk, maar bepaal zelf wat het meest nuttig is en niet alleen overhead geeft.

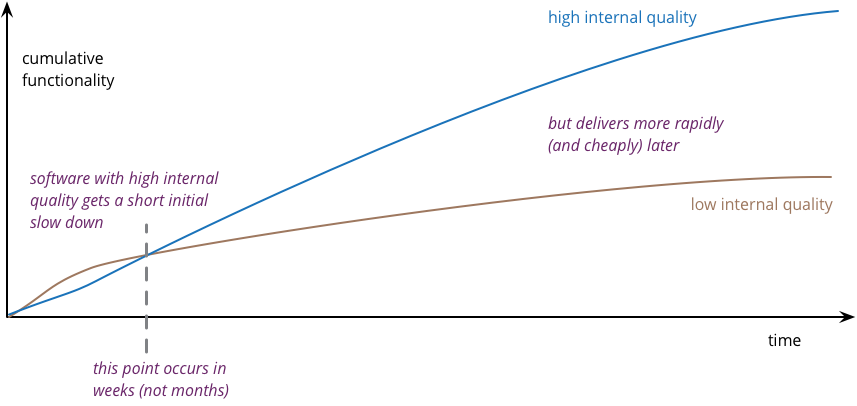

Hoe naar ruim voldoende, goed, of hoger?

Voor het aantonen van hogere 'Devops volwassenheid' (en dus eindcijfer boven een 6) moet je — net als in de coursefase — het CDMM er weer bij pakken en naast de Basis, Beginner en Gemiddeld ook naar de hogere checkpunten kijken, Gevorderd en Expert. De XX-30X en XX-40X checkpoints en jezelf hiermee assessen. Hou het niet bij alleen afvinken, maar beargumenteer per checkpunt onder de verschillende niveaus van de beoordelingscriteria waarom je het wel of niet of deels hebt. Om je beschrijving enigszins kort te houden helpt het wel om ook te linken naar concreet werk in je code management systeem. Dus neem een link op maar denk ook aan een goede linktekst vergelijkbaar met hoe je dit in individuele fact sheet doet.

Zeker bij de hogere punten XX-30X en XX-40X moet je — behalve zeggen DAT je het doet — ook uitleggen/beargumenteren HOE je hier dan aan voldoet. Voor het afvinken van deze criteria moet je ook 'bewust bekwaam' zijn en concreet aangeven welk werk jij en je team hebben gedaan. Anders kan een beoordelaar aanvoeren dat het een 'toevalstreffer is'. Ook is het zelden voldoende om te zeggen 'Dit checkpunt hebben we omdat we Tool X gebruiken'. Bijvoorbeeld 'Cross Silo analysis voldoen we aan omdat we Prometheus en Grafana gebruiken'. Geef of beschrijf in plaats daarvan een concreet scenario van een 'cross silo analysis' met deze tool. Lees ook de toelichting bij verschillende checkpoints in de 'lijst van devops concepten'.

Een goede redenering en argumentatie is dus nodig voor een goed cijfer. Je kunt ook een checkpunt afvinken, maar aangeven dat je er deels nog niet aan voldoet, maar wel een oplossingsrichting geven. Dus maai liever het gras voor de voeten weg van mogelijke kritiek of vragen door de beoordelaar, dan er over te zwijgen.

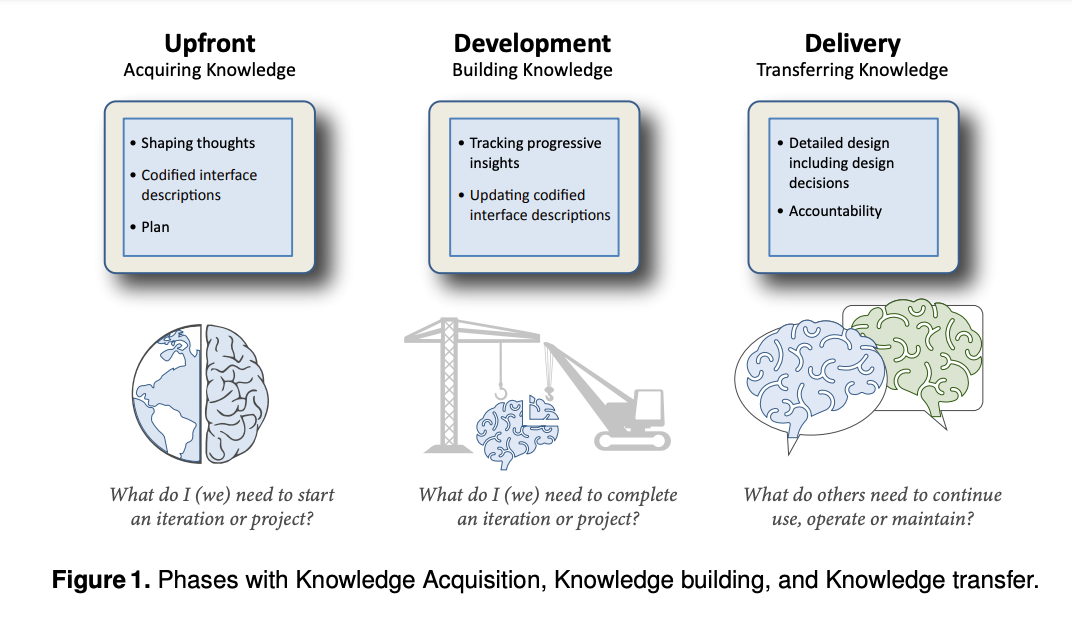

Figuur 1: Het Continuous Delivery Maturity Model van infoq.com

Merk overigens op dat het CDMM van InfoQ is, iets anders is dan InfoSupport. Als je zelf overigens een ander moderner, simpeler, passender of anderszins beter maturity model weten of vinden dan het CDMM uit de coursefase, dan kun je deze in overleg met de begeleiders ook gebruiken voor dit self assessment! Plumlogix' model is wat simpel en enkel 'cretologie' zonder onderscheid tussen niveaus, dus dit moet je allemaal zelf definiëren en beargumenteren. Het Nederlandse NISI heeft nog een recenter maturity model, CD3M genaamd, maar de term 'Continuous Intelligence' hierin is wellicht nog wat vaag. Het CDMM van InfoQ (feb 2013) is nog van (net) voor de tijd dat veel huidige DevOps tools ontstonden (bijvoorbeeld Docker (1.0 in maart 2013 uit dotCloud) of Kubernetes (2014, open-source versie onder de naam 'Borg') bestonden of gemeengoed waren). Zelfs microservices werden net iets later pas hot. Maar het CDMM bevatte conceptueel al wel heel veel zaken zoals een 'Build bakery' (dit idee zit in de base images uit Docker) en 'microservices' zijn de 'componenten' uit OA205: 'Modules omzetten naar componenten' (e.g. van modulaire monolith naar microservices, waar OA-101 'Systeem opsplitsen in modules' nog te zien is als de stap is van een niet-modulaire monoliet naar een wel-modulaire) monoliet.

Figuur 2: Een alternatief DevOps Maturity Model van plumlogix.com

Bronnen

- Porras, A. (2025, 23 oktober). How to Perform Load Testing on a Distributed System with k6. Geraadpleegd op 11-12-2025 via https://blog.4geeks.io/how-to-perform-load-testing-on-a-distributed-system-with-k6/

Domein Model, glossary naar DDD, Design thinking en meer

| Datum | Wijziging |

|---|---|

| 06-01-2026 | Quiz toegevoegd, Double Diamond sectie uitgebreid met ICT-documenten per diamond, link naar Design Council pagina en Jonathan Ball video toegevoegd, Einstein plaatje toegevoegd, figuren hernummerd. |

| 18-11-2025 | Uitbreiding met subset relatie tussen probleem- en oplossingsdomein, privacy by design en koppeling aan DDD/Design Thinking. Toevoeging van leeswijzer, sectienummers, opdrachten voor eigen casus, korte uitwijding over ethische aspecten en uitleg over doelgroep (niet-technische stakeholders). |

Deze workshop behandelt het opstellen van een domein model bij de start van een software development project. Het domein model past goed bij methoden als Domain-Driven Design (DDD), maar sluit ook aan bij Design Thinking, die bv. ook Media Design professionals gebruiken. Beide benadrukken het belang van eerst een probleem goed begrijpen voordat je naar oplossingen kijkt. Je leert het onderscheid tussen probleemdomein en oplossingsdomein, en hoe je een domein model kunt vertalen naar software-architectuur. Tussendoor komt ook ethische overweging aan bod: niet alles wat je kunt opslaan, moet je ook opslaan (privacy-by-design).

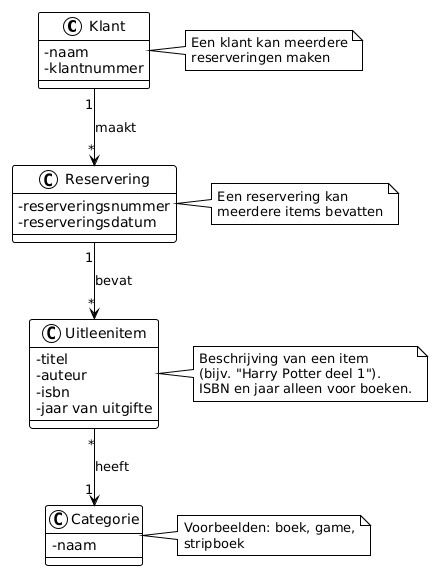

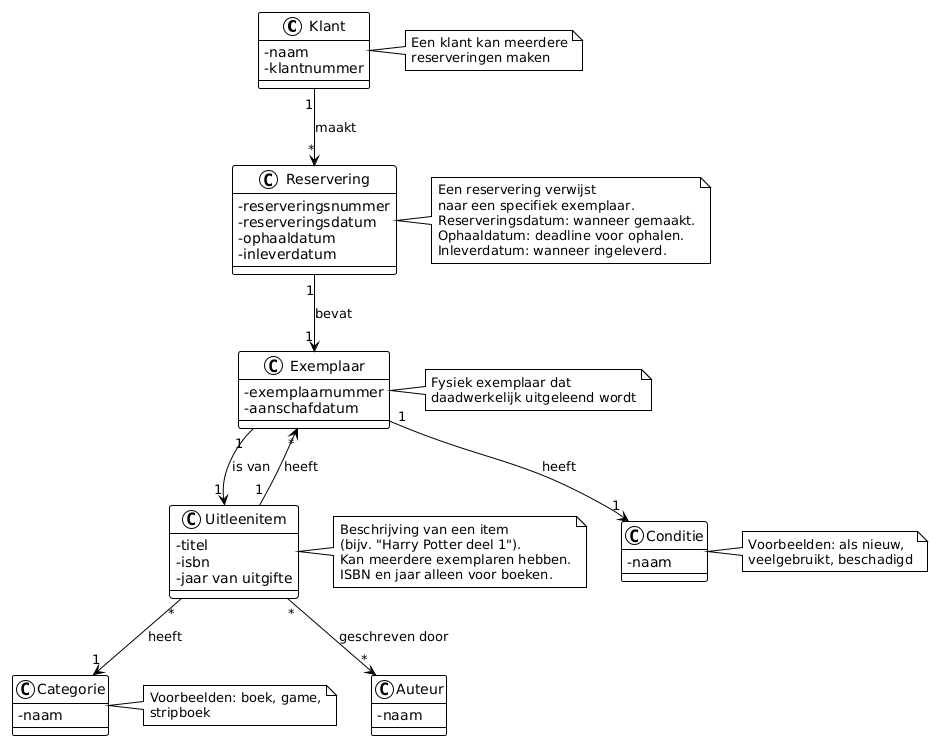

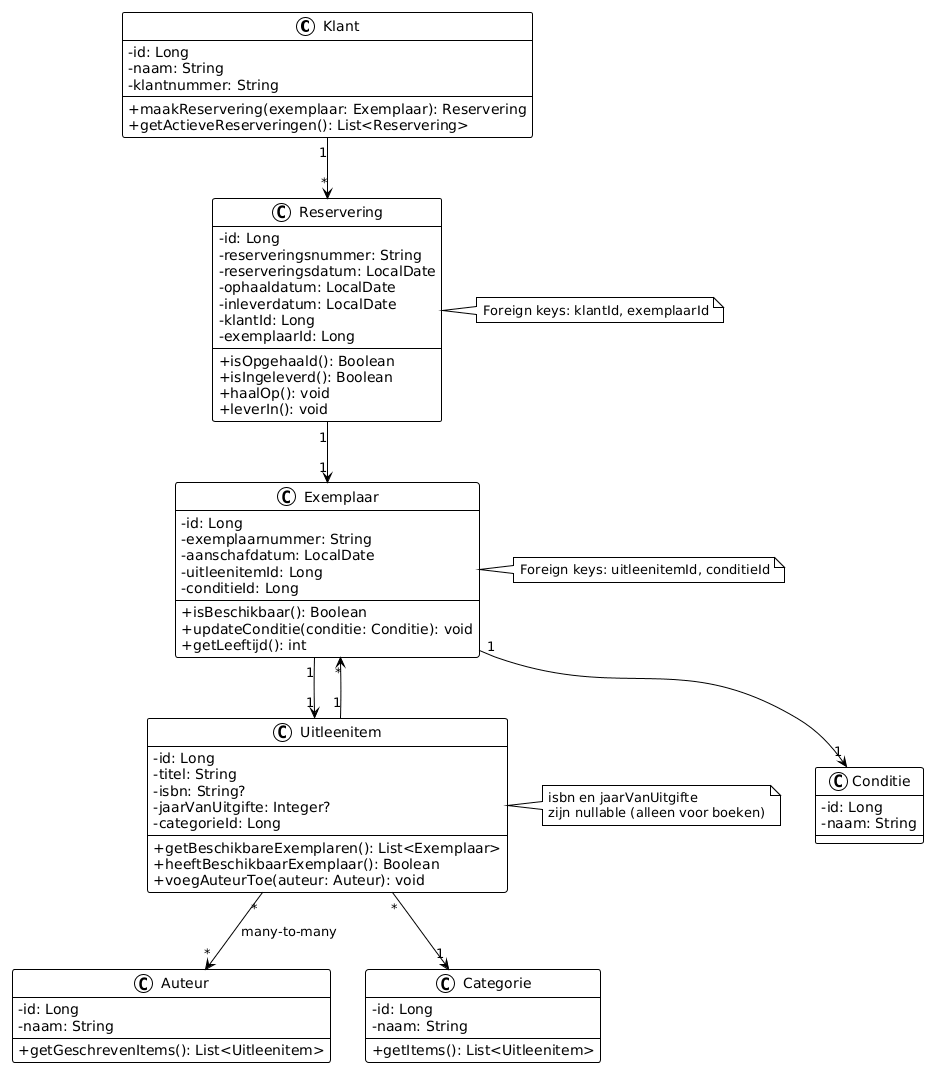

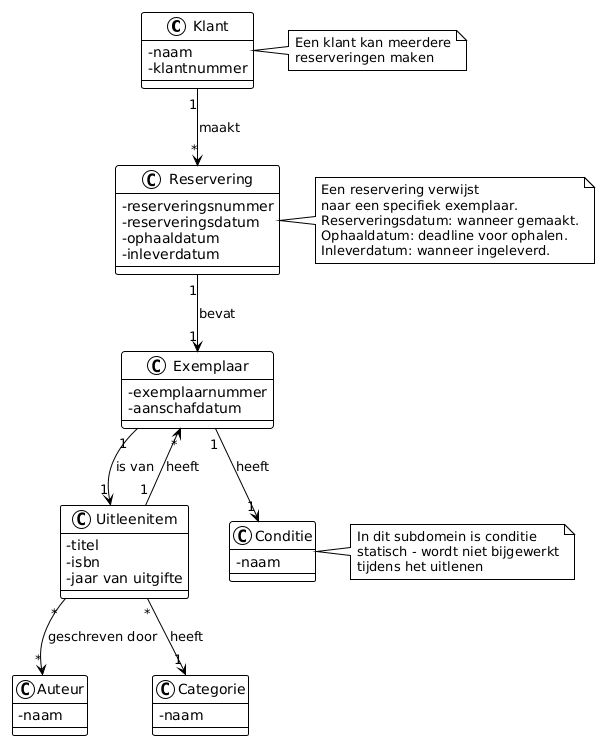

We behandelen een uitgebreide casus over een bibliotheeksysteem met verschillende varianten van domeinmodellen als voorbeeld. Belangrijk: Pas deze theorie toe op je eigen projectcasus. Sectie 1 geeft een inleiding over het domein model en de glossary, sectie 2 behandelt het conceptuele onderscheid tussen probleem- en oplossingsdomein, sectie 3 gaat over datatypes en terminologie, sectie 4 behandelt subdomeinen en bounded contexts, sectie 5 bevat concrete voorbeelden van domeinmodellen voor de bibliotheek casus, sectie 6 geeft kwaliteitscriteria in de vorm van een checklist, en sectie 7 biedt verdieping voor wie verder wil lezen.

"If I had an hour to solve a problem, I'd spend 55 minutes thinking about the problem and five minutes thinking about solutions." — Albert Einstein

1. Inleiding

Bij de start van het project (kick-off en eerste sprint) is het belangrijk om het domein goed te begrijpen. Daarom wordt er in de eerste sprint een domein model opgesteld, samen met een glossary (woordenlijst).

Een domein model is een visuele representatie van de belangrijkste concepten, entiteiten en hun relaties binnen het probleemdomein. Het is primair een communicatiemiddel, niet een tussenstap in het ontwerp. Larman (2004) noemt het ook wel een "visual dictionary". Het helpt het team om een gedeeld begrip te ontwikkelen van de businesslogica. Na validatie met niet-technische stakeholders vormt het de basis voor de software-architectuur. De glossary is een tabel met belangrijke termen uit het domein en hun uitleg, wat helpt om ambiguïteit te voorkomen en een gemeenschappelijke taal te ontwikkelen.

Belangrijk: Domeinmodellen moeten klein en overzichtelijk blijven. In Larman's boek staan alleen maar kleine diagrammen - dit is bewust, niet omdat Larman niet kan modelleren. Modellen zijn ook voor mensen met beperkte (cognitieve) capaciteit.

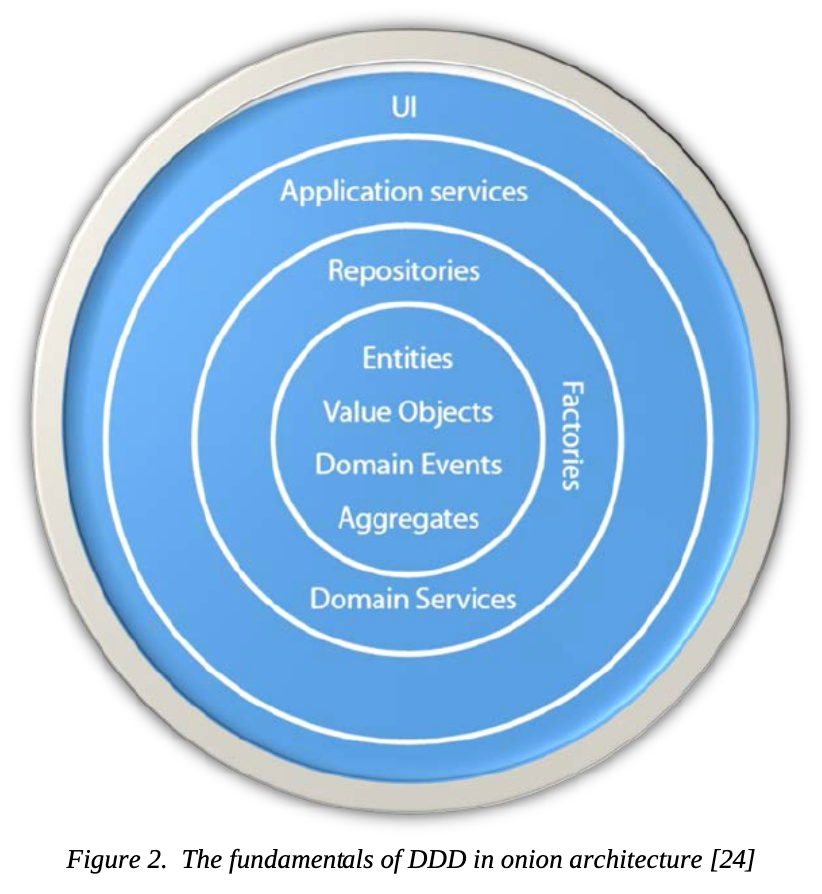

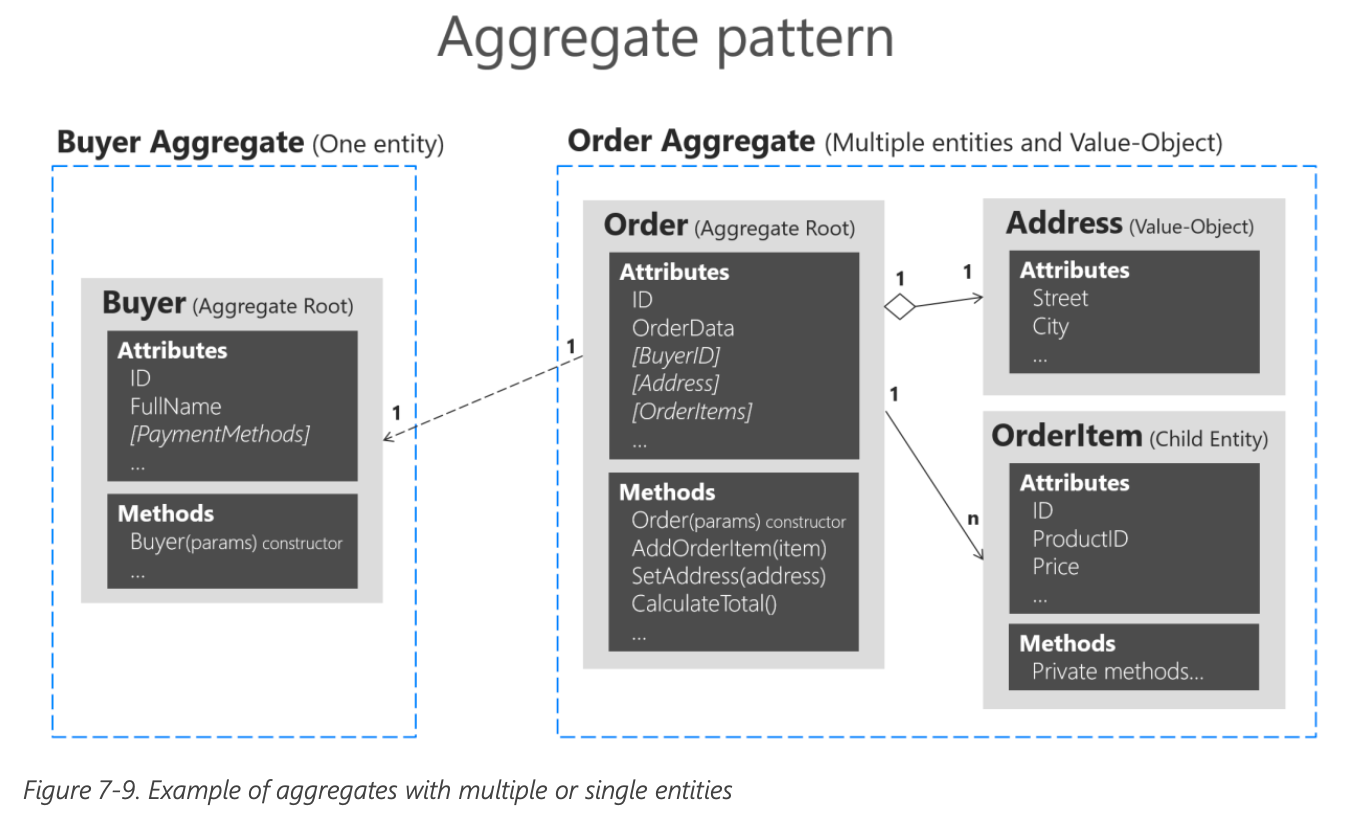

Als het model te groot wordt, kun je het opsplitsen in subdomeinen volgens Domain-Driven Design (DDD) principes. Studenten die DDD patterns zoals Aggregate hebben gehad, kunnen hier ook naar vooruit denken bij het opsplitsen in subdomeinen. Een domein model ter grootte van een A4-vel is de maximale grootte om te lezen en te bespreken.

Figuur 1: Domain-Driven Design (DDD) Strategic Design Patterns - Ubiquitous Language, Bounded Context en Context Mapping (Lambrych, 2024).

Zie ook sectie 4 voor uitleg over subdomeinen en bounded contexts, en criterium DM-6 voor meer informatie over Context Mapping.

Let op: Het domein model bevindt zich in het probleemdomein, niet in het oplossingsdomein. Het gaat om de concepten en relaties in de business/wereld, niet om software classes of models in de code. Het domein model helpt om het probleem te begrijpen voordat je naar de oplossing (software) kijkt. Uiteraard is er wel een relatie tussen het probleemdomein en het oplossingsdomein te maken. In de Realisatie fase kun je nog wel een domain layer met models/entities maken en een DB datamodel opstellen (bijvoorbeeld in je Software Guidebook), waarin stukken uit het domein model terug te vinden zijn.

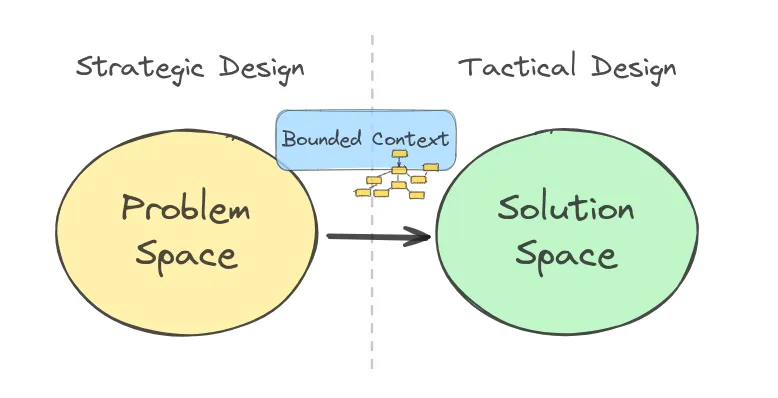

2. Probleem- vs. oplossingsdomein - Subset relatie

Het oplossingsdomein is vaak een subset van het probleemdomein (zie verzamelingenleer: een subset is een deelverzameling waarbij alle elementen van de subset ook in de oorspronkelijke verzameling zitten). Dit betekent dat niet alle concepten en attributen uit het probleemdomein automatisch in het oplossingsdomein terechtkomen.

2.1 Voorbeeld: Klant entiteit

Bijvoorbeeld, een Klant in het probleemdomein heeft mogelijk veel meer eigenschappen dan nodig zijn voor de software:

- Naam en klantnummer → wel nodig in oplossingsdomein

- Favoriet boekentype (bijvoorbeeld "science fiction" of "thriller") → mogelijk niet nodig voor MVP, maar kan later worden toegevoegd voor personalisatie

- Speelcomputer type (bijvoorbeeld "Nintendo", "PlayStation" of "PC") → bepaalt welk type games de klant typisch leent, maar mogelijk niet nodig voor eerste versie

- Geslacht (hij/zij/anders) → niet nodig voor functionaliteit, en vanuit privacy by design principe slaan we dit niet op tenzij er een goede reden is (bijvoorbeeld voor gepersonaliseerde aanhef in brieven/e-mails bij overschreden leenlimiet)

Deze "kandidaatvelden" kunnen in latere sprints/releases worden toegevoegd via extra features, maar worden bewust weggelaten in de eerste versie om het model simpel te houden en privacy te beschermen.

2.2 Ethische overwegingen: wenselijkheid van data opslag

Hoewel met de uitbreiding van opslagcapaciteit jarenlang ook veelal zoveel mogelijk data in applicaties lieten opslaan, met het motto "baat het niet dan schaadt het niet" of "We zien later wel wat we met de data doen" is dit sinds een aantal jaar aan het veranderen. Bij het kiezen wat je wel of niet implementeert, speelt niet alleen technische haalbaarheid of functionele noodzaak een rol, maar ook ethische overwegingen. Dit sluit aan bij de HAN speerpunten slim, schoon en sociaal:

- Slim: Technisch gezien kun je veel data verzamelen en analyseren, maar dat betekent niet dat je dat ook moet doen

- Schoon: Door alleen noodzakelijke data op te slaan, voorkom je onnodige complexiteit en potentieel misbruik

- Sociaal: Het beschermen van privacy en voorkomen van discriminatie en profilering is een maatschappelijke verantwoordelijkheid

Dus niet alles wat je kunt meten, moet je ook willen opslaan. Denk kritisch na over de gevolgen van het verzamelen en gebruiken van data, vooral wanneer dit kan leiden tot profilering of discriminatie van gebruikers.

Figuur 2: Probleemdomein vs Oplossingsdomein — het oplossingsdomein bevat een subset van de concepten uit het probleemdomein (Lambrych, 2024).

NB: We hebben de inkleuring in figuur 2 aangepast in lijn met Figuur 1: geel voor probleemdomein, groen voor oplossingsdomein.

📋 PlantUML Code - Probleemdomein vs Oplossingsdomein

@startuml

!theme plain

skinparam classAttributeIconSize 0

skinparam packageStyle rectangle

' Kleuren uit Lambrych figuur

skinparam package {

BackgroundColor<<problem>> #FFF1AD

BackgroundColor<<solution>> #C1F6C9

BorderColor #666666

}

skinparam class {

BackgroundColor<<problem>> #FFF1AD

BackgroundColor<<solution>> #C1F6C9

BorderColor #444444

}

package "Bibliotheek" <<problem>> {

class Klant <<problem>> {

- naam

- klantnummer

- favorietBoekentype

- speelcomputerType

- geslacht

}

class Uitleenitem <<problem>> {

- titel

- auteur

- isbn

- aantalPaginas

- taal

- uitgever

}

class Reservering <<problem>> {

- reserveringsnummer

- reserveringsdatum

- redenVoorReservering

- voorkeursdatum

}

Klant "1" --> "*" Reservering : maakt

Reservering "*" --> "*" Uitleenitem : bevat

}

package "Bibliotheek" <<solution>> {

class Klant <<solution>> {

- id: Long

- naam: String

- klantnummer: String

}

class Uitleenitem <<solution>> {

- id: Long

- titel: String

- isbn: String

}

class Reservering <<solution>> {

- id: Long

- reserveringsnummer: String

- reserveringsdatum: LocalDate

- klantId: Long

}

Klant "1" --> "*" Reservering : maakt

Reservering "*" --> "*" Uitleenitem : bevat

}

note bottom of "Bibliotheek"

Links: Probleemdomein - alle concepten

uit de echte wereld/business

Rechts: Oplossingsdomein - subset,

alleen wat nodig is voor de MVP

end note

@enduml

Glossary - Klant: Probleemdomein vs. Oplossingsdomein

| Attribuut | Voorbeeld | In MVP? | Toelichting |

|---|---|---|---|

| naam | "Jan de Vries" | ✅ Ja | Nodig voor identificatie van de klant |

| klantnummer | "BIB-2024-00142" | ✅ Ja | Unieke identificatie, nodig voor uitleenadministratie |

| favorietBoekentype | "science fiction", "thriller" | ❌ Nee | Niet nodig voor MVP, kan later worden toegevoegd voor personalisatie |

| speelcomputerType | "Nintendo Switch", "PlayStation 5" | ❌ Nee | Bepaalt welk type games klant typisch leent, maar niet nodig voor eerste versie |

| geslacht | "man", "vrouw", "anders" | ⚠️ Privacy | Niet nodig voor functionaliteit; privacy by design — alleen opslaan indien nodig voor gepersonaliseerde aanhef in communicatie |

Tabel: Vergelijking attributen Klant in probleemdomein vs. oplossingsdomein. Attributen met ✅ komen in de MVP, attributen met ❌ zijn kandidaten voor latere releases, en ⚠️ geeft privacy-gevoelige attributen aan.

Opdracht: Identificeer voor je eigen projectcasus minimaal drie entiteiten uit het probleemdomein. Voor elke entiteit, maak een lijst van attributen die:

- Wel nodig zijn in het oplossingsdomein (voor de MVP)

- Mogelijk niet nodig zijn voor de MVP, maar later kunnen worden toegevoegd

- Ethisch niet wenselijk zijn om op te slaan (bijvoorbeeld vanwege privacy by design)

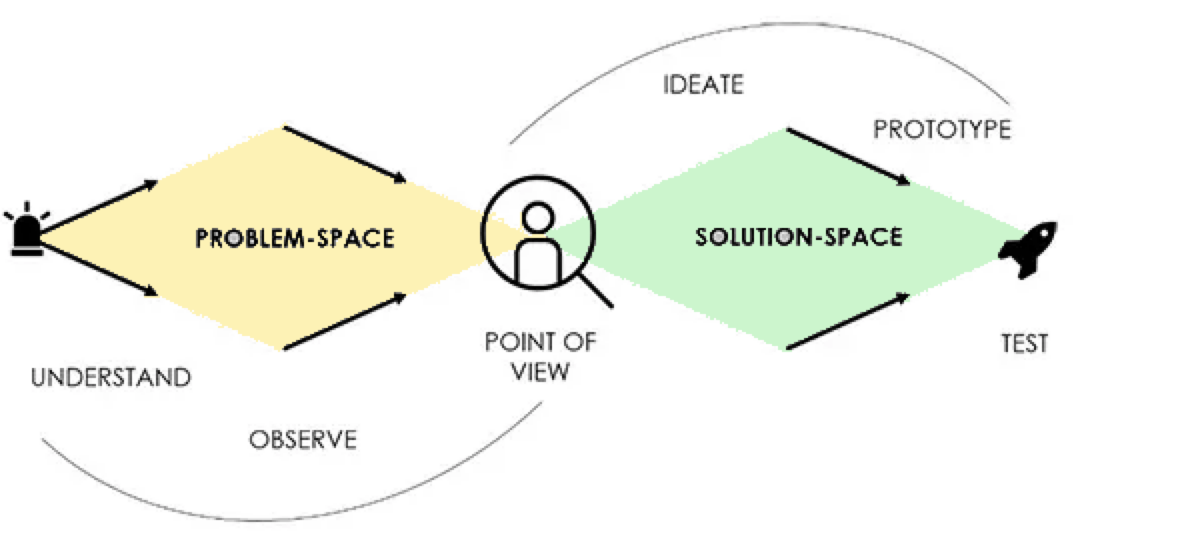

2.3 Design Thinking en de Double Diamond

Hoewel beginnende ICT'ers het belang van 'stilstaan bij het probleem' op basis van een quote van Einstein wellicht wel inzien (Figuur X), is in de praktijk toch de neiging om snel de code in te duiken, omdat hier ook nog allerlei technische uitdagingen en onbekendheden zijn. En ook omdat het probleemdomein heel simpel is. Een simpele opdracht als het 'FizzBuzz' drankspelletje, priemgetallen berekenen of de oppervlakte van verschillende figuren als een vierkant en driehoek berekenen, of een bekende casus in het onderwijs zoals een onderwijsadministratie met Student-Docent-Course-Cijfer e.d. Kortom 'academische problemen' of wellicht zelfs 'speelgoed domeinen' te noemen. In de praktijk zijn dit allemaal opgeloste problemen en is er vooral geld te verdienen als ICT met applicaties in complexe domeinen zoals het Verzekeringsdomein, of 'netbeheer' van electrische netwerken met heel veel business of organisatie logica.

Om nog even extra stil te staan is een mooie model dat vanDouble Diamond model uit Design Thinking. De kern hierin is een duidelijk onderscheid tussen probleemdomein en oplossingsdomein komt overeen met het

Dit model beschrijft twee fasen van divergeren (verbreden) en convergeren (vernauwen):

-

Probleemdomein (Problem Space) — de eerste diamond:

- Discover (divergeren): Verken het probleem breed, verzamel informatie

- Define (convergeren): Definieer het kernprobleem

- ICT-documenten: Domein model, glossary, requirements, SRS/user stories, (high level) use case model, of in Software Guidebook: Constraints, Context en C4 Context diagram

-

Oplossingsdomein (Solution Space) — de tweede diamond:

- Develop (divergeren): Verzin verschillende oplossingen

- Deliver (convergeren): Kies en implementeer de beste oplossing

- ICT-documenten: Software Architecture Document (SAD), Software Design Document (SDD), fully dressed use cases, of in Software Guidebook: Functional Overview, Code, Data, Deployment etc.

Let op: Er zijn verschillende varianten van design thinking. De Double Diamond gebruikt 4 fasen (Discover, Define, Develop, Deliver), terwijl andere modellen zoals die van Stanford d.school 5 fasen gebruiken: Empathize, Define, Ideate, Prototype en Test. Beide modellen hebben hetzelfde doel: eerst het probleem goed begrijpen voordat je naar oplossingen kijkt.

Tip: Zie voor meer informatie de officiële Double Diamond pagina van de Design Council (z.d.), waar ook een korte video staat waarin Jonathan Ball (een van de oorspronkelijke bedenkers) het model uitlegt.

Figuur 3: Double Diamond model - Probleemdomein (Problem Space) en Oplossingsdomein (Solution Space) (Gupta, 2019)

De take away van dit verhaal is dat je bij het maken van software een goede balans moet vinden tussen het probleem voldoende goed begrijpen (zodat je niet een ander probleem oplost dan de opdrachtgever bedoelde) en pragmatisch een zo simpel mogelijke oplossing realiseren (zodat je niet strandt in analysis paralysis of accidental complexity).

"Everything should be made as simple as it can be, but not simpler." — Albert Einstein

Opdracht: Verzin voor deze casus nog enkele velden uit het probleemgebied die wel in het probleemdomein voorkomen maar niet in het oplossingsdomein.

💡 Tip: Denk eerst zelf na voordat je de antwoorden bekijkt! Sleep met je muis over het blok hieronder (of tik en houd ingedrukt op mobiel) om de voorbeelden te zien.

Voorbeelden voor verschillende entiteiten

Klant:

- Leeftijd → niet nodig voor MVP, mogelijk later voor leeftijdsrestricties bij games

- Postcode → niet nodig voor MVP, mogelijk later voor statistieken of lokale promoties

- Email voorkeur (wel/niet nieuwsbrief) → niet nodig voor MVP, mogelijk later voor marketing

- Aantal kinderen → bepaalt mogelijk welke boeken klant leent, maar niet nodig voor eerste versie

Uitleenitem:

- BoekBeschadigScore (per klant) → een bibliotheek zou kunnen denken aan het bijhouden van een score per klant van hoeveel beschadigde boeken hij/zij inlevert, om bij inleveren meer te controleren. Dit is echter een vorm van profilering die kan leiden tot verkeerde conclusies en discriminatie (denk aan de misstanden bij de toeslagaffaire bij de Nederlandse belastingdienst). Zelfs al zou je dit technisch kunnen meten, is het ethisch niet wenselijk om dit te implementeren. Dit illustreert dat niet alles wat je kunt meten ook moet worden opgeslagen.

- Aantal pagina's → fysieke eigenschap die bestaat, maar niet nodig voor uitleenfunctionaliteit

- Taal (Nederlands, Engels, etc.) → bestaat in echte wereld, maar mogelijk niet nodig voor eerste versie

- Uitgever → bestaat in echte wereld, maar niet nodig voor uitleenfunctionaliteit

Exemplaar:

- Locatie in bibliotheek (bijv. "Rij 3, Plank B") → bestaat fysiek, maar mogelijk niet nodig voor eerste versie als alle exemplaren op één plek staan

- Aanschafprijs → financieel gegeven dat bestaat, maar niet nodig voor uitleenfunctionaliteit

- Laatste schoonmaakdatum → onderhoudsinformatie die bestaat, maar niet nodig voor MVP

Reservering: